Fortiden, Nåtiden Og Fremtiden For Google PageRank

PageRank-algoritmen (ELLER PR for kort) er et system for rangering av nettsider utviklet av Larry Page og Sergey Brin ved Stanford University på slutten av 90-tallet. PageRank var faktisk basissiden og Brin opprettet google-søkemotoren på.

Mange år har gått siden da, Og Selvfølgelig Har Googles rangeringsalgoritmer blitt mye mer kompliserte. Er De fortsatt basert På PageRank? Hvordan Påvirker PageRank rangering, og hva skal Seo gjøre seg klar for i fremtiden? Nå skal vi finne og oppsummere alle fakta og mysterier rundt PageRank for å gjøre bildet klart. Vel, så mye vi kan.

Fortiden Til PageRank

Som nevnt ovenfor, I deres universitetsforskningsprosjekt, Forsøkte Brin Og Page å oppfinne et system for å estimere autoriteten til nettsider. De bestemte seg for å bygge det systemet på lenker, som fungerte som stemmer av tillit gitt til en side. Ifølge logikken i denne mekanismen, jo flere eksterne ressurser lenker til en side, jo mer verdifull informasjon den har for brukerne. Og PageRank (en score fra 0 til 10 beregnet basert på kvantitet og kvalitet på innkommende lenker) viste relativ autoritet på en side på Internett.

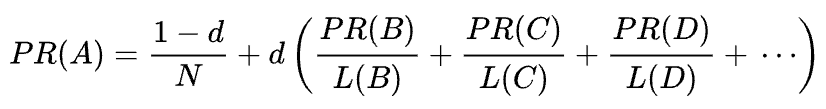

Original PageRank formel

La oss se på Hvordan PageRank fungerer. Hver lenke Fra en Side (A) til en Annen (B) kaster en såkalt stemme, hvis vekt avhenger av den kollektive vekten av alle sidene som lenker til Side A. Og vi kan ikke vite vekten før vi beregner den, så prosessen går i sykluser.

den matematiske formelen til den opprinnelige PageRank er følgende:

Hvor A, B, C Og D er noen sider, l er antall lenker som går ut fra hver av dem, Og N er totalt antall sider i samlingen (dvs.På Internett).

for d er d den såkalte dempningsfaktoren. Tatt I betraktning At PageRank beregnes simulere virkemåten til en bruker som tilfeldig kommer til en side og klikker koblinger, bruker vi denne demping d faktor som sannsynligheten for at brukeren blir lei og forlate en side.

som du kan se fra formelen, HVIS det ikke er noen sider som peker på siden, VIL PR IKKE være null, men

da det er en sannsynlighet for at brukeren kan komme til denne siden ikke fra noen andre sider, men si fra bokmerker.

pagerank manipulasjon sårbarhet og Googles krig mot link spam

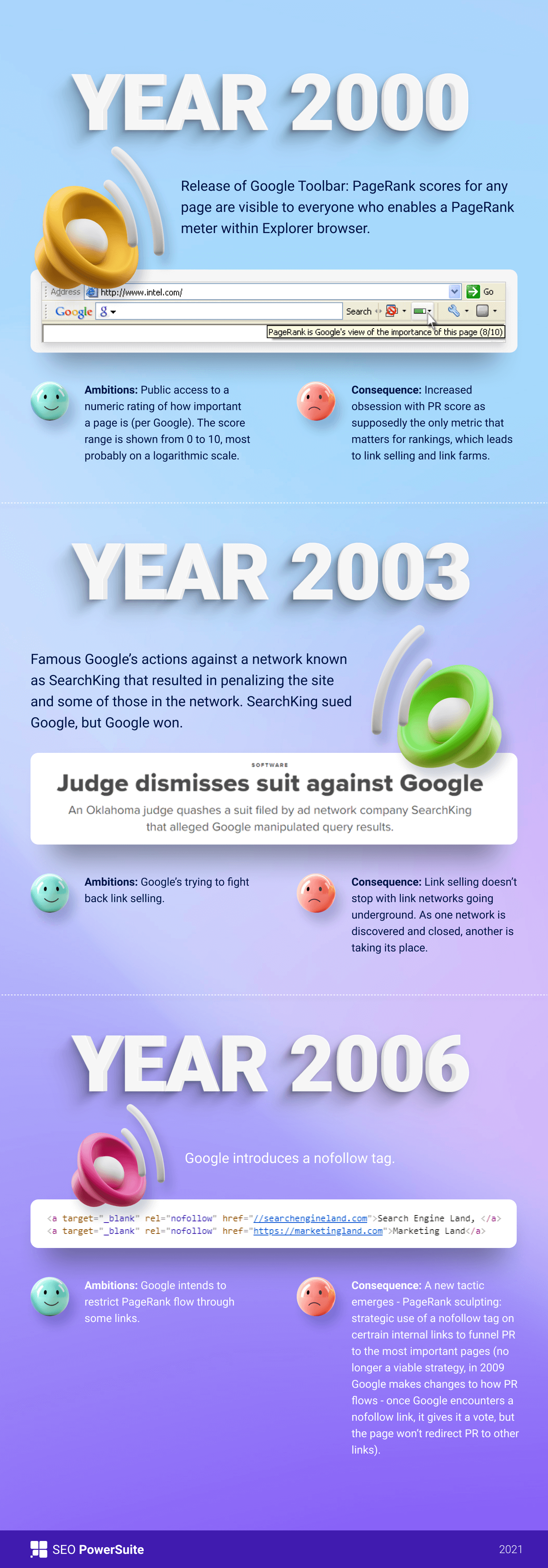

Først, PageRank score var offentlig synlig I Google-Verktøylinjen, og hver side hadde sin score fra 0 til 10, mest sannsynlig på en logaritmisk skala.

Googles rangeringsalgoritmer av disse tider var veldig enkle-høy PR og søkeordtetthet var de eneste to tingene en side trengte for å rangere høyt på EN SERP. Som et resultat, websider ble fylt med søkeord, og eiere begynte å manipulere PageRank av kunstig voksende spammy backlinks. Det var lett å gjøre-link gårder og link selge var der for å gi eiere en » hjelpende hånd.»

Google besluttet å bekjempe link spam tilbake. I 2003 straffet Google nettstedet til annonsenettverket SearchKing for link manipulasjoner. SearchKing saksøkte Google, Men Google vant. Det Var En Måte Google prøvde Å begrense alle fra link manipulasjoner, men det førte til ingenting. Link gårder bare gikk under jorden, og deres kvantitet multiplisert sterkt.

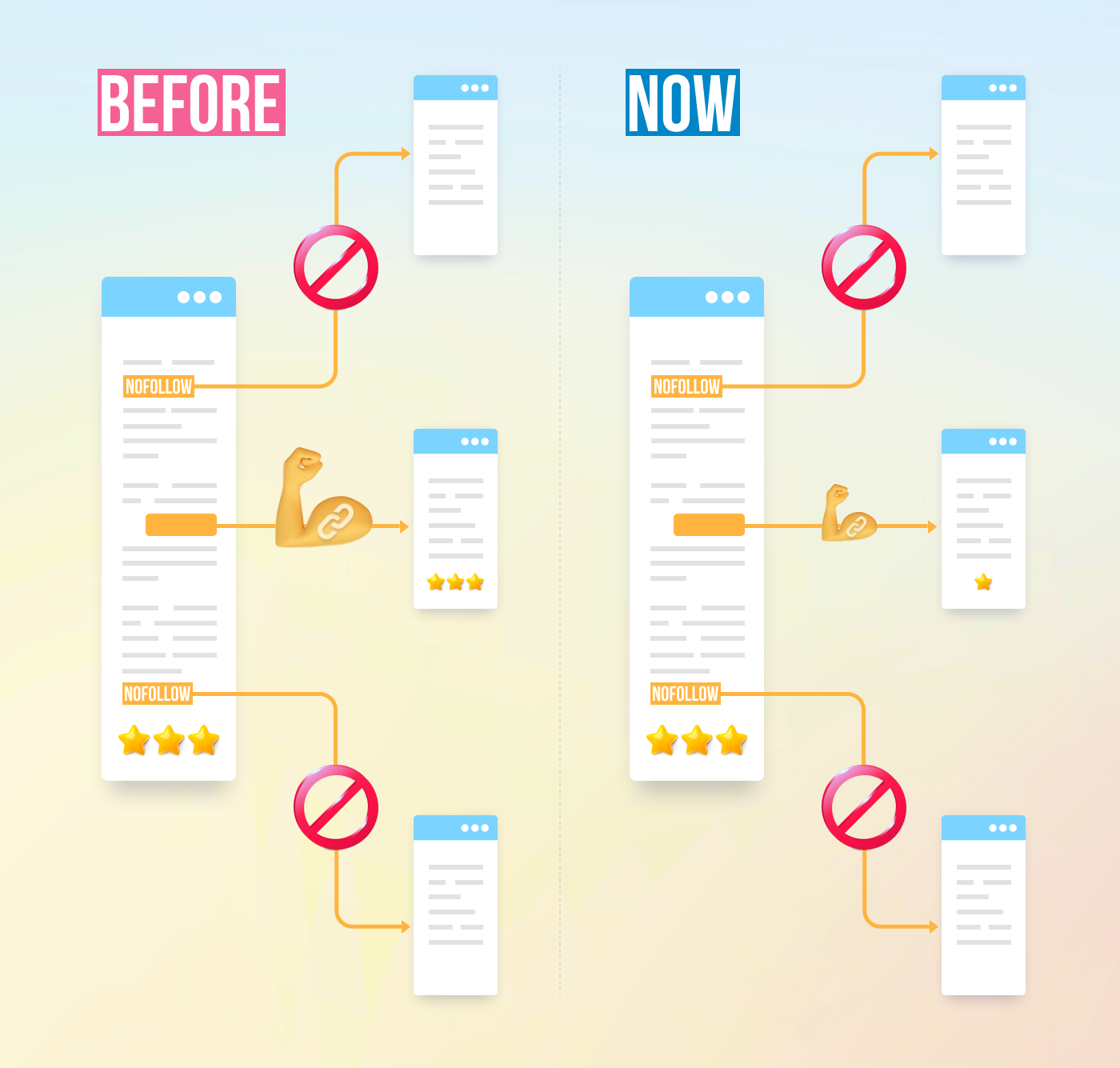

dessuten ble spammy kommentarer på blogger multiplisert også. Bots angrep kommentarene til Noen, Si WordPress-blogg og forlot enorme antall» klikk-her-for-å-kjøpe-magiske piller » kommentarer. For å forhindre spam og pr-manipulering i kommentarer, introduserte Google nofollow-taggen i 2005. Og Igjen, Hva Google mente å bli et vellykket skritt i link manipulation war ble implementert på en vridd måte. Folk begynte å bruke nofollow koder til kunstig trakt PageRank til sidene de trengte. Denne taktikken ble kjent Som PageRank sculpting.

For å forhindre pr-skulptur, endret Google Måten PageRank flyter på. Tidligere, hvis en side hadde både nofollow og dofollow-koblinger, ble ALT pr-volumet på siden sendt til andre sider knyttet til med dofollow-koblingene. I 2009 begynte Google å dele en sides PR likt mellom alle koblingene siden hadde, men passerte bare de aksjene som ble gitt til dofollow-koblingene.

Ferdig Med PageRank sculpting, google stoppet Ikke koblingen spam krig og begynte dermed å ta PageRank score ut av publikums øyne. Først lanserte Google Den nye Chrome-nettleseren uten Google-Verktøylinjen der PR-poengsummen ble vist. DERETTER sluttet de å rapportere PR-poengsummen I Google Search Console. Deretter Firefox nettleser sluttet å støtte Google Toolbar. I 2013 Ble PageRank oppdatert For Internet Explorer for siste gang, Og I 2016 stengte Google Offisielt Verktøylinjen for publikum.

En annen Måte Google brukte til å bekjempe koblingsordninger var Penguin update, som de-rangerte nettsteder med fishy tilbakekoblingsprofiler. Rullet ut i 2012, Ble Penguin ikke en del Av Googles sanntidsalgoritme, men var heller et «filter» oppdatert og brukt på søkeresultatene nå og da. Hvis et nettsted ble straffet Av Penguin, Måtte Seo nøye gjennomgå deres lenkeprofiler og fjerne giftige lenker, eller legge dem til en disavow-liste (en funksjon introduserte de dagene For Å fortelle Google hvilke innkommende lenker som skal ignoreres ved beregning Av PageRank). Etter revisjon link profiler på den måten, Seo måtte vente et halvt år eller så før Penguin algoritmen beregner dataene.

I 2016 gjorde Google Penguin en del av sin kjernerangeringsalgoritme. Siden da har det jobbet i sanntid, algoritmisk håndtere spam mye mer vellykket.

Samtidig jobbet Google med å legge til rette for kvalitet i stedet for kvantitet av lenker, og spikret det ned i kvalitetsretningslinjene mot lenkeordninger.

nåtiden Av PageRank

Vel, vi er ferdige med Fortiden Av PageRank. Hva skjer nå?

Tilbake I 2019 sa En Tidligere Google-ansatt at Den opprinnelige PageRank-algoritmen ikke hadde vært i bruk siden 2006 og ble erstattet med en annen mindre ressurskrevende algoritme da Internett ble større. Som kan godt være sant, som I 2006 google arkivert den nye Produsere en rangering for sider ved hjelp av avstander i en web-link graf patent.

Brukes PageRank-algoritmen i dag?

Ja, det er det. Det er ikke Den Samme PageRank som det var tidlig på 2000-tallet, Men Google fortsetter å stole på link authority tungt. For eksempel nevnte En tidligere Google-ansatt Andrey Lipattsev dette i 2016. I En google Q&en hangout spurte en bruker ham hva Som var de viktigste rangeringssignalene Som Google brukte. Andreys svar var ganske greit.

jeg kan fortelle deg hva de er. Det er innhold og koblinger som peker til nettstedet ditt.

Andrey Lipattsev

I 2020 bekreftet John Mueller det igjen:

Ja, Vi bruker PageRank internt, blant mange, mange andre signaler. Det er ikke helt det samme som det originale papiret, det er mange quirks(f. eks.), og igjen bruker vi mange andre signaler som kan være mye sterkere.

John Mueller

Som du kan se, Er PageRank fortsatt i live og aktivt brukt Av Google når du rangerer sider på nettet.

det som er interessant Er At Google-ansatte stadig minner oss om at Det er mange, mange, MANGE andre rangeringssignaler. Men vi ser på dette med et saltkorn. Med tanke på Hvor mye Innsats Google viet til å bekjempe link spam, kan Det Være Av Googles interesse å slå Seo ‘ oppmerksomhet av manipulasjons-sårbare faktorer (som tilbakekoblinger er) og drive denne oppmerksomheten til noe uskyldig og fint. Men Som Seo er gode til å lese mellom linjene, fortsetter De Å vurdere PageRank et sterkt rangeringssignal og vokse tilbakekoblinger alle måtene de kan. De bruker Fortsatt PBNs, praktiserer noen gråhatt – lagdelt lenkebygging, kjøper lenker og så videre, akkurat som det var lenge siden. Som PageRank liv, link spam vil leve, også. VI anbefaler ikke noe AV DET, MEN DET ER HVA SEO virkeligheten er, og vi må forstå det.

Tilfeldige Surfer vs Rimelige Surfer modeller Av PageRank

vel, du fikk ideen Om At PageRank nå ikke Er PageRank det var 20 år siden.

en av de viktigste moderniseringer AV PR var å flytte fra kort nevnt Ovenfor Tilfeldig Surfer modellen Til Rimelig Surfer modellen i 2012. Rimelig Surfer antar at brukerne ikke oppfører seg kaotisk på en side, og klikker bare på de koblingene de er interessert i for øyeblikket. Si, å lese en bloggartikkel, du er mer sannsynlig å klikke på en lenke i artikkelens innhold i stedet for En Bruksvilkår i bunnteksten.

I Tillegg Kan Rimelig Surfer potensielt bruke et stort utvalg av andre faktorer når man vurderer en link attraktivitet. Alle disse faktorene ble nøye gjennomgått Av Bill Slawski i sin artikkel, men jeg vil gjerne fokusere på de to faktorene, som Seo diskuterer oftere. Dette er link posisjon og side trafikk. Hva kan vi si om disse faktorene?

Korrelasjon mellom lenkeposisjon og lenkeautoritet

en lenke kan være plassert hvor som helst på siden — i innholdet, navigasjonsmenyen, forfatterens bio, bunntekst og faktisk ethvert strukturelement siden inneholder. Og forskjellige koblingssteder påvirker koblingsverdien. John Mueller bekreftet at, sier at koblinger plassert i hovedinnholdet veie mer enn alle de andre:

Dette er området på siden der du har ditt primære innhold, innholdet som denne siden faktisk handler om, ikke menyen, sidepanelet, bunnteksten, overskriften… så det er noe vi tar hensyn til, og vi prøver å bruke disse koblingene.

John Mueller

så, bunntekst lenker og navigasjonskoblinger sies å passere mindre vekt. Og dette faktum fra Tid til annen blir bekreftet ikke Bare Av Google talsmenn, men av virkelige saker.

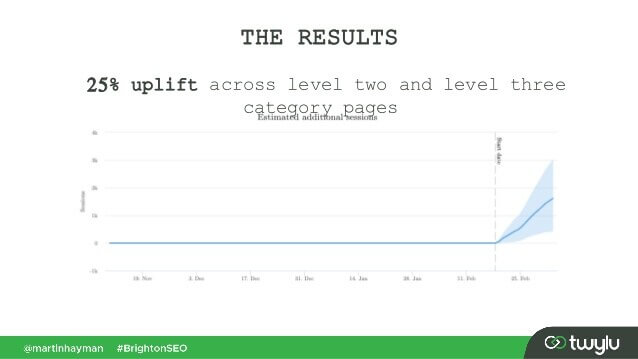

I Et nylig tilfelle presentert Av Martin Hayman på BrightonSEO, la Martin linken han allerede hadde i navigasjonsmenyen til hovedinnholdet på sidene. Som et resultat opplevde disse kategorisidene og sidene de koblet til en 25% trafikkoppheving.

dette eksperimentet viser at innholdskoblinger passerer mer vekt enn noen andre.

Når det gjelder koblingene i forfatterens bio, Antar Seo at biokoblinger veier noe, men er mindre verdifulle enn for eksempel innholdskoblinger. Selv om vi ikke har mye bevis her, men for Hva Matt Cutts sa da Google aktivt bekjempet overdreven gjesteblogging for tilbakekoblinger.

Korrelasjon mellom trafikk, brukeradferd og link authority

John Mueller klargjorde Måten Google behandler trafikk og brukeradferd når Det gjelder å passere link juice i En Av Search Console Central hangouts. En Bruker spurte Mueller om Google vurderer klikksannsynlighet og antall koblingsklikk når man vurderer kvaliteten på en kobling. De viktigste takeaways Fra Muellers svar var:

-

Google vurderer ikke koblingsklikk og klikksannsynlighet når man vurderer kvaliteten på lenken.

-

Google forstår at koblinger ofte legges til innhold som referanser, og brukere forventes ikke å klikke på hver kobling de kommer over.

Likevel, Som alltid, Tviler Seo på om det er verdt å blindt tro på Alt Google sier, og fortsett å eksperimentere. Så, gutta Fra Ahrefs gjennomført en studie for å sjekke om en side posisjon PÅ EN SERP er koblet til antall tilbakekoblinger den har fra høy trafikk sider. Studien viste at det er knapt noen sammenheng. Videre viste noen topprangerte sider seg å ikke ha tilbakekoblinger fra trafikkrike sider i det hele tatt.

denne studien peker oss i en lignende retning Som John Muellers ord-du trenger ikke å bygge trafikkgenererende tilbakekoblinger til siden din for å få høye stillinger på EN SERP. På den annen side har ekstra trafikk aldri skadet noe nettsted. Den eneste meldingen her er at trafikkrike tilbakekoblinger ikke ser ut til å påvirke Google-rangeringer.

nofollow, sponset, OG UGC koder

Som du husker, google introduserte nofollow tag i 2005 som en måte å bekjempe link spam. Har noe endret seg i dag? Faktisk, ja.

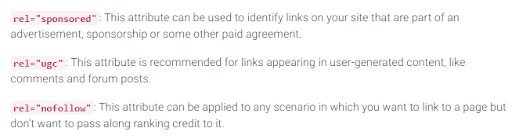

Først har Google nylig introdusert to typer nofollow-attributtet. Før Det foreslo Google å markere alle tilbakekoblingene du ikke vil delta i PageRank-beregningen som nofollow, det være seg bloggkommentarer eller betalte annonser. I Dag anbefaler Google å bruke rel=»sponset» for betalte og tilknyttede lenker og rel= » ugc » for brukergenerert innhold.

det er interessant at disse nye kodene ikke er obligatoriske (i hvert fall ikke ennå), Og Google påpeker at du ikke trenger å manuelt endre alle rel=»nofollow» til rel=»sponsored» og rel=»ugc». Disse to nye attributtene fungerer nå på samme måte som en vanlig nofollow-tag.

For Det Andre Sier Google nå at nofollow-kodene, så vel som de nye, sponsede og ugc, behandles som hint, i stedet for et direktiv når man indekserer sider.

Utgående lenker og deres innflytelse på rangeringer

i tillegg til innkommende lenker er det også utgående lenker, dvs. lenker som peker til andre sider fra deg.

Mange Seo tror at utgående koblinger kan påvirke rangeringer, men denne antagelsen har blitt behandlet SOM EN SEO myte. Men det er en interessant studie å se på i denne forbindelse.

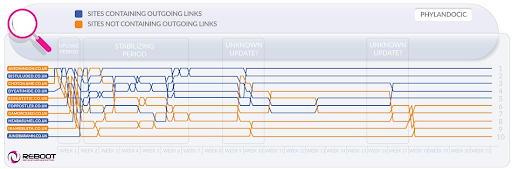

Reboot Online gjennomførte et eksperiment i 2015 og kjørte det igjen i 2020. De ønsket å finne ut om tilstedeværelsen av utgående lenker til høyautoritet sider påvirket sidens posisjon på EN SERP. De opprettet 10 nettsteder med 300-ord artikler, alle optimalisert for en unexisting søkeord – Phylandocic. 5 nettsteder ble igjen uten utgående lenker i det hele tatt, og 5 nettsteder inneholdt utgående lenker til ressurser med høy autoritet. Som et resultat begynte disse nettstedene med autoritative utgående lenker å rangere høyest, og de som ikke hadde noen lenker i det hele tatt, tok de laveste stillingene.

på den ene siden kan resultatene av denne forskningen fortelle oss at utgående lenker påvirker sidens posisjoner. På den annen side er søkeordet i forskningen helt nytt, og innholdet på nettstedene er tema rundt medisin og narkotika. Så det er store sjanser spørringen ble klassifisert SOM YMYL. Og Google har mange ganger uttalt betydningen Av E-A-T FOR YMYL nettsteder. Så, outlinks kan godt ha blitt behandlet som En E-A-t signal, beviser sidene har faktisk nøyaktig innhold.

Når Det gjelder vanlige spørsmål (ikke YMYL), Har John Mueller mange ganger sagt at Du ikke trenger å være redd for å koble til ytre kilder fra innholdet ditt, da utgående koblinger er gode for brukerne dine.

dessuten kan utgående koblinger være gunstige FOR SEO, da De kan tas i betraktning Av Google AI når du filtrerer nettet fra spam. Fordi spammy sider har en tendens til å ha noen utgående koblinger hvis noen i det hele tatt. De kobler enten til sidene under samme domene (hvis DE noen gang tenker PÅ SEO) eller inneholder kun betalte lenker. Så, hvis du kobler til noen troverdige ressurser, viser Du slags Google At siden din ikke er en spammy.

Det var en gang en oppfatning At Google kunne gi deg en manuell straff for å ha for mange utgående lenker, Men John Mueller sa at dette bare er mulig når de utgående koblingene åpenbart er en del av noen koblingsutvekslingsordning, pluss at nettstedet generelt er av dårlig kvalitet. Hva Google betyr under åpenbart er faktisk et mysterium, så husk sunn fornuft, innhold av høy kvalitet og grunnleggende SEO.

Google kamp mot link spam

Så lenge PageRank eksisterer, Vil Seo se etter nye måter å manipulere den på.

Tilbake I 2012 var Google mer sannsynlig å frigjøre manuelle handlinger for linkmanipulering og spam. Men Nå, Med sine velutdannede anti-spam-algoritmer, Kan Google bare ignorere visse spammy-koblinger ved beregning Av PageRank i stedet for å redusere hele nettstedet generelt. Som John Mueller sa,

Tilfeldige lenker samlet gjennom årene er ikke nødvendigvis skadelige, vi har sett dem i lang tid også, og kan ignorere alle de rare stykkene av web-graffiti fra lenge siden.

John Mueller

dette gjelder også om negativ SEO når din tilbakekobling profilen er kompromittert av konkurrentene:

Generelt tar vi automatisk hensyn til disse, og vi prøver å … ignorere dem automatisk når vi ser dem skje. For det meste mistenker jeg at det fungerer ganske bra. Jeg ser svært få mennesker med faktiske problemer rundt det. Så jeg tror det meste fungerer bra. Med hensyn til disavowing disse koblingene, jeg mistenker at hvis disse er bare vanlig spammy koblinger som bare dukker opp for nettstedet ditt, så jeg ville ikke bekymre deg for dem for mye. Sannsynligvis fant vi det ut på egen hånd.

John Mueller

Det betyr imidlertid ikke at du ikke har noe å bekymre deg for. Hvis nettstedets tilbakekoblinger blir ignorert for mye og for ofte, har du fortsatt stor sjanse for å få en manuell handling. Som Marie Haynes sier i hennes råd om link management i 2021:

Manuelle handlinger er reservert for tilfeller der et ellers anstendig nettsted har unaturlige lenker som peker på det på en skala som er så stor At Googles algoritmer ikke er komfortable å ignorere dem.

Marie Haynes

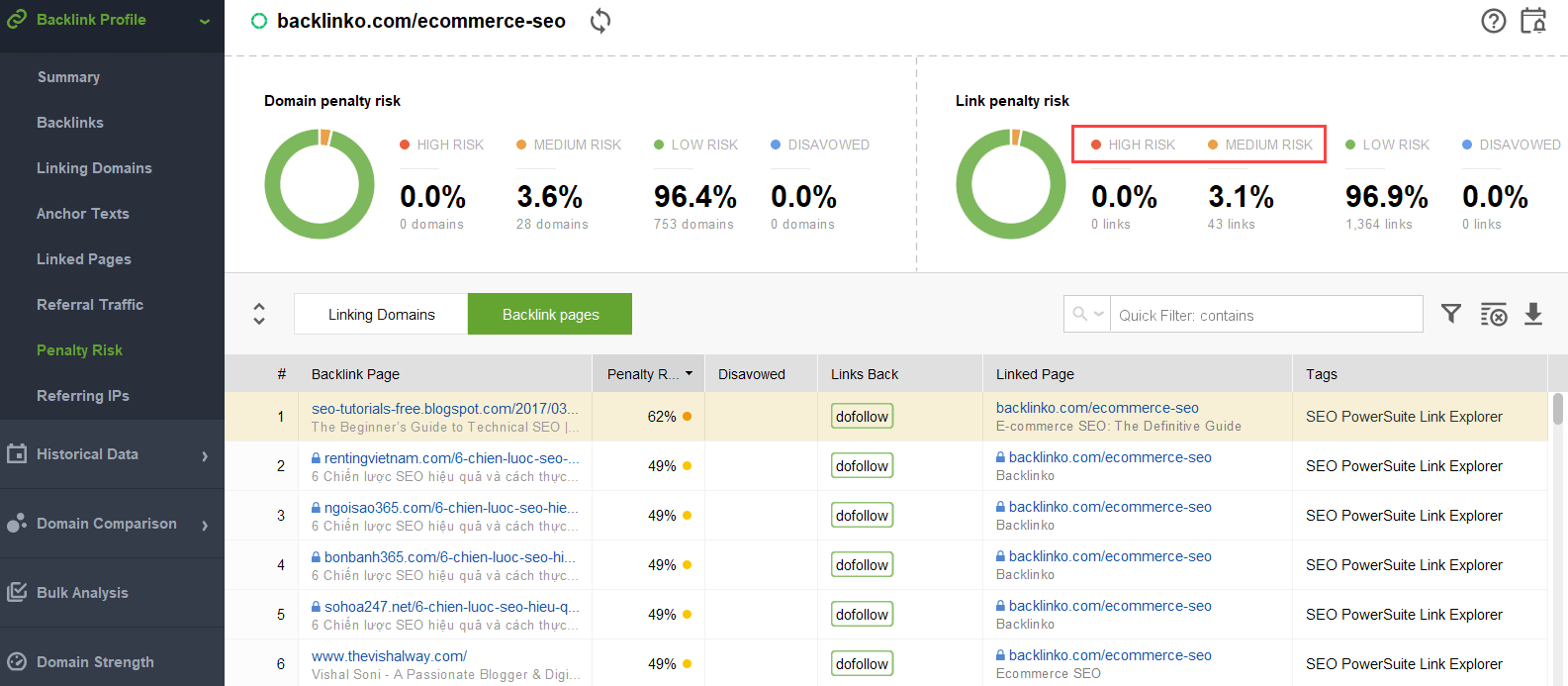

for å prøve å finne ut hvilke koblinger som utløser problemet, kan du bruke EN tilbakekoblingskontroll som SEO SpyGlass. I verktøyet går du Til Tilbakekoblingsprofil > Strafferisiko-delen. Vær oppmerksom på tilbakekoblinger med høy og middels risiko.

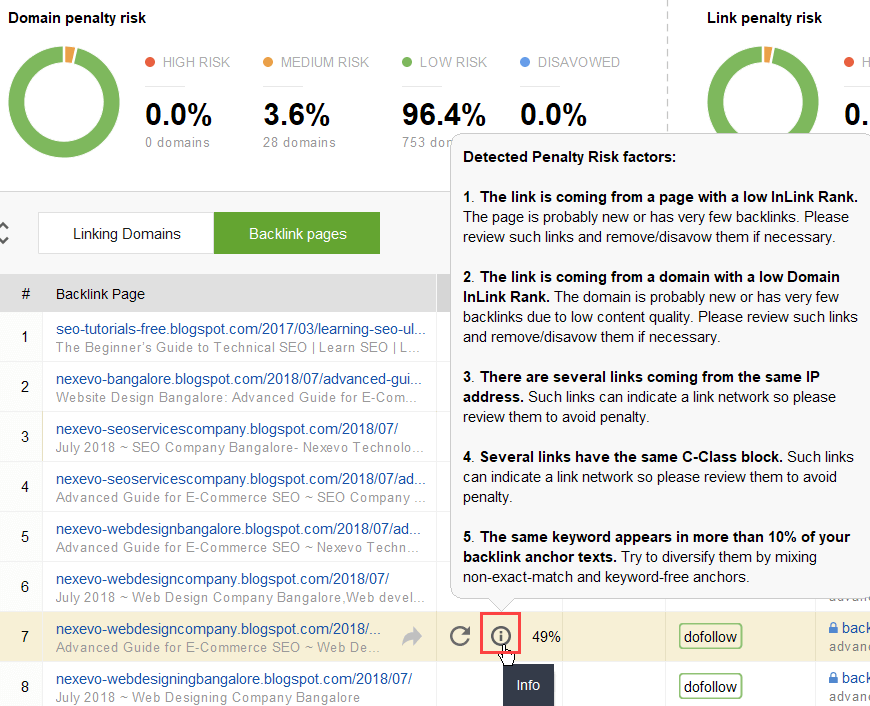

hvis du vil undersøke hvorfor denne eller den aktuelle lenken er rapportert som skadelig, klikker du på jeg logger i Strafferisiko-kolonnen. Her vil du se hvorfor verktøyet vurdert koblingen dårlig og gjøre opp tankene dine på om du vil disavow en link eller ikke.

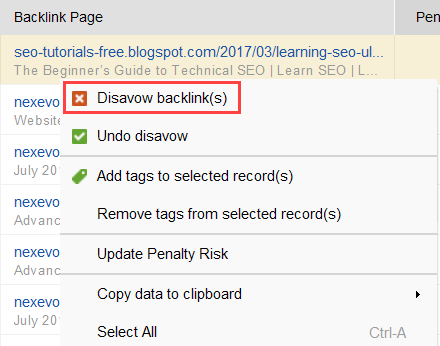

hvis du bestemmer deg for å disavow en kobling av en gruppe lenker, høyreklikker du dem og velger Disavow tilbakekobling (r) alternativ:

når du har dannet en liste over lenker for å ekskludere, kan du eksportere disavow-filen FRA SEO SpyGlass og sende Den Til Google via GSC.

Intern linking

Når Vi Snakker om PageRank, kan vi ikke annet enn nevne intern linking. Den innkommende PageRank er en ting vi ikke kan kontrollere, men vi kan helt kontrollere MÅTEN PR er spredt over nettsidene våre.

Google har uttalt viktigheten av intern kobling mange ganger også. John Mueller understreket dette igjen i En Av De nyeste Search Console Central hangouts. En bruker spurte hvordan å gjøre noen nettsider kraftigere. John Mueller sa følgende::

…Du kan hjelpe med intern kobling. Så, på nettstedet ditt, kan du virkelig markere sidene du vil ha uthevet mer, og sørg for at de er veldig godt koblet internt. Og kanskje sidene du ikke finner så viktig, sørg for at de er litt mindre koblet internt.

John Mueller

Intern kobling betyr mye. Det hjelper deg med å dele innkommende PageRank mellom ulike sider på nettstedet ditt, og dermed styrke dine underpresterende sider og gjøre nettstedet ditt sterkere generelt.

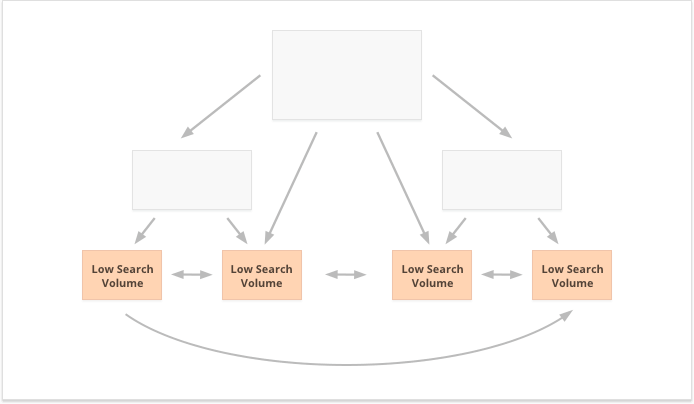

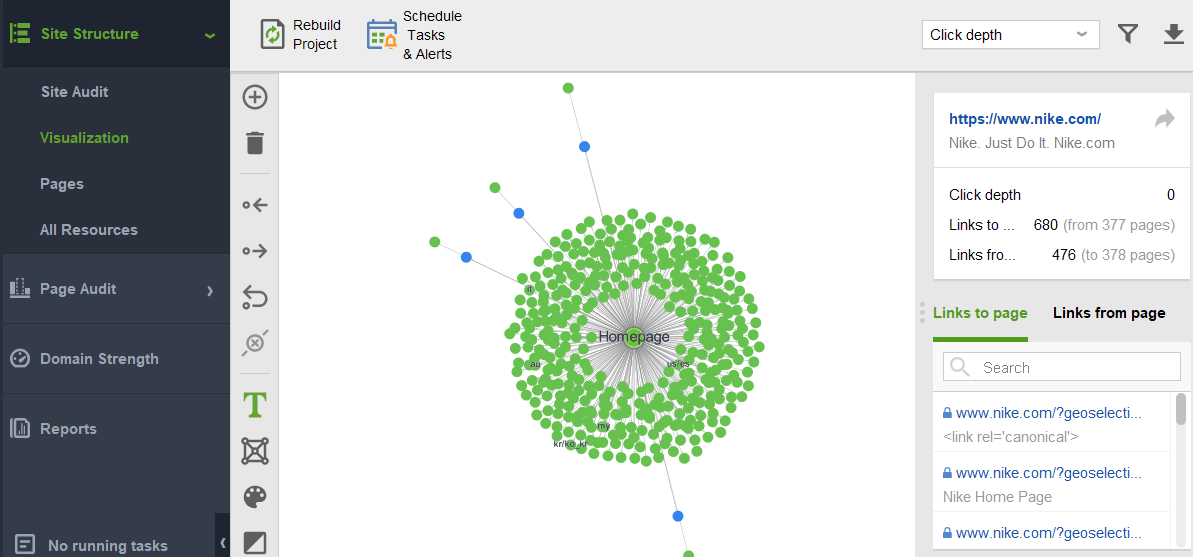

når det gjelder tilnærmingene til intern kobling, Har Seo mange forskjellige teorier. En populær tilnærming er relatert til nettstedsklikkdybde. Denne ideen sier at alle sidene på nettstedet ditt må være maksimalt 3-klikks avstand fra hjemmesiden. Selv Om Google har understreket viktigheten av grunne nettsted struktur mange ganger, også, i virkeligheten synes dette utilgjengelig for alle de større enn små nettsteder.

En annen tilnærming er basert på begrepet sentralisert og desentralisert intern kobling. Som Kevin Indig beskriver det:

Sentraliserte nettsteder har en enkelt brukerflyt og trakt som peker på en nøkkelside. Nettsteder med desentralisert intern kobling har flere konverteringspunkter eller forskjellige formater for å registrere seg.

Kevin Indig

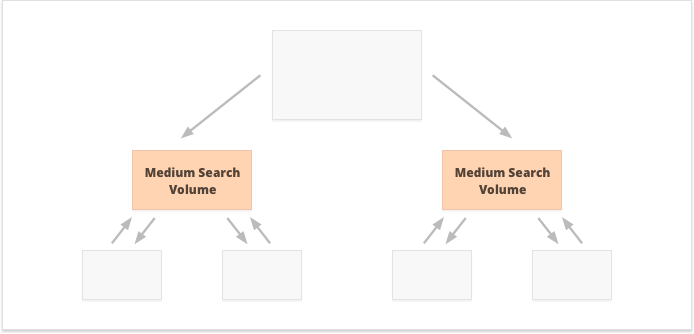

ved sentralisert intern kobling har vi en liten gruppe konverteringssider eller en side, som vi vil være kraftige. Hvis vi bruker desentralisert intern kobling, vil vi at alle nettsidene skal være like kraftige og ha lik PageRank for å få dem alle til å rangere for dine spørsmål.

Hvilket alternativ er bedre? Det hele avhenger av ditt nettsted og business nisje særegenheter, og på søkeordene du skal målrette. Sentralisert intern kobling passer for eksempel bedre til søkeord med høye og mellomstore søkevolumer, da det resulterer i et smalt sett med superkraftige sider.

Long-tail søkeord med lavt søkevolum, tvert imot, er bedre for desentralisert intern linking, da DEN sprer PR like mellom mange nettsider.

Et annet aspekt ved vellykket intern kobling er balansen mellom innkommende og utgående koblinger på siden. I denne forbindelse bruker Mange Seo CheiRank (CR), som faktisk er en invers PageRank. Men Mens PageRank er kraften mottatt, Er CheiRank lenkekraften gitt bort. Når DU beregner PR og CR for sidene dine, kan du se hvilke sider som har koblingsavvik, dvs. tilfellene når en side mottar Mye PageRank, men går videre litt, og omvendt.

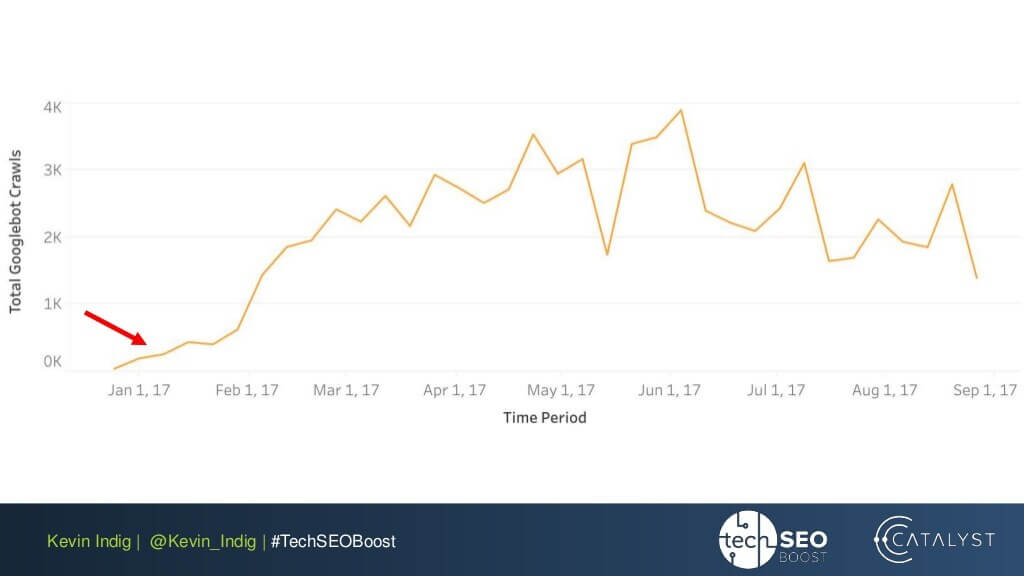

Et interessant eksperiment her Er Kevin Indigs flattning av link anomalies. Bare å sørge for at innkommende Og utgående PageRank er balansert på hver side av nettstedet brakt svært imponerende resultater. Den røde pilen peker her på tiden da anomaliene ble løst:

Link anomalies er ikke det eneste som kan skade PageRank flow. Pass på at du ikke blir sittende fast med noen tekniske problemer, noe som kan ødelegge din hardt opptjente PR:

-

Foreldreløse sider. Foreldreløse sider er ikke knyttet til noen annen side på nettstedet ditt, og dermed sitter de bare i tomgang og mottar ingen koblingsjuice. Google kan ikke se dem og vet ikke at de faktisk eksisterer.

-

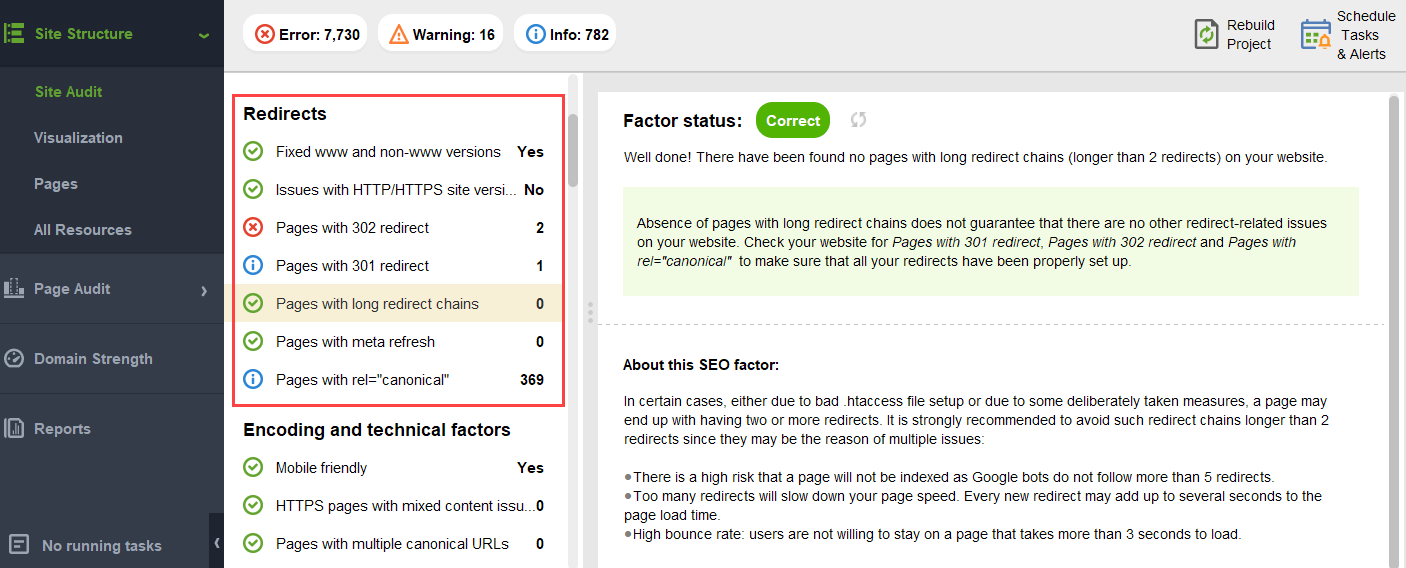

Omdirigere kjeder. Selv Om Google sier at omdirigeringer nå passerer 100% AV PR, anbefales det fortsatt å unngå lange omdirigeringskjeder. Først spiser de opp gjennomsøkingsbudsjettet ditt uansett. For Det andre vet Vi at Vi ikke blindt kan tro på Alt Som Google sier.

-

Lenker i unparseable JavaScript. Som Google ikke kan lese dem, vil De ikke passere PageRank.

-

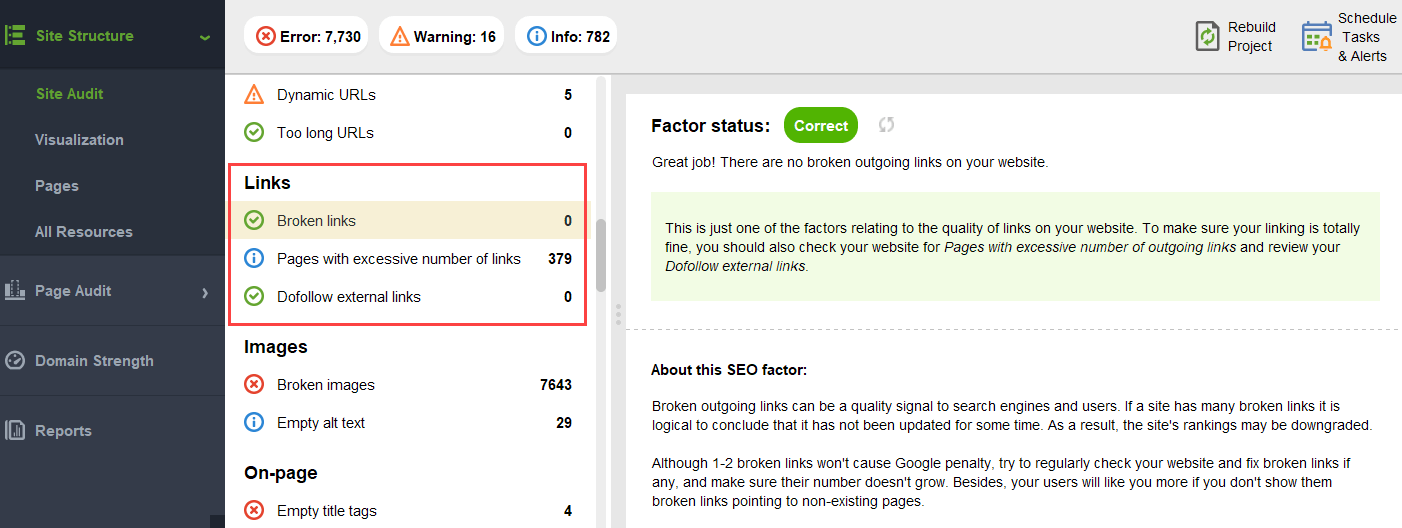

404 lenker. 404 lenker fører til ingensteds, Så PageRank går ingensteds også.

-

lenker til uviktige sider. Selvfølgelig, du kan ikke la noen av sidene uten koblinger i det hele tatt, men sidene er ikke skapt like. Hvis en side er mindre viktig, er det ikke rasjonelt å legge for mye arbeid i å optimalisere koblingsprofilen til den siden.

-

for fjerne sider. Hvis en side ligger for dypt på nettstedet ditt, er det sannsynlig å få lite PR eller INGEN PR i det hele tatt. Som Google kanskje ikke klarer å finne og indeksere den.

for å sikre at nettstedet ditt er fri for Disse PageRank-farene, kan du revidere Det med WebSite Auditor. Dette verktøyet har et omfattende sett med moduler I Nettstedstrukturen > Nettstedsrevisjonsseksjonen, som lar deg sjekke den generelle optimaliseringen av nettstedet ditt, og selvfølgelig finne og fikse alle koblingsrelaterte problemer, for eksempel lange omdirigeringer:

og ødelagte lenker:

hvis du vil sjekke om det finnes foreldreløse sider eller sider som er for langt unna, bytter du Til Nettstedsstruktur > Visualisering:

fremtiden For PageRank

I år PageRank har slått 23. Og jeg antar, det er eldre enn noen av våre lesere i dag:) Men hva kommer For PageRank i fremtiden? Kommer det til å forsvinne helt en dag?

Søkemotorer uten tilbakekoblinger

når du prøver å tenke på en populær søkemotor som ikke bruker tilbakekoblinger i algoritmen, er Den eneste ideen Jeg kan komme opp Med Yandex-eksperimentet tilbake i 2014. Søkemotoren annonserte at å slippe tilbakekoblinger fra algoritmen deres endelig kunne stoppe koblingsspammere fra manipulasjoner og bidra til å lede deres innsats for å skape kvalitet på nettstedet.

Det kan ha vært en ekte innsats for å bevege seg mot alternative rangeringsfaktorer, eller bare et forsøk på å overtale massene til å slippe link spam. Men i alle fall, på bare et år fra kunngjøringen, Yandex bekreftet tilbakekobling faktorer var tilbake i deres system.

men hvorfor er backlinks så uunnværlig for søkemotorer?

mens du har utallige andre datapunkter for å omorganisere søkeresultatene etter å ha begynt å vise dem (som brukeradferd og bert-justeringer), forblir tilbakekoblinger et av de mest pålitelige autoritetskriteriene som trengs for å danne den første SERP. Deres eneste konkurrent her er sannsynligvis enheter.

Som Bill Slawski sier det når han blir spurt Om Fremtiden For PageRank:

Google utforsker maskinlæring og faktautvinning og forstår viktige verdipar for forretningsenheter, noe som betyr en bevegelse mot semantisk søk, og bedre bruk av strukturert data og datakvalitet.

Bill Slawski, SEO ved Sjøen

Likevel Er Google ganske ulikt å kaste bort noe de har investert flere tiår med utvikling i.

Google er veldig god på linkanalyse, som nå er en veldig moden webteknologi. På grunn av at Det er fullt mulig At PageRank vil fortsette å bli brukt til å rangere organiske SERPs.

Bill Slawski, SEO ved Sjøen

Nyheter og andre tidsfølsomme resultater

En annen trend Bill Slawski pekte på var nyheter og andre kortvarige typer søkeresultater:

Google har fortalt oss at Det har stolt mindre På PageRank for sider der aktualitet er viktigere, for eksempel realtime resultater (som Fra Twitter), eller fra nyhetsresultater, hvor aktualitet er svært viktig.

Bill Slawski, SEO ved Sjøen

faktisk lever et stykke nyheter i søkeresultatene altfor lite til å samle nok tilbakekoblinger. Så Google har vært Og kan fortsette å jobbe for å erstatte tilbakekoblinger med andre rangeringsfaktorer når det gjelder nyheter.

men for nå er nyhetsrangeringer sterkt bestemt av utgiverens nisjeautoritet, og vi leser fortsatt authoritativitet som tilbakekoblinger:

«Autoritativitetssignaler bidrar til å prioritere informasjon av høy kvalitet fra de mest pålitelige kildene som er tilgjengelige. For å gjøre dette, er våre systemer designet for å identifisere signaler som kan bidra til å avgjøre hvilke sider som viser kompetanse, autoritativitet og troverdighet på et gitt emne, basert på tilbakemeldinger fra Søkevurderere. Disse signalene kan inkludere om andre mennesker verdsetter kilden for lignende spørsmål eller om andre fremtredende nettsteder om emnet lenker til historien.»

Nye rel=»sponset» og rel=»UGC» attributter

Sist men Ikke minst, Ble jeg ganske overrasket Over Innsatsen Google har gjort For å kunne identifisere sponsede og brukergenererte tilbakekoblinger og skille dem fra andre nofollowed lenker.

hvis alle disse tilbakekoblingene skal ignoreres, hvorfor bry seg om å fortelle en fra en annen? Spesielt Med John Muller som tyder på at Google senere kan prøve Å behandle disse typer koblinger annerledes.

Min villeste gjetning her var At Kanskje Google validerer om annonsering og brukergenererte lenker kan bli et positivt rangeringssignal.

tross alt krever annonsering på populære plattformer store budsjetter, og store budsjetter er et attributt til et stort og populært merke.

Brukergenerert innhold, når det vurderes utenfor kommentarspamparadigmet, handler om virkelige kunder som gir sine virkelige anbefalinger.

men ekspertene jeg nådde ut til, trodde ikke det var mulig:

Jeg tviler På At Google noen gang ville vurdere sponsede lenker som et positivt signal.

Barry Schwartz, Søkemotor Roundtable

ideen her, det virker, er At ved å skille ulike typer koblinger Google ville prøve å finne ut hvilke av nofollow koblingene skal følges for enhet-bygningen formål:

Google har ikke noe problem med brukergenerert innhold eller sponset innhold på et nettsted, men begge har historisk blitt brukt som metoder for å manipulere pagerank. Som sådan oppfordres webmastere til å plassere et nofollow-attributt på disse koblingene (blant andre grunner for å bruke nofollow).Imidlertid kan nofollowed koblinger fortsatt være nyttige For Google for Ting (som entity recognition for eksempel), så de har tidligere notert at de kan behandle dette som et mer av et forslag, og ikke et direktiv som en roboter.txt forby regelen ville være på ditt eget nettsted.John Muellers uttalelse var » jeg kunne forestille meg i våre systemer som vi kan lære over tid å behandle dem litt annerledes.»Dette kan referere Til tilfellene Der Google behandler en nofollow som et forslag. Hypotetisk er Det mulig At Googles systemer kan lære hvilke nofollowed lenker å følge basert på innsikt samlet fra typer lenke merket som ugc og sponset. Igjen, dette bør ikke ha mye innvirkning på et nettsteds rangeringer – men det kan teoretisk ha innvirkning på nettstedet som er koblet også.

Callum Scott, Marie Haynes Consulting

.png)