det förflutna, nutid och framtid Google PageRank

PageRank algoritm (eller PR för kort) är ett system för ranking webbsidor som utvecklats av Larry Page och Sergey Brin vid Stanford University i slutet av 90-talet. PageRank var faktiskt grunden sidan och Brin skapade Googles sökmotor på.

många år har gått sedan dess, och naturligtvis har Googles rankningsalgoritmer blivit mycket mer komplicerade. Är de fortfarande baserade på PageRank? Hur exakt påverkar PageRank rankningen, och vad ska SEO: er göra sig redo för i framtiden? Nu ska vi hitta och sammanfatta alla fakta och mysterier runt PageRank för att göra bilden klar. Så mycket vi kan.

Pageranks förflutna

som nämnts ovan försökte Brin och Page i sitt universitetsforskningsprojekt uppfinna ett system för att uppskatta auktoriteten hos webbsidor. De bestämde sig för att bygga det systemet på länkar, som fungerade som förtroende för en sida. Enligt logiken i den mekanismen, ju mer externa resurser länkar till en sida, desto mer värdefull information har den för användarna. Och PageRank (en poäng från 0 till 10 beräknad baserat på kvantitet och kvalitet på inkommande länkar) visade relativ auktoritet på en sida på Internet.

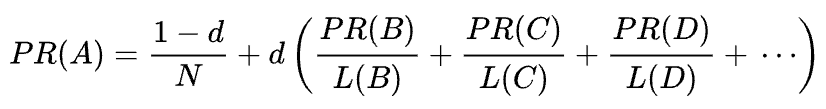

Original PageRank formel

Låt oss ta en titt på hur PageRank fungerar. Varje länk från en sida (A) till en annan (B) kastar en så kallad omröstning, vars vikt beror på den kollektiva vikten på alla sidor som länkar till sidan A. Och vi kan inte veta deras vikt förrän vi beräknar det, så processen går i cykler.

den matematiska formeln för den ursprungliga PageRank är följande:

där A, B, C och D är några sidor är L antalet länkar som går ut från var och en av dem och N är det totala antalet sidor i samlingen (dvs. på Internet).

när det gäller d är d den så kallade dämpningsfaktorn. Med tanke på att PageRank beräknas simulera beteendet hos en användare som slumpmässigt kommer till en sida och klickar på länkar, tillämpar vi denna dämpnings-d-faktor som sannolikheten för att användaren blir uttråkad och lämnar en sida.

som du kan se från formeln, om det inte finns några sidor som pekar på sidan, kommer dess PR inte att vara noll men

eftersom det finns en sannolikhet att användaren kan komma till den här sidan inte från några andra sidor men, säg, från bokmärken.

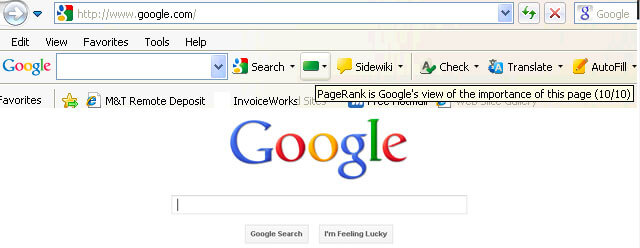

PageRank manipulation sårbarhet och Googles krig mot länkspam

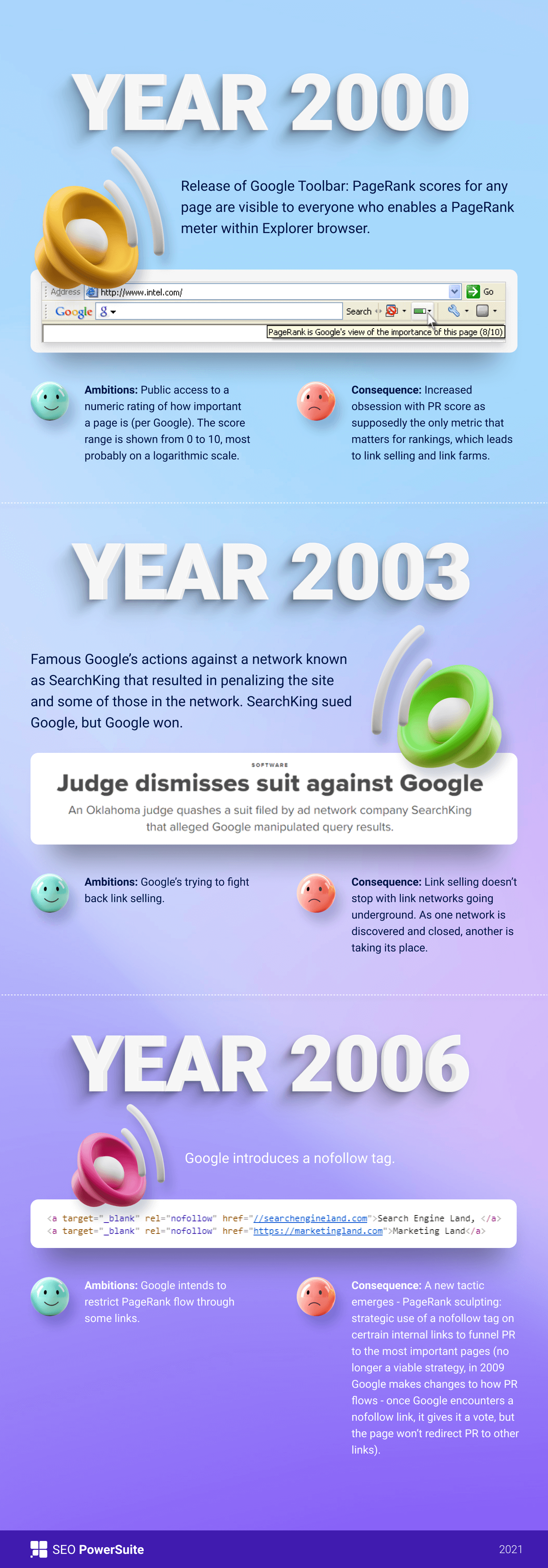

först var PageRank-poängen offentligt synlig i Google Toolbar, och varje sida hade sin poäng från 0 till 10, troligen i logaritmisk skala.

Googles rankningsalgoritmer av dessa tider var väldigt enkla-hög PR och sökordsdensitet var de enda två sakerna som en sida behövde ranka högt på en SERP. Som ett resultat var webbsidor fyllda med nyckelord, och webbplatsägare började manipulera PageRank genom att artificiellt växa spammiga bakåtlänkar. Det var lätt att göra — link farms och link selling var där för att ge webbplatsägare en ”hjälpande hand.”

Google beslutade att bekämpa länkspam tillbaka. 2003 straffade Google webbplatsen för annonsnätverket SearchKing för länkmanipulationer. SearchKing stämde Google, men Google vann. Det var ett sätt som Google försökte begränsa alla från länkmanipulationer, men det ledde till ingenting. Link farms gick bara under jorden, och deras kvantitet multiplicerades kraftigt.

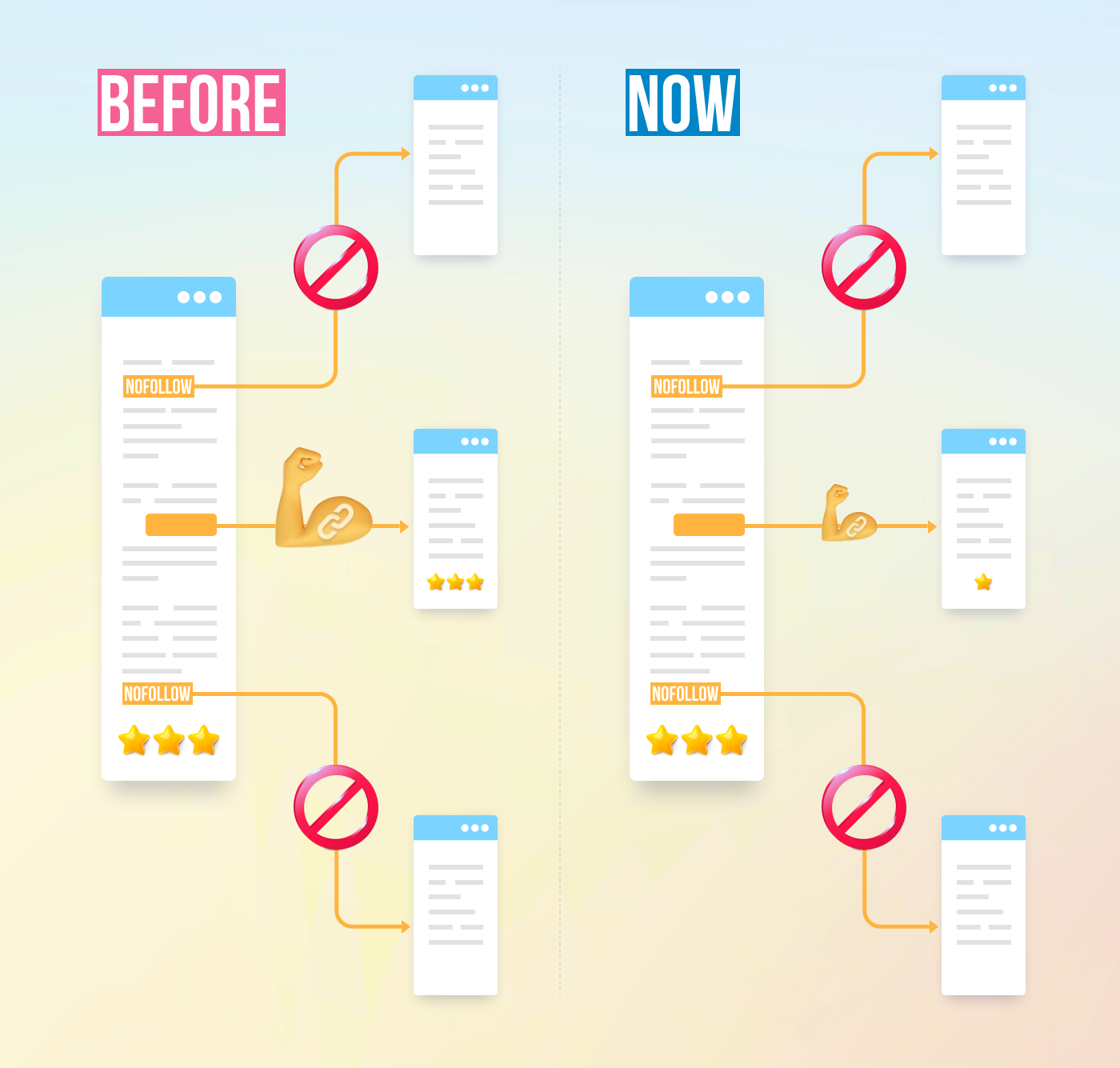

dessutom spammy kommentarer på bloggar multipliceras också. Bots attackerade kommentarerna från någon, säger WordPress-blogg och lämnade enorma antal ”klicka-här-att-köpa-magiska-piller” kommentarer. För att förhindra spam och PR-manipulation i kommentarer introducerade Google nofollow-taggen 2005. Och än en gång, vad Google menade att bli ett framgångsrikt steg i länkmanipuleringskriget implementerades på ett vridet sätt. Folk började använda nofollow-taggar för att artificiellt trampa PageRank till de sidor de behövde. Denna taktik blev känd som PageRank sculpting.

för att förhindra PR-skulptur ändrade Google Hur PageRank flyter. Tidigare, om en sida hade både nofollow-och dofollow-länkar, skickades all PR-volym på sidan till andra sidor länkade till med Dofollow-länkarna. Under 2009 började Google dela en sidas PR lika mellan alla länkar som sidan hade, men passerade bara de aktier som gavs till Dofollow-länkarna.

gjort med PageRank sculpting stoppade Google inte länkspamkriget och började följaktligen ta PageRank-poäng ur allmänhetens ögon. Först lanserade Google den nya Chrome-webbläsaren utan Google Toolbar där PR-poängen visades. Sedan upphörde de att rapportera PR-poängen i Google Search Console. Sedan slutade Firefox-webbläsaren att stödja Google Toolbar. I 2013 uppdaterades PageRank för Internet Explorer för sista gången, och i 2016 stängde Google officiellt verktygsfältet för allmänheten.

ett annat sätt som Google använde för att bekämpa länksystem var Penguin update, som rankade webbplatser med fishy backlink-profiler. Utrullad i 2012 blev Penguin inte en del av Googles realtidsalgoritm utan var snarare ett ”filter” uppdaterat och applicerat på sökresultaten då och då. Om en webbplats blev straffad av Penguin, måste SEO noggrant granska sina länkprofiler och ta bort giftiga länkar eller lägga till dem i en disavow-lista (en funktion introducerade dessa dagar för att berätta för Google vilka inkommande länkar som ska ignoreras vid beräkning av PageRank). Efter att ha granskat länkprofiler på det sättet fick SEO: er vänta i ett halvt år tills Penguin-algoritmen beräknar om data.

i 2016 gjorde Google Penguin till en del av sin kärnrankningsalgoritm. Sedan dess har det arbetat i realtid och algoritmiskt hanterat spam mycket mer framgångsrikt.

samtidigt arbetade Google med att underlätta kvalitet snarare än kvantitet av länkar och spikade ner det i sina kvalitetsriktlinjer mot länksystem.

Pageranks nuvarande

Tja, vi är färdiga med Pageranks förflutna. Vad händer nu?

tillbaka i 2019 sa en tidigare Google-anställd att den ursprungliga PageRank-algoritmen inte hade använts sedan 2006 och ersattes med en annan mindre resurskrävande algoritm när Internet blev större. Vilket kan vara sant, som i 2006 lämnade Google in den nya som producerar en ranking för sidor som använder avstånd i ett webblänkgrafpatent.

används PageRank-algoritmen idag?

Ja, det är det. Det är inte samma PageRank som det var i början av 2000-talet, men Google fortsätter att förlita sig på link authority kraftigt. Till exempel nämnde en tidigare Google-anställd Andrey Lipattsev detta 2016. I en Google Q& en hangout frågade en användare honom vad som var de viktigaste rankningssignalerna som Google använde. Andreys svar var ganska enkelt.

jag kan berätta vad de är. Det är innehåll och länkar som pekar på din webbplats.

Andrey Lipattsev

år 2020 bekräftade John Mueller det än en gång:

Ja, Vi använder PageRank internt, bland många, många andra signaler. Det är inte riktigt detsamma som originalpapperet, det finns massor av quirks (t.ex. disavowed länkar, ignorerade länkar etc.), och igen använder vi många andra signaler som kan vara mycket starkare.

John Mueller

som du kan se lever PageRank fortfarande och används aktivt av Google när du rankar sidor på webben.

det som är intressant är att Google-anställda fortsätter att påminna oss om att det finns många, många, många andra rankningssignaler. Men vi tittar på detta med ett saltkorn. Med tanke på hur mycket ansträngning Google ägnade sig åt att bekämpa länkspam, kan det vara av Googles intresse att byta SEO: s uppmärksamhet från de manipuleringssårbara faktorerna (som bakåtlänkar är) och driva denna uppmärksamhet på något oskyldigt och trevligt. Men eftersom SEO är bra på att läsa mellan raderna, fortsätter de att överväga PageRank en stark rankningssignal och växa bakåtlänkar på alla sätt de kan. De använder fortfarande PBNs, öva lite gråhatt tiered länk byggnad, köpa länkar, och så vidare, precis som det var länge sedan. Som PageRank liv, länk spam kommer att leva, för. Vi rekommenderar inte något av det, men det är vad SEO-verkligheten är, och vi måste förstå det.

Random Surfer vs. rimliga surfare modeller av PageRank

Tja, du fick tanken att PageRank nu inte är PageRank det var 20 år sedan.

en av de viktigaste moderniseringarna av PR var att flytta från den kort nämnda slumpmässiga Surfmodellen till den rimliga Surfmodellen 2012. Rimlig surfare antar att användare inte beter sig kaotiskt på en sida och bara klickar på de länkar de är intresserade av just nu. Säg att du läser en bloggartikel, det är mer troligt att du klickar på en länk i artikelns innehåll snarare än en Användarvillkoren länk i sidfoten.

Dessutom kan rimlig surfare potentiellt använda en mängd andra faktorer när man utvärderar en länks attraktivitet. Alla dessa faktorer granskades noggrant av Bill Slawski i sin artikel, men jag skulle vilja fokusera på de två faktorerna, som SEO diskuterar oftare. Dessa är länkposition och sidtrafik. Vad kan vi säga om dessa faktorer?

korrelation mellan länkposition och länkmyndighet

en länk kan finnas var som helst på sidan — i dess innehåll, navigeringsmeny, författarens bio, sidfot och faktiskt alla strukturella element som sidan innehåller. Och olika länkplatser påverkar länkvärdet. John Mueller bekräftade det, säger att länkar placerade i huvudinnehållet väger mer än alla andra:

det här är området på sidan där du har ditt primära innehåll, innehållet som den här sidan faktiskt handlar om, inte menyn, sidofältet, sidfoten, rubriken… då är det något vi tar hänsyn till och vi försöker använda dessa länkar.

John Mueller

så, sidfot länkar och navigeringslänkar sägs passera mindre vikt. Och detta faktum från tid till annan bekräftas inte bara av Googles talesmän utan av verkliga fall.

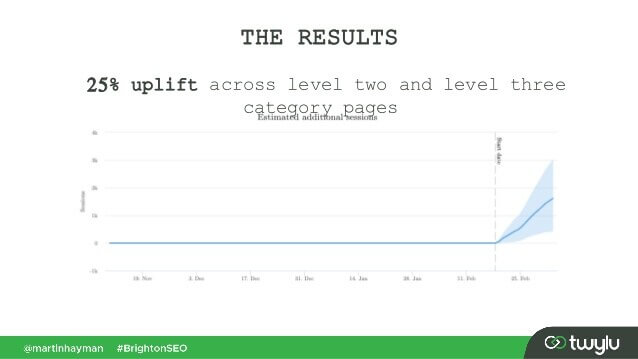

i ett nyligen presenterat fall av Martin Hayman på BrightonSEO lade Martin till länken han redan hade i sin navigeringsmeny till sidans huvudinnehåll. Som ett resultat upplevde de kategorisidorna och sidorna de länkade till en trafikhöjning på 25%.

detta experiment visar att innehållslänkar passerar mer vikt än någon annan.

när det gäller länkarna i författarens bio antar SEO: er att biolänkar väger något, men är mindre värdefulla än innehållslänkar. Även om vi inte har mycket bevis här men för vad Matt Cutts sa när Google aktivt kämpade för överdriven gästbloggning för bakåtlänkar.

korrelation mellan trafik, användarbeteende och länkmyndighet

John Mueller klargjorde hur Google behandlar trafik och användarbeteende när det gäller att skicka link juice i en av Search Console centrala hangouts. En användare frågade Mueller Om Google överväger klicksannolikhet och antalet länkklick när man utvärderar kvaliteten på en länk. De viktigaste takeawaysna från Muellers svar var:

-

Google tar inte hänsyn till länkklick och klicksannolikhet när man utvärderar länkens kvalitet.

-

Google förstår att länkar ofta läggs till i innehåll som referenser, och användare förväntas inte klicka på varje länk de stöter på.

som alltid tvivlar SEO: er på om det är värt att blint tro på allt Google säger och fortsätta experimentera. Så killar från Ahrefs genomförde en studie för att kontrollera om en sidas position på en SERP är kopplad till antalet bakåtlänkar som den har från högtrafikerade sidor. Studien visade att det knappast finns någon korrelation. Dessutom visade sig vissa topprankade sidor inte ha några bakåtlänkar från trafikrika sidor alls.

denna studie pekar oss i en liknande riktning som John Muellers ord-du behöver inte bygga trafikgenererande bakåtlänkar till din sida för att få höga positioner på en SERP. Å andra sidan har extra trafik aldrig skadat någon webbplats. Det enda meddelandet här är att trafikrika bakåtlänkar inte verkar påverka Googles ranking.

nofollow, sponsrade och UGC-taggar

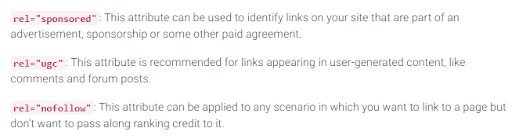

som du kommer ihåg introducerade Google nofollow-taggen 2005 som ett sätt att bekämpa länkspam. Har något förändrats idag? Faktiskt, ja.

först har Google nyligen introducerat ytterligare två typer av nofollow-attributet. Innan det föreslog Google att markera alla bakåtlänkar som du inte vill delta i PageRank-beräkningen som nofollow, var det bloggkommentarer eller betalda annonser. Idag rekommenderar Google att du använder rel = ”sponsrad”för betalda och anslutna länkar och rel=” ugc ” för användargenererat innehåll.

det är intressant att dessa nya taggar inte är obligatoriska (åtminstone ännu inte), och Google påpekar att du inte behöver ändra alla rel=”nofollow” manuellt till rel=”sponsrad” och rel=”ugc”. Dessa två nya attribut fungerar nu på samma sätt som en vanlig nofollow-tagg.

för det andra säger Google nu att nofollow-taggarna, liksom de nya, sponsrade och ugc, behandlas som tips, snarare än ett direktiv vid indexering av sidor.

utgående länkar och deras inflytande på rankningar

förutom inkommande länkar finns det också utgående länkar, dvs länkar som pekar på andra sidor från din.

många SEO: er tror att utgående länkar kan påverka rankningar, men detta antagande har behandlats som en SEO-myt. Men det finns en intressant studie att titta på i detta avseende.

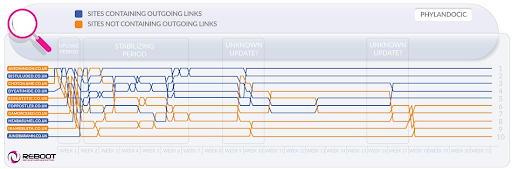

Reboot Online genomförde ett experiment 2015 och körde det igen 2020. De ville ta reda på om närvaron av utgående länkar till högmyndighetssidor påverkade sidans position på en SERP. De skapade 10 webbplatser med 300 – ords artiklar, alla optimerade för ett icke-existerande nyckelord-Phylandocic. 5 webbplatser lämnades utan utgående länkar alls, och 5 webbplatser innehöll utgående länkar till resurser med hög auktoritet. Som ett resultat började de webbplatser med auktoritativa utgående länkar ranka högst, och de som inte hade några länkar alls tog de lägsta positionerna.

å ena sidan kan resultaten av denna forskning berätta att utgående länkar påverkar sidornas positioner. Å andra sidan är söktermen i forskningen helt ny, och innehållet på webbplatserna är tema kring medicin och droger. Så det finns stora chanser att frågan klassificerades som YMYL. Och Google har många gånger sagt vikten av E-A-T för YMYL-webbplatser. Så, konturlänkarna kan väl ha behandlats som en E-A-T-signal, vilket visar att sidorna har faktiskt korrekt innehåll.

när det gäller vanliga frågor (inte YMYL) har John Mueller många gånger sagt att du inte behöver vara rädd för att länka till yttre källor från ditt innehåll, eftersom utgående länkar är bra för dina användare.

dessutom kan utgående länkar vara till nytta för SEO, eftersom de kan beaktas av Google AI när man filtrerar webben från spam. Eftersom skräppostsidor tenderar att ha få utgående länkar om några alls. De länkar antingen till sidorna under samma domän (om de någonsin tänker på SEO) eller innehåller endast betalda länkar. Så om du länkar till några trovärdiga resurser visar du typ av Google att din sida inte är en skräppost.

det var en gång en åsikt att Google kunde ge dig ett manuellt straff för att ha för många utgående länkar, men John Mueller sa att detta bara är möjligt när de utgående länkarna uppenbarligen är en del av något länkutbytessystem, plus webbplatsen är i allmänhet av dålig kvalitet. Vad Google betyder under uppenbart är faktiskt ett mysterium, så kom ihåg sunt förnuft, högkvalitativt innehåll och grundläggande SEO.

Google slåss mot länkspam

så länge PageRank finns kommer SEO att leta efter nya sätt att manipulera det.

tillbaka i 2012 var Google mer benägna att släppa manuella åtgärder för länkmanipulation och spam. Men nu, med sina välutbildade anti-spam algoritmer, Google kan bara ignorera vissa skräppost länkar vid beräkning PageRank snarare än nedrankning hela webbplatsen i allmänhet. Som John Mueller säger,

slumpmässiga länkar som samlats in genom åren är inte nödvändigtvis skadliga, vi har sett dem länge också och kan ignorera alla de konstiga bitarna av webbgraffiti från länge sedan.

John Mueller

detta gäller också om negativ SEO när din backlink-profil äventyras av dina konkurrenter:

i allmänhet tar vi automatiskt hänsyn till dessa och vi försöker… ignorera dem automatiskt när vi ser dem hända. För det mesta misstänker jag att det fungerar ganska bra. Jag ser väldigt få människor med faktiska problem kring det. Så jag tror att det mest fungerar bra. När det gäller att avvisa dessa länkar misstänker jag att om det bara är vanliga skräppostlänkar som bara dyker upp för din webbplats, skulle jag inte oroa mig för dem för mycket. Förmodligen tänkte vi det på egen hand.

John Mueller

men det betyder inte att du inte har något att oroa dig för. Om din webbplats bakåtlänkar ignoreras för mycket och för ofta har du fortfarande en stor chans att få en manuell åtgärd. Som Marie Haynes säger i sitt råd om länkhantering 2021:

manuella åtgärder är reserverade för fall där en annars anständig webbplats har onaturliga länkar som pekar på den på en skala som är så stor att Googles algoritmer inte är bekväma att ignorera dem.

Marie Haynes

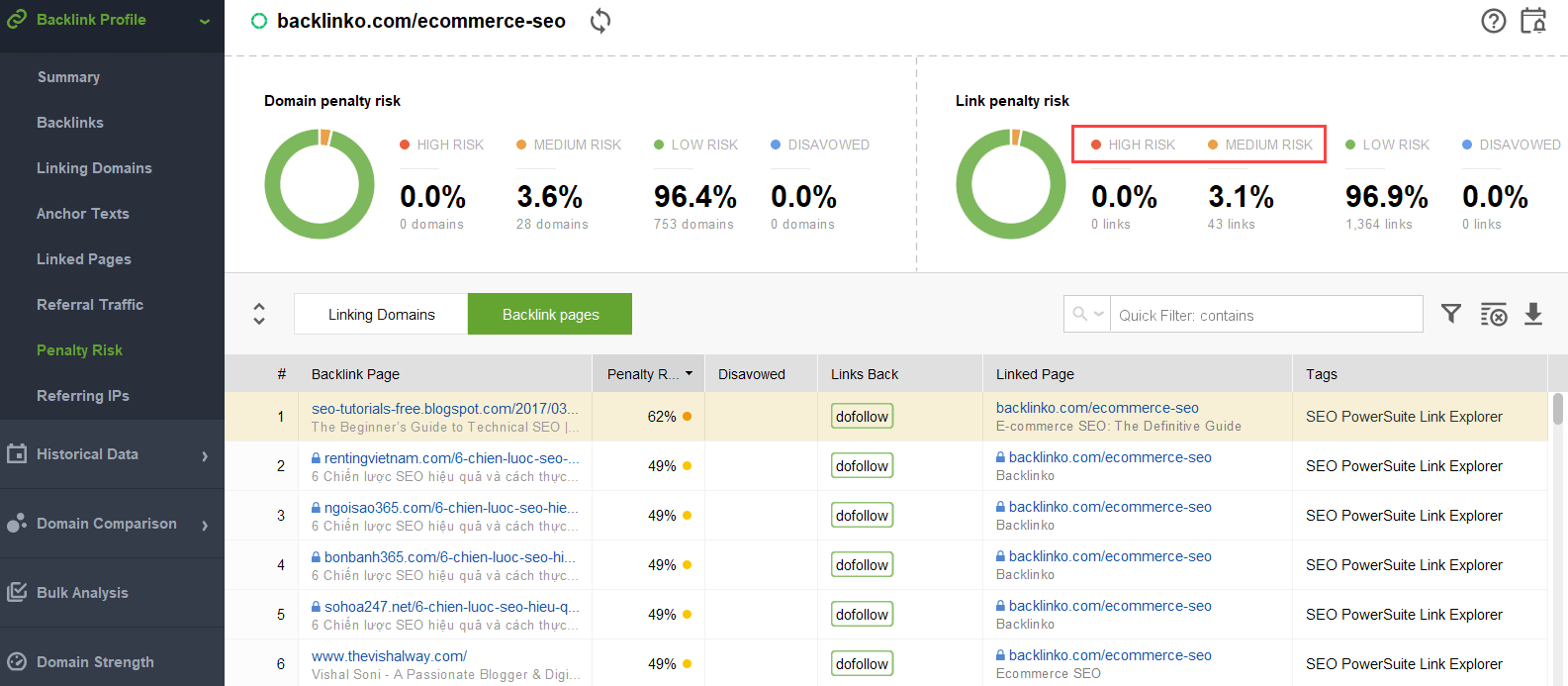

för att försöka lista ut vilka länkar som utlöser problemet kan du använda en backlink checker som SEO SpyGlass. I verktyget, gå till Backlink profil > straff Risk avsnitt. Var uppmärksam på bakåtlänkar med hög och medelhög risk.

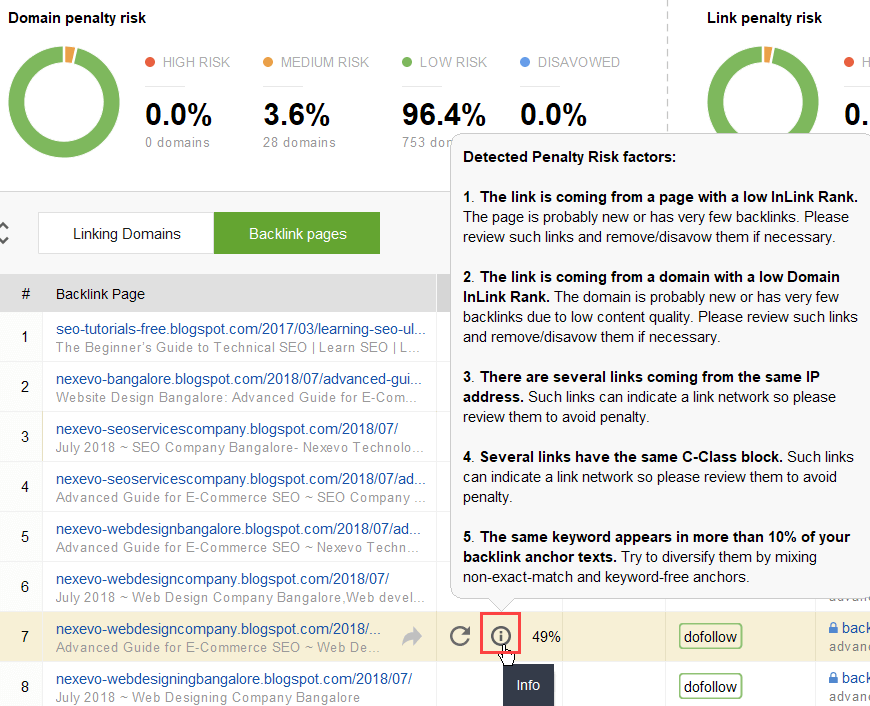

för att ytterligare undersöka varför den ena eller andra länken rapporteras som skadlig, klicka på Jag logga in straff Risk kolumnen. Här ser du varför verktyget ansåg länken dålig och bestämmer dig för om du skulle avvisa en länk eller inte.

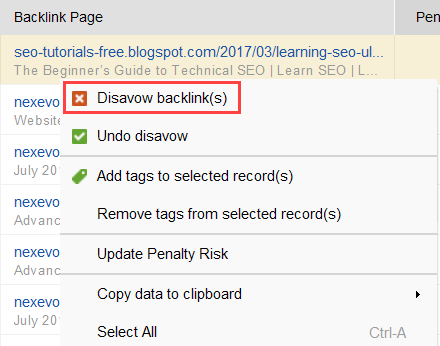

om du bestämmer dig för att avvisa en länk till en grupp länkar, högerklicka på dem och välj avvisa bakåtlänk(er) alternativ:

när du har bildat en lista med länkar för att utesluta, kan du exportera disavow filen från SEO SpyGlass och skicka den till Google via GSC.

intern länkning

på tal om PageRank kan vi bara nämna intern länkning. Den inkommande PageRank är typ av en sak som vi inte kan kontrollera, men vi kan helt kontrollera hur PR sprids över vår webbplats sidor.

Google har sagt vikten av intern länkning många gånger också. John Mueller betonade detta än en gång i en av de senaste Search Console Central hangouts. En användare frågade hur man gör vissa webbsidor mer kraftfulla. Och John Mueller sa följande:

…Du kan hjälpa till med intern länkning. Så på din webbplats kan du verkligen markera de sidor som du vill ha markerat mer och se till att de är riktigt väl länkade internt. Och kanske sidorna du inte tycker är så viktiga, se till att de är lite mindre länkade internt.

John Mueller

intern länkning betyder mycket. Det hjälper dig att dela inkommande PageRank mellan olika sidor på din webbplats, vilket stärker dina underpresterande sidor och gör din webbplats starkare övergripande.

när det gäller metoderna för intern länkning har SEO: er många olika teorier. Ett populärt tillvägagångssätt är relaterat till webbplatsens klickdjup. Den här tanken säger att alla sidor på din webbplats måste vara högst 3 klick avstånd från hemsidan. Även om Google har understrukit vikten av grund webbplatsstruktur många gånger, för, i verkligheten verkar detta oåtkomligt för alla större än små webbplatser.

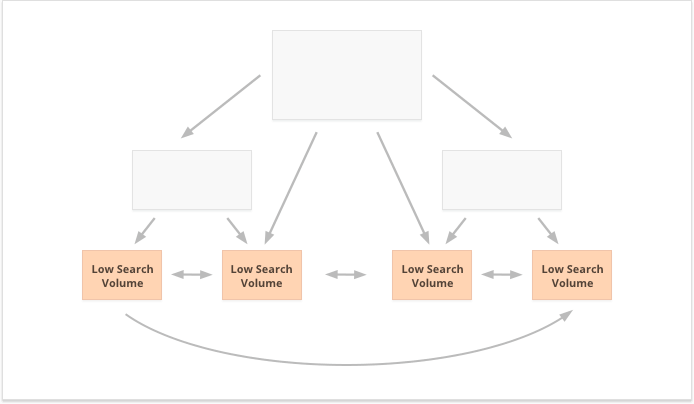

ytterligare ett tillvägagångssätt bygger på begreppet centraliserad och decentraliserad intern länkning. Som Kevin Indig beskriver det:

centraliserade webbplatser har ett enda användarflöde och tratt som pekar på en nyckelsida. Webbplatser med decentraliserad intern länkning har flera konverterings beröringspunkter eller olika format för att registrera dig.

Kevin Indig

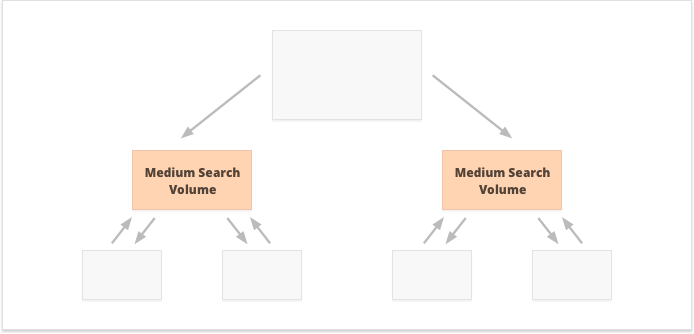

när det gäller centraliserad intern länkning har vi en liten grupp konverteringssidor eller en sida, som vi vill vara kraftfulla. Om vi tillämpar decentraliserad intern länkning vill vi att alla webbsidor ska vara lika kraftfulla och ha lika PageRank för att få dem alla att rangordna för dina frågor.

vilket alternativ är bättre? Det beror helt på din webbplats och affärs nisch egenheter, och på de sökord du kommer att rikta. Till exempel passar centraliserad intern länkning bättre nyckelord med höga och medelstora sökvolymer, eftersom det resulterar i en smal uppsättning supermäktiga sidor.

långsvansnyckelord med låg sökvolym är tvärtom bättre för decentraliserad intern länkning, eftersom den sprider PR lika mellan många webbsidor.

en ytterligare aspekt av framgångsrik intern länkning är balansen mellan inkommande och utgående länkar på sidan. I detta avseende använder många SEO CheiRank (CR), som faktiskt är en invers PageRank. Men medan PageRank är den mottagna kraften, CheiRank är länkkraften som ges bort. När du har beräknat PR och CR för dina sidor kan du se vilka sidor som har länkanomalier, dvs fallen när en sida får mycket PageRank men passerar lite längre och vice versa.

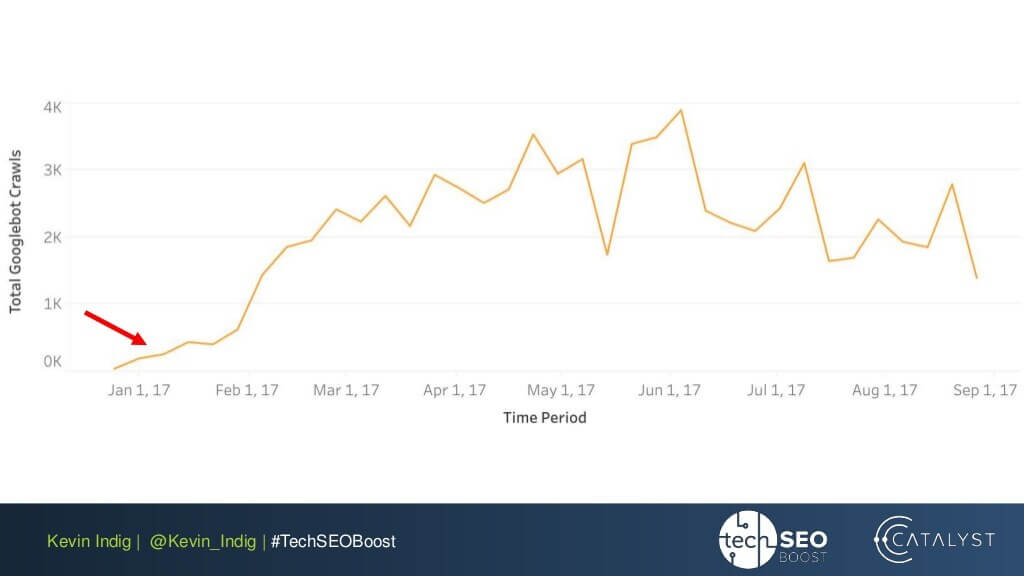

ett intressant experiment här är Kevin Indigs utplattning av länkanomalier. Att helt enkelt se till att den inkommande och utgående PageRank är balanserad på varje sida på webbplatsen gav mycket imponerande resultat. Den röda pilen här pekar på den tid då anomalierna fixades:

Länkanomalier är inte det enda som kan skada Pagerankflödet. Se till att du inte fastnar med några tekniska problem, vilket kan förstöra din surt förvärvade PR:

-

föräldralösa sidor. Föräldralösa sidor är inte länkade till någon annan sida på din webbplats, så de sitter bara lediga och får ingen länkjuice. Google kan inte se dem och vet inte att de faktiskt existerar.

-

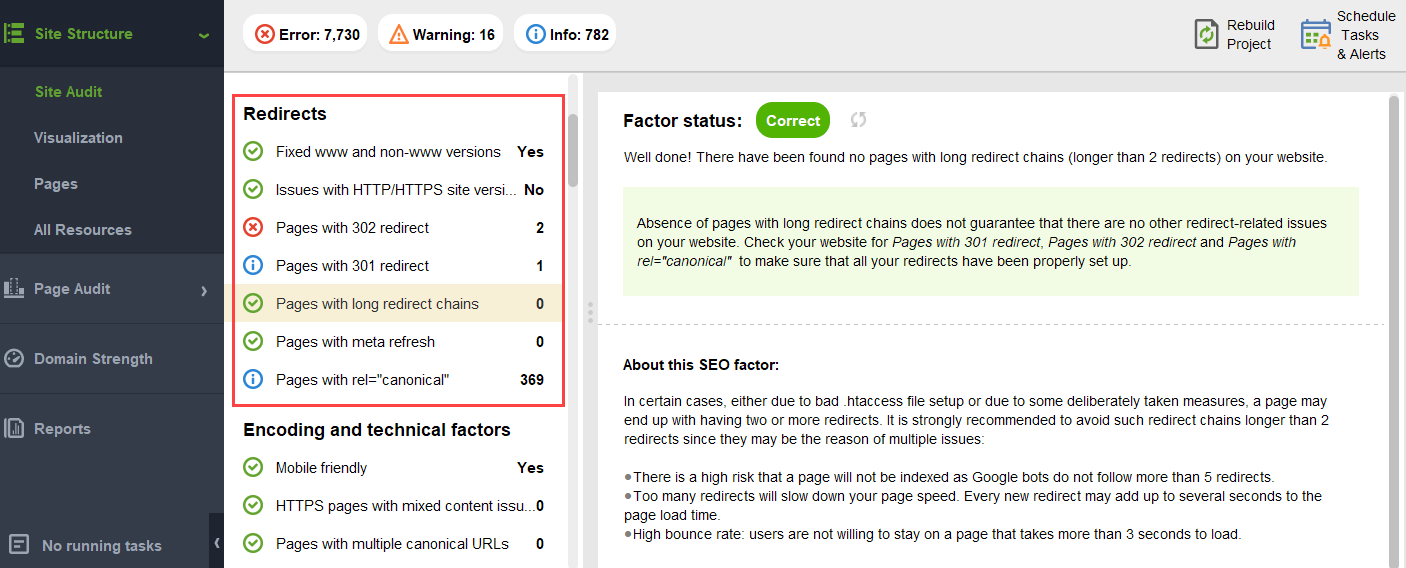

omdirigera kedjor. Även om Google säger att omdirigeringar nu passerar 100% av PR, rekommenderas det fortfarande att undvika långa omdirigeringskedjor. Först äter de upp din krypbudget ändå. För det andra vet vi att vi inte blint kan tro på allt som Google säger.

-

länkar i unparseable JavaScript. Eftersom Google inte kan läsa dem kommer de inte att passera PageRank.

-

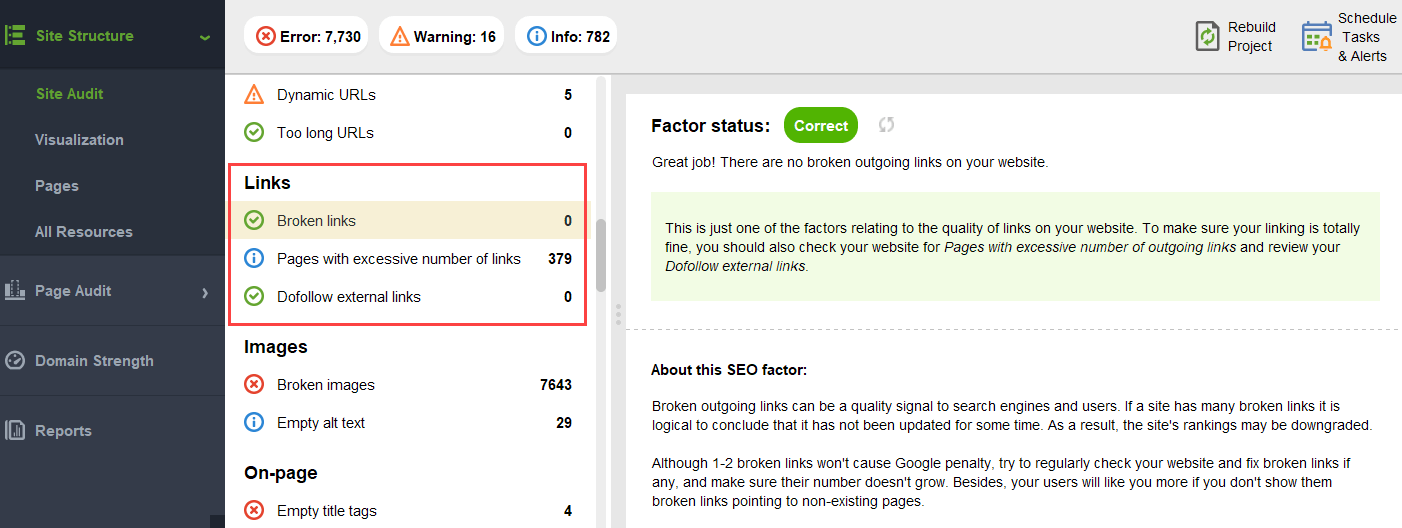

404 länkar. 404 länkar leder till ingenstans, så PageRank går ingenstans också.

-

länkar till oviktiga sidor. Naturligtvis kan du inte lämna någon av dina sidor utan länkar alls, men sidor skapas inte lika. Om någon sida är mindre viktig är det inte rationellt att lägga för mycket ansträngning på att optimera länkprofilen på den sidan.

-

för avlägsna sidor. Om en sida ligger för djupt på din webbplats, är det troligt att få lite PR eller ingen PR alls. Eftersom Google kanske inte lyckas hitta och indexera det.

för att se till att din webbplats är fri från dessa PageRank-faror kan du granska den med WebSite Auditor. Det här verktyget har en omfattande uppsättning moduler inom webbplatsstrukturen > Site Audit-sektionen, som låter dig kontrollera den övergripande optimeringen av din webbplats och naturligtvis hitta och åtgärda alla länkrelaterade problem, till exempel långa omdirigeringar:

och trasiga länkar:

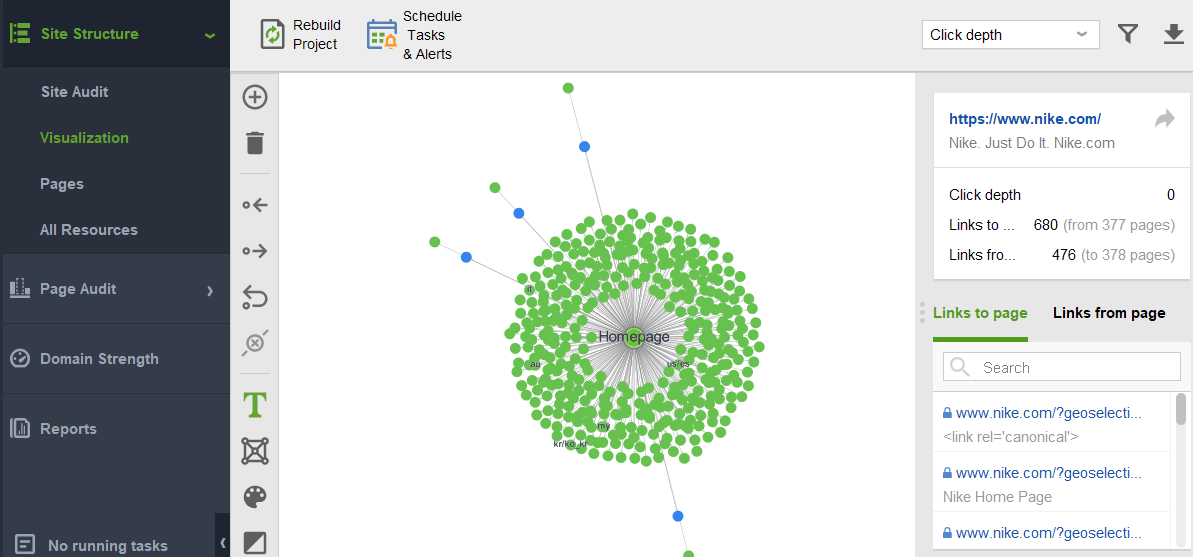

för att kontrollera din webbplats för anonyma sidor eller sidor som är för avlägsna, byt till webbplatsstruktur > visualisering:

framtiden för PageRank

i år PageRank har vänt 23. Och jag antar att det är äldre än några av våra läsare idag:) men vad kommer för PageRank i framtiden? Kommer det att försvinna helt en dag?

sökmotorer utan bakåtlänkar

när man försöker tänka på en populär sökmotor som inte använder bakåtlänkar i sin algoritm, är den enda tanken Jag kan komma med Yandex-experimentet tillbaka 2014. Sökmotorn meddelade att släppa bakåtlänkar från sin algoritm kan slutligen stoppa länk spammare från manipulationer och bidra till att rikta sina ansträngningar till kvalitet webbplats skapande.

det kan ha varit ett genuint försök att gå mot alternativa rankningsfaktorer, eller bara ett försök att övertyga massorna att släppa länkspam. Men i alla fall, på bara ett år från tillkännagivandet, bekräftade Yandex backlink faktorer var tillbaka i sitt system.

men varför är bakåtlänkar så oumbärliga för sökmotorer?

även om det finns otaliga andra datapunkter för att omorganisera sökresultaten efter att ha börjat visa dem (som användarbeteende och Bert-justeringar), är bakåtlänkar fortfarande ett av de mest tillförlitliga auktoritetskriterierna som behövs för att bilda den ursprungliga SERP. Deras enda konkurrent här är förmodligen enheter.

som Bill Slawski uttrycker det när han frågas om framtiden för PageRank:

Google utforskar maskininlärning och faktautvinning och förstår nyckelvärdespar för affärsenheter, vilket innebär en rörelse mot semantisk sökning och bättre användning av strukturerad data och datakvalitet.

Bill Slawski, SEO vid havet

ändå är Google ganska olikt att kasta bort något de har investerat tiotals år av utveckling i.

Google är mycket bra på länkanalys, som nu är en mycket mogen webbteknik. På grund av det är det mycket möjligt att PageRank fortsätter att användas för att rangordna organiska SERP.

Bill Slawski, SEO vid havet

Nyheter och andra tidskänsliga resultat

en annan trend Bill Slawski pekade på var nyheter och andra kortlivade typer av sökresultat:

Google har berättat för oss att det har förlitat sig mindre på PageRank för sidor där aktualitet är viktigare, till exempel realtidsresultat (som från Twitter) eller från nyhetsresultat, där aktualitet är mycket viktigt.

Bill Slawski, SEO vid havet

faktum är att en nyhet lever i sökresultaten alldeles för lite för att samla tillräckligt med bakåtlänkar. Så Google har varit och kan fortsätta arbeta för att ersätta bakåtlänkar med andra rankningsfaktorer när man hanterar nyheter.

men för närvarande är nyhetsrankningar mycket bestämda av förlagets nischauktoritativitet, och vi läser fortfarande auktoritativitet som bakåtlänkar:

”Auktoritativitetssignaler hjälper till att prioritera högkvalitativ information från de mest tillförlitliga tillgängliga källorna. För att göra detta är våra system utformade för att identifiera signaler som kan hjälpa till att avgöra vilka sidor som visar expertis, auktoritativitet och pålitlighet i ett visst ämne, baserat på feedback från Sökratrar. Dessa signaler kan inkludera om andra människor värderar källan för liknande frågor eller om andra framstående webbplatser om ämnet länkar till berättelsen.”

nya rel=”sponsrade” och rel=”UGC” attribut

sist men inte minst blev jag ganska förvånad över den ansträngning som Google gjorde för att kunna identifiera sponsrade och användargenererade bakåtlänkar och skilja dem från andra nofollowed länkar.

om alla dessa bakåtlänkar ska ignoreras, varför bry sig om att berätta för varandra? Speciellt med John Muller som föreslår att Google senare kan försöka behandla dessa typer av länkar annorlunda.

min vildaste gissning här var att kanske Google validerar om reklam och användargenererade länkar kan bli en positiv rankningssignal.

när allt kommer omkring kräver reklam på populära plattformar enorma budgetar, och stora budgetar är ett attribut för ett stort och populärt varumärke.

användargenererat innehåll, när det betraktas utanför kommentarspamparadigmet, handlar om verkliga kunder som ger sina verkliga godkännanden.

men experterna jag nådde ut till trodde inte att det var möjligt:

jag tvivlar på att Google någonsin skulle betrakta sponsrade länkar som en positiv signal.

Barry Schwartz, sökmotor rundabordssamtal

tanken här verkar vara att genom att skilja olika typer av länkar skulle Google försöka ta reda på vilka av nofollow-länkarna som ska följas för enhetsbyggande ändamål:

Google har inga problem med användargenererat innehåll eller sponsrat innehåll på en webbplats, men båda har historiskt använts som metoder för att manipulera pagerank. Som sådan uppmuntras webbansvariga att placera ett nofollow-attribut på dessa länkar (bland andra skäl för att använda nofollow).Nofollowed-länkar kan dock fortfarande vara till hjälp för Google för saker (som entity recognition till exempel), så de har tidigare noterat att de kan behandla detta som ett mer förslag, och inte ett direktiv som en robotar.txt disallow rule skulle vara på din egen webbplats.John Muellers uttalande var ” jag kunde föreställa mig i våra system att vi kan lära oss över tid att behandla dem lite annorlunda.”Detta kan hänvisa till de fall där Google behandlar en nofollow som ett förslag. Hypotetiskt är det möjligt att Googles system kan lära sig vilka nofollowed länkar att följa baserat på insikter som samlats in från de typer av länkar som är markerade som ugc och sponsrade. Återigen borde detta inte ha stor inverkan på webbplatsens ranking – men det kan teoretiskt ha en inverkan på webbplatsen som länkas också.

Callum Scott, Marie Haynes Consulting

.png)