The Past, Present & Future of Google PageRank

algorytm PageRank (lub PR w skrócie) to system rankingowy stron internetowych opracowany przez Larry Page i Sergey Brin na Uniwersytecie Stanforda w późnych latach 90. PageRank był w rzeczywistości stroną bazową, a Brin stworzył wyszukiwarkę Google.

od tego czasu minęło wiele lat i oczywiście algorytmy rankingowe Google stały się znacznie bardziej skomplikowane. Czy nadal są oparte na PageRank? Jak dokładnie wpływa PageRank na ranking i na co SEO powinny się przygotować w przyszłości? Teraz znajdziemy i podsumujemy wszystkie fakty i tajemnice wokół PageRank, aby obraz był jasny. Na ile się da.

przeszłość PageRank

jak wspomniano powyżej, w swoim projekcie badawczym, Brin i Page próbowali wymyślić system do oceny autorytetu stron internetowych. Postanowili zbudować ten system na linkach, które służyły jako głosy zaufania udzielone stronie. Zgodnie z logiką tego mechanizmu, im więcej zewnętrznych zasobów łączy się ze stroną, tym więcej cennych informacji ma ona dla użytkowników. A PageRank (wynik od 0 do 10 obliczany na podstawie ilości i jakości linków przychodzących) pokazał względny autorytet strony w Internecie.

oryginalny wzór PageRank

przyjrzyjmy się jak działa PageRank. Każdy link od jednej strony (a) do drugiej (B) rzuca tak zwany głos, którego waga zależy od zbiorowej wagi wszystkich stron, które prowadzą do strony A. Nie możemy poznać ich wagi, dopóki jej nie obliczymy, więc proces przebiega w cyklach.

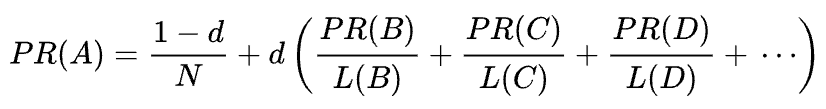

wzór matematyczny oryginalnego PageRank jest następujący:

gdzie A, B, C i D to niektóre strony, L to liczba linków wychodzących z każdej z nich, a n to całkowita liczba stron w zbiorze (np. w Internecie).

jeśli chodzi o d, d jest tzw. współczynnikiem tłumienia. Biorąc pod uwagę, że PageRank jest obliczany symulując zachowanie użytkownika, który losowo dostaje się do strony i klika linki, stosujemy ten współczynnik tłumienia d jako prawdopodobieństwo, że użytkownik znudzi się i opuści stronę.

jak widać ze wzoru, jeśli nie ma stron wskazujących na stronę, jej PR nie będzie równy zero, ale

, ponieważ istnieje prawdopodobieństwo, że użytkownik może dostać się do tej strony nie z innych stron, ale powiedzmy z zakładek.

podatność na manipulację PageRank I wojna Google ze spamem linków

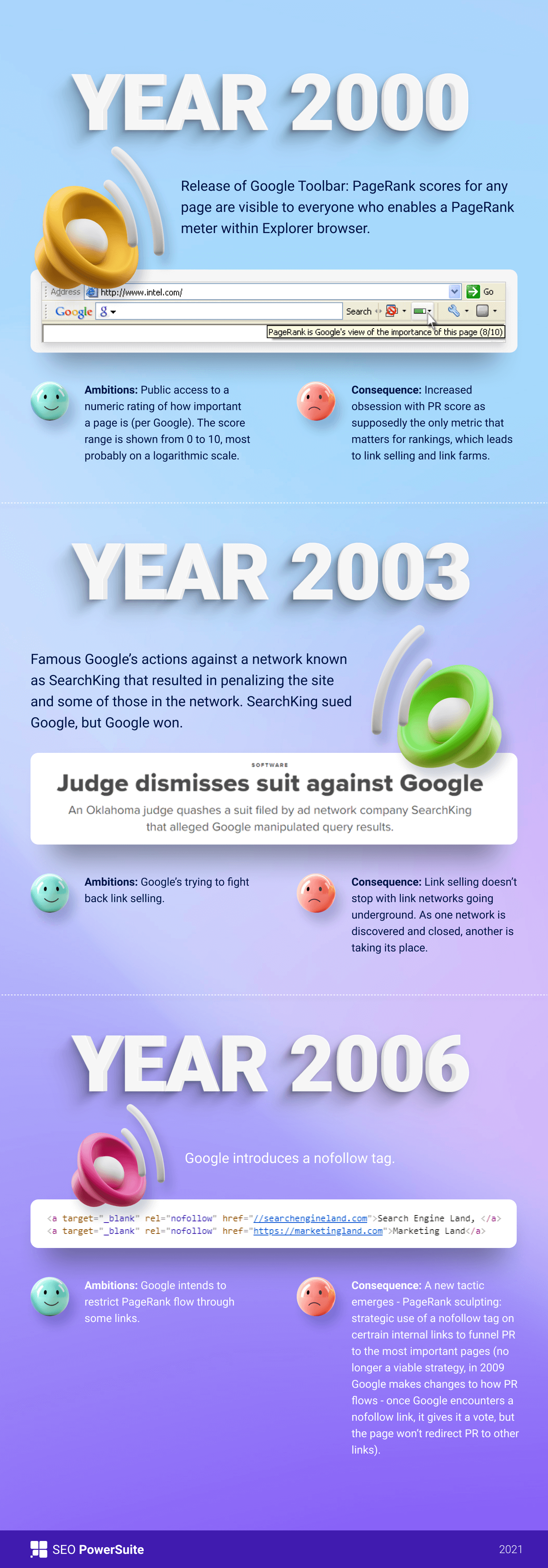

na początku wynik PageRank był publicznie widoczny w pasku narzędzi Google, a każda strona miała swój wynik od 0 do 10, najprawdopodobniej w skali logarytmicznej.

algorytmy rankingowe Google w tamtych czasach były naprawdę proste-wysoki PR i gęstość słów kluczowych były jedynymi dwiema rzeczami, które strona potrzebowała, aby uplasować się wysoko na SERP. W rezultacie strony internetowe zostały wypełnione słowami kluczowymi, a Właściciele witryn zaczęli manipulować PageRank przez sztucznie rosnące spamerskie linki zwrotne. To było łatwe — farmy linków i sprzedaż linków były po to, aby dać właścicielom witryn „pomocną dłoń.”

Google postanowiło walczyć ze spamem link W 2003 roku Google ukarało stronę internetową firmy sieci reklamowej SearchKing za manipulacje linkami. SearchKing pozwał Google, ale Google wygrał. Był to sposób, w jaki Google próbował ograniczyć wszystkim manipulacje linkami, jednak nie doprowadziło to do niczego. Farmy Link po prostu zeszły pod ziemię, a ich ilość znacznie wzrosła.

poza tym spamerskie komentarze na blogach też się mnożą. Boty zaatakowały komentarze dowolnego, powiedzmy, bloga WordPress i pozostawiły ogromną liczbę komentarzy „kliknij tutaj, aby kupić magiczne pigułki”. Aby zapobiec manipulacji spamem i PR w komentarzach, Google wprowadziło tag nofollow w 2005 roku. I jeszcze raz, to, co Google miało stać się udanym krokiem w wojnie manipulacji linkami, zostało zaimplementowane w Pokręcony sposób. Ludzie zaczęli używać tagów nofollow do sztucznego lejka PageRank do potrzebnych stron. Ta taktyka stała się znana jako rzeźbienie PageRank.

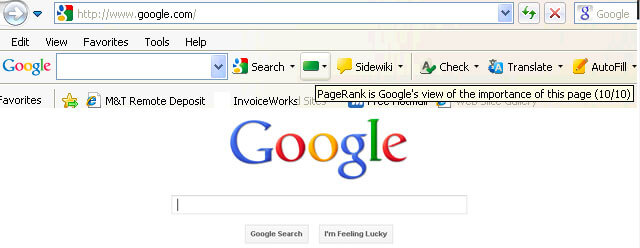

aby zapobiec PR, Google zmieniło sposób przepływu PageRank. Wcześniej, jeśli strona miała zarówno linki nofollow, jak i dofollow, cała objętość PR strony została przekazana do innych stron powiązanych z linkami dofollow. W 2009 roku Google zaczęło dzielić PR strony równo między wszystkie linki, które miała strona, ale przekazując tylko te udziały, które zostały podane do linków dofollow.

zrobione z rzeźbienia PageRank, Google nie zatrzymać link spam wojny i zaczął konsekwentnie biorąc wynik PageRank z oczu opinii publicznej. Po pierwsze, Google uruchomił nową przeglądarkę Chrome bez Google Toolbar, gdzie pokazano wynik PR. Potem przestali raportować wynik PR w Google Search Console. Następnie przeglądarka Firefox przestała obsługiwać Google Toolbar. W 2013 roku PageRank został zaktualizowany dla Internet Explorera po raz ostatni, a w 2016 roku Google oficjalnie zamknęło pasek narzędzi dla publiczności.

jeszcze jednym sposobem walki Google z schematami linków była aktualizacja pingwina, która usuwała rankingi stron z podejrzanymi profilami linków zwrotnych. Wprowadzony w 2012 roku, Penguin nie stał się częścią algorytmu czasu rzeczywistego Google, ale był raczej „filtrem” aktualizowanym i ponownie wprowadzanym do wyników wyszukiwania co jakiś czas. Jeśli strona została ukarana przez pingwina, SEO musiał dokładnie przejrzeć swoje profile linków i usunąć toksyczne linki, lub dodać je do listy disavow (funkcja wprowadzona w tamtych czasach, aby powiedzieć Google, które linki przychodzące zignorować przy obliczaniu PageRank). Po sprawdzeniu profili linków w ten sposób, SEO musiał czekać około pół roku, aż algorytm pingwina ponownie obliczy dane.

w 2016 roku Google uczyniło pingwina częścią swojego podstawowego algorytmu rankingu. Od tego czasu działa w czasie rzeczywistym, algorytmicznie radząc sobie ze spamem znacznie skuteczniej.

jednocześnie Google pracował nad ułatwieniem jakości, a nie ilości linków, przybijając ją w swoich wytycznych dotyczących jakości w stosunku do schematów linków.

teraźniejszość PageRank

Cóż, skończyliśmy z przeszłością PageRank. Co się teraz dzieje?

w 2019 r. były pracownik Google powiedział, że oryginalny algorytm PageRank nie był używany od 2006 r.i został zastąpiony innym, mniej zasobochłonnym algorytmem, gdy Internet stawał się coraz większy. Co może być prawdą, ponieważ w 2006 roku Google złożyło nowy ranking stron wykorzystujących odległości w patencie na wykresy linków internetowych.

czy algorytm PageRank jest dzisiaj stosowany?

tak, jest. Nie jest to ten sam PageRank, co na początku 2000 roku, ale Google mocno opiera się na autorytecie linków. Na przykład były pracownik Google Andrey Lipattsev wspomniał o tym w 2016 roku. W Google Q&a hangout użytkownik zapytał go, jakie są główne sygnały rankingowe, z których korzystał Google. Odpowiedź Andreya była dość prosta.

mogę ci powiedzieć, czym są. Jest to treść i linki prowadzące do twojej witryny.

Andrey Lipattsev

w 2020 roku John Mueller potwierdził, że po raz kolejny:

tak, używamy Pagerank wewnętrznie, wśród wielu, wielu innych sygnałów. To nie jest to samo, co oryginalny papier, istnieje wiele dziwactw (np. odrzucone linki, ignorowane linki itp.) i ponownie używamy wielu innych sygnałów, które mogą być znacznie silniejsze.

John Mueller

jak widać, PageRank jest nadal żywy i aktywnie wykorzystywany przez Google podczas rankingu stron w Internecie.

co ciekawe, pracownicy Google ciągle przypominają nam, że jest wiele, wiele, wiele innych sygnałów rankingowych. Ale patrzymy na to z przymrużeniem oka. Biorąc pod uwagę, ile wysiłku Google poświęca walce ze spamem linków, może być interesujące Google, aby wyłączyć uwagę SEO z czynników podatnych na manipulację (jak linki zwrotne) i skierować tę uwagę na coś niewinnego i miłego. Ale ponieważ SEO są dobre w czytaniu między wierszami, wciąż rozważają PageRank silny sygnał rankingowy i rozwijają linki zwrotne na wszystkie sposoby. Nadal używają PBN, ćwiczą budowanie linków w szarym kapeluszu, kupują linki i tak dalej, tak jak to było dawno temu. Jak Pagerank żyje, link spam też będzie żył. Nie polecamy tego, ale taka jest rzeczywistość SEO i musimy to zrozumieć.

losowy Surfer vs. rozsądny SURFER o PageRank

Cóż, masz pomysł, że PageRank teraz nie jest PageRank to było 20 lat temu.

jedną z kluczowych modernizacji PR było przejście z pokrótce wspomnianego powyżej modelu Random Surfer do rozsądnego modelu Surfer w 2012 roku. Rozsądny Surfer zakłada, że użytkownicy nie zachowują się chaotycznie na stronie i klikają tylko te linki, którymi są w danej chwili zainteresowani. Powiedzmy, że czytając artykuł na blogu, bardziej prawdopodobne jest, że klikniesz link w treści artykułu, a nie link do Warunków Użytkowania w stopce.

ponadto rozsądny Surfer może potencjalnie wykorzystać wiele innych czynników przy ocenie atrakcyjności linku. Wszystkie te czynniki zostały dokładnie przeanalizowane przez Billa Sławskiego w jego artykule, ale chciałbym skupić się na tych dwóch czynnikach, które SEO omawiają częściej. Są to pozycja łącza i ruch na stronie. Co możemy powiedzieć o tych czynnikach?

korelacja między pozycją linku a autorytetem linku

link może znajdować się w dowolnym miejscu na stronie — w jej treści, menu nawigacyjnym, bio autora, stopce, a właściwie każdym elemencie strukturalnym, który zawiera strona. Różne lokalizacje łącza wpływają na wartość łącza. Potwierdził to John Mueller, mówiąc, że linki umieszczone w głównej treści ważą więcej niż wszystkie pozostałe:

to jest obszar strony, w którym masz swoją podstawową zawartość, zawartość, o której tak naprawdę chodzi, a nie menu, pasek boczny, stopka, nagłówek … to jest coś, co bierzemy pod uwagę i staramy się używać tych linków.

John Mueller

mówi się, że linki do stopki i linki nawigacyjne mają mniejszą wagę. I ten fakt od czasu do czasu jest potwierdzany nie tylko przez rzeczników Google, ale przez rzeczywiste przypadki.

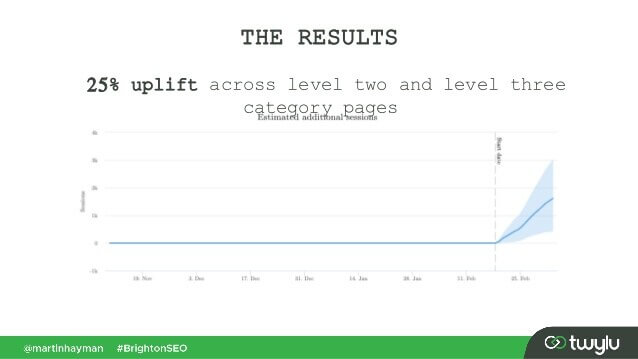

w niedawnym przypadku przedstawionym przez Martina Haymana w BrightonSEO, Martin dodał link, który już miał w swoim menu nawigacyjnym, do głównej zawartości stron. W rezultacie strony kategorii i strony, do których prowadzą linki, zwiększyły ruch o 25%.

ten eksperyment dowodzi, że linki treści przechodzą większą wagę niż jakiekolwiek inne.

co do linków w bio autora, SEO zakładają, że linki bio coś ważą, ale są mniej wartościowe niż np. linki treści. Chociaż nie mamy tutaj zbyt wielu dowodów, ale na to, co powiedział Matt Cutts, gdy Google aktywnie zwalczało nadmierne blogowanie gości o linki zwrotne.

korelacja między ruchem, zachowaniem użytkowników i autorytetem linków

John Mueller wyjaśnił, w jaki sposób Google traktuje ruch i zachowania użytkowników pod względem przekazywania soku linków w jednym z centralnych Hangoutów Search Console. Użytkownik zapytał Muellera, czy Google bierze pod uwagę prawdopodobieństwo kliknięcia i liczbę kliknięć łącza przy ocenie jakości łącza. Kluczowymi odpowiedziami Muellera były:

-

Google nie bierze pod uwagę kliknięć łącza i prawdopodobieństwa kliknięcia podczas oceny jakości łącza.

-

Google rozumie, że linki są często dodawane do treści, takich jak odniesienia, a użytkownicy nie powinni klikać każdego napotkanego linku.

mimo to, jak zawsze, SEO wątpi, czy warto ślepo wierzyć we wszystko, co mówi Google, i eksperymentować dalej. Tak więc chłopaki z Ahrefs przeprowadzili badanie, aby sprawdzić, czy pozycja strony na SERP jest powiązana z liczbą linków zwrotnych, które ma ze stron o dużym natężeniu ruchu. Badania wykazały, że nie ma prawie żadnej korelacji. Co więcej, niektóre Najwyżej oceniane strony okazały się nie mieć linków zwrotnych ze stron bogatych w ruch.

to badanie wskazuje nam podobny kierunek, jak słowa Johna Muellera – nie musisz budować linków zwrotnych generujących ruch do swojej strony, aby uzyskać wysokie pozycje na SERP. Z drugiej strony dodatkowy ruch nigdy nie zaszkodził żadnej stronie internetowej. Jedyną wiadomością jest to, że linki zwrotne bogate w ruch nie wydają się wpływać na rankingi Google.

Tagi nofollow, sponsorowane i UGC

jak pamiętacie, Google wprowadziło tag nofollow w 2005 roku jako sposób na walkę ze spamem linków. Coś się dzisiaj zmieniło? Właściwie to tak.

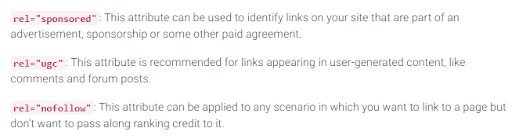

Po Pierwsze, Google wprowadziło ostatnio dwa kolejne typy atrybutu nofollow. Wcześniej Google zasugerował zaznaczenie wszystkich linków zwrotnych, których nie chcesz brać udziału w obliczaniu PageRank jako nofollow, czy to komentarze na blogu, czy płatne reklamy. Obecnie Google zaleca używanie rel= „sponsored”dla płatnych i partnerskich linków i rel=” ugc ” dla treści generowanych przez użytkowników.

interesujące jest to, że te nowe Tagi nie są obowiązkowe (przynajmniej jeszcze nie), a Google zwraca uwagę, że nie musisz ręcznie zmieniać wszystkich rel=”nofollow” na rel=”sponsored” i rel=”ugc”. Te dwa nowe atrybuty działają teraz tak samo jak zwykły tag nofollow.

po drugie, Google mówi teraz, że tagi nofollow, a także nowe, sponsorowane i ugc, są traktowane jako wskazówki, a nie dyrektywa podczas indeksowania stron.

linki wychodzące i ich wpływ na rankingi

oprócz linków przychodzących istnieją również linki wychodzące, tj. linki, które prowadzą do innych stron z twojej strony.

wiele SEO uważa, że linki wychodzące mogą mieć wpływ na rankingi, ale to założenie zostało potraktowane jako mit SEO. Ale jest jedno interesujące badanie, aby przyjrzeć się w tym zakresie.

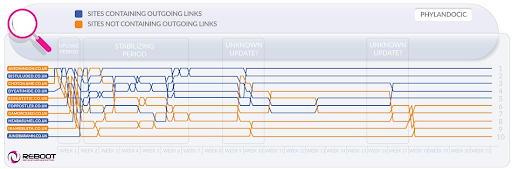

Reboot Online przeprowadził eksperyment w 2015 i ponownie uruchomił go w 2020. Chcieli dowiedzieć się, czy obecność linków wychodzących do stron o wysokich autorytetach wpływa na pozycję strony na SERP. Stworzyli 10 stron internetowych z artykułami 300-słownymi, wszystkie zoptymalizowane pod kątem nieistniejącego słowa kluczowego-Phylandocic. 5 stron internetowych pozostawiono bez linków wychodzących w ogóle, a 5 stron internetowych zawierało linki wychodzące do zasobów Wysokiej Władzy. W rezultacie strony z autorytatywnymi linkami wychodzącymi zaczęły zajmować najwyższe pozycje, a te, które w ogóle nie mają linków, zajęły najniższe pozycje.

z jednej strony Wyniki tych badań mogą nam powiedzieć, że linki wychodzące mają wpływ na pozycję stron. Z drugiej strony wyszukiwany termin w badaniach jest zupełnie nowy, a zawartość stron internetowych jest tematycznie związana z medycyną i lekami. Więc są duże szanse, że zapytanie zostało zaklasyfikowane jako YMYL. A Google wielokrotnie podkreślał znaczenie E-A-T dla stron internetowych YMYL. Tak więc obwieszczenia mogły zostać potraktowane jako sygnał E-A-T, dowodzący, że strony mają faktyczną treść.

co do zwykłych zapytań (nie YMYL), John Mueller wielokrotnie powtarzał, że nie musisz się obawiać linkowania do zewnętrznych źródeł z treści, ponieważ linki wychodzące są dobre dla użytkowników.

poza tym linki wychodzące mogą być również korzystne dla SEO, ponieważ mogą być brane pod uwagę przez Google AI podczas filtrowania sieci ze spamu. Ponieważ strony spamowe mają zwykle niewiele linków wychodzących, jeśli w ogóle istnieją. Linkują do stron pod tą samą domeną (jeśli kiedykolwiek pomyślą o SEO) lub zawierają tylko płatne linki. Tak więc, jeśli linkujesz do wiarygodnych zasobów, w pewnym sensie pokazujesz Google, że Twoja strona nie jest spamem.

kiedyś była opinia, że Google może dać ci ręczną karę za posiadanie zbyt wielu linków wychodzących, ale John Mueller powiedział, że jest to możliwe tylko wtedy, gdy linki wychodzące są oczywiście częścią jakiegoś systemu wymiany linków, plus strona jest ogólnie słaba jakość. To, co Google oznacza pod oczywistością, jest w rzeczywistości tajemnicą, więc pamiętaj o zdrowym rozsądku, wysokiej jakości treściach i podstawowym SEO.

Google walczy ze spamem linków

dopóki istnieje PageRank, SEO będą szukać nowych sposobów manipulowania nim.

w 2012 roku Google było bardziej prawdopodobne, aby zwolnić ręczne działania dotyczące manipulacji linkami i spamu. Ale teraz, dzięki dobrze wyszkolonym algorytmom antyspamowym, Google jest w stanie po prostu zignorować pewne linki spamowe podczas obliczania PageRank, a nie ogólnie obniżać całą witrynę. Jak powiedział John Mueller,

losowe linki zbierane przez lata niekoniecznie są szkodliwe, widzieliśmy je od dawna i możemy zignorować wszystkie te dziwne kawałki graffiti z dawno temu.

John Mueller

dotyczy to również negatywnego SEO, gdy twój profil linku zwrotnego jest zagrożony przez konkurencję:

ogólnie rzecz biorąc, automatycznie bierzemy je pod uwagę i staramy się … ignorować je automatycznie, gdy widzimy, że się dzieją. W większości przypadków podejrzewam, że działa to całkiem dobrze. Widzę bardzo niewielu ludzi z rzeczywistymi problemami wokół tego. Więc myślę, że to w większości działa dobrze. Jeśli chodzi o wyparcie się tych linków, podejrzewam, że jeśli są to po prostu normalne linki spamowe, które pojawiają się na twojej stronie, to nie martwiłbym się o nie zbytnio. Pewnie sami się domyśliliśmy.

John Mueller

nie oznacza to jednak, że nie masz się czym martwić. Jeśli linki zwrotne Twojej witryny zostaną zbyt często i zbyt często ignorowane, nadal masz dużą szansę na ręczne działanie. Jak mówi Marie Haynes w swoich poradach na temat zarządzania łączami w 2021:

ręczne działania są zarezerwowane dla przypadków, w których przyzwoita strona ma nienaturalne linki wskazujące na nią w skali tak dużej, że algorytmy Google nie są wygodne, ignorując je.

Marie Haynes

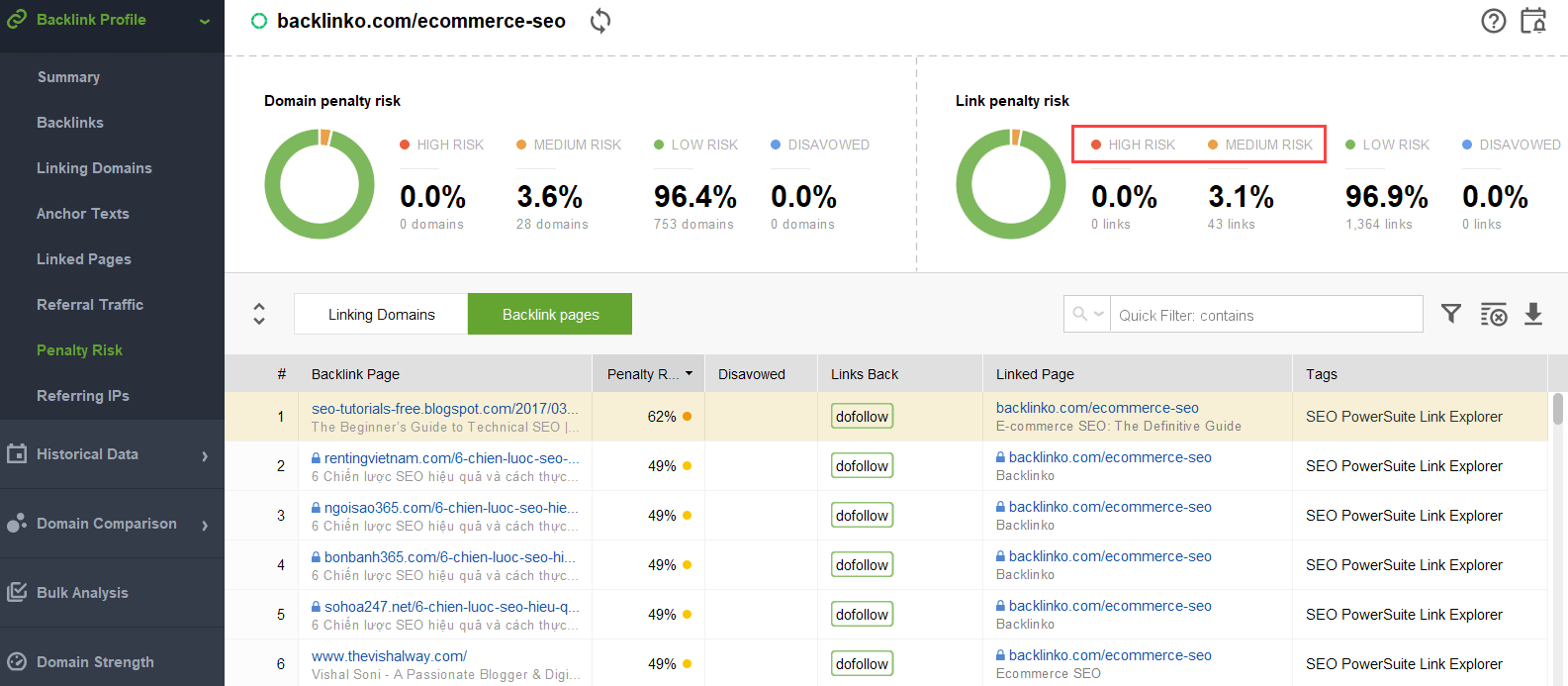

aby spróbować dowiedzieć się, jakie linki wywołują problem, możesz użyć kontrolera linków zwrotnych, takiego jak SEO SpyGlass. W narzędziu przejdź do profilu Backlink > sekcja ryzyka karnego. Zwróć uwagę na linki zwrotne wysokiego i średniego ryzyka.

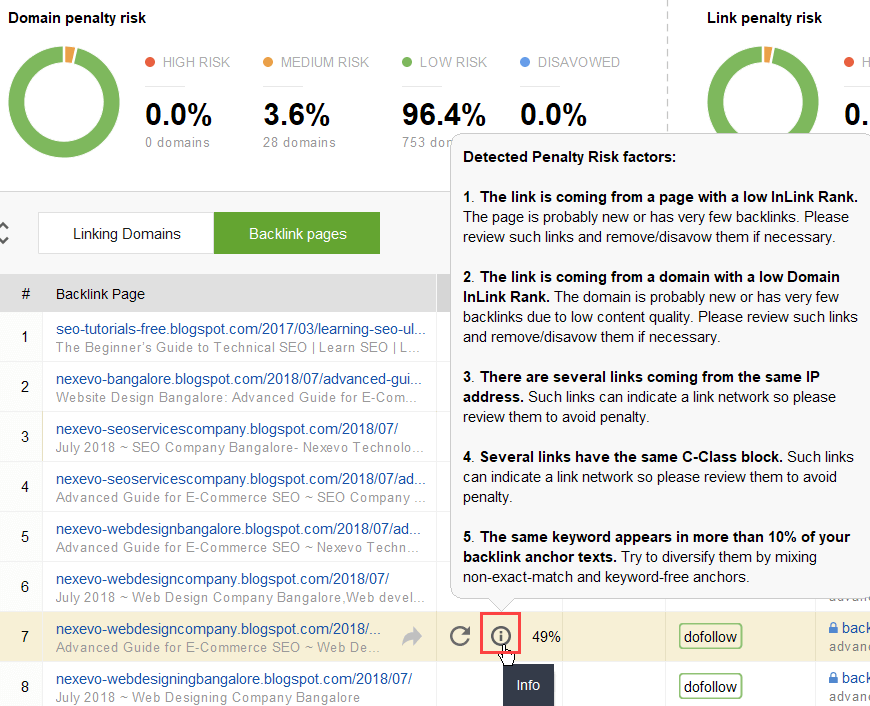

aby dokładniej zbadać, dlaczego ten lub inny link jest zgłaszany jako szkodliwy, kliknij i zaloguj się w kolumnie ryzyka karnego. Tutaj zobaczysz, dlaczego narzędzie uznało link za zły i zdecyduj się, czy wyrzekniesz się linku, czy nie.

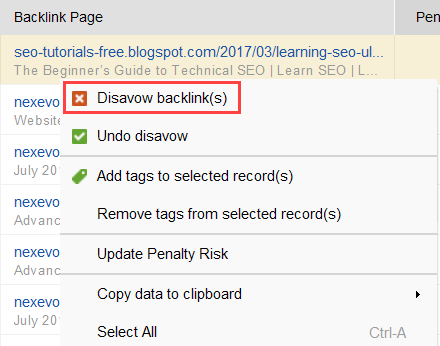

jeśli zdecydujesz się odrzucić link z grupy linków, kliknij je prawym przyciskiem myszy i wybierz opcję Odrzuć linki zwrotne:

po utworzeniu listy linków do wykluczenia możesz wyeksportować plik dezawuacji z SEO SpyGlass i przesłać go do Google za pośrednictwem GSC.

linkowanie wewnętrzne

mówiąc o PageRank, nie możemy nie wspomnieć o linkowaniu wewnętrznym. Przychodzący PageRank jest czymś, czego nie możemy kontrolować, ale możemy całkowicie kontrolować sposób, w jaki PR jest rozpowszechniany na stronach naszej witryny.

Google wielokrotnie podkreślało znaczenie linkowania wewnętrznego. John Mueller podkreślił to po raz kolejny w jednym z najnowszych Hangoutów Search Console Central. Użytkownik zapytał, jak zwiększyć moc niektórych stron internetowych. John Mueller powiedział co następuje:

…Możesz pomóc w łączeniu wewnętrznym. Tak więc w swojej witrynie możesz naprawdę wyróżnić strony, które chcesz wyróżnić bardziej i upewnić się, że są naprawdę dobrze połączone wewnętrznie. A może strony, które nie są dla Ciebie ważne, upewnij się, że są nieco mniej powiązane wewnętrznie.

John Mueller

wewnętrzne linkowanie wiele znaczy. Pomaga udostępniać przychodzące PageRank między różnymi stronami w witrynie, wzmacniając w ten sposób swoje słabsze strony i wzmacniając ogólną stronę.

jeśli chodzi o podejścia do linkowania wewnętrznego, SEO mają wiele różnych teorii. Jedno z popularnych podejść jest związane z głębokością klikania na stronie. Ten pomysł mówi, że wszystkie strony w Twojej witrynie muszą znajdować się w maksymalnej odległości 3 kliknięć od strony głównej. Chociaż Google wielokrotnie podkreślał znaczenie płytkiej struktury witryny, w rzeczywistości wydaje się to nieosiągalne dla wszystkich większych niż małe stron internetowych.

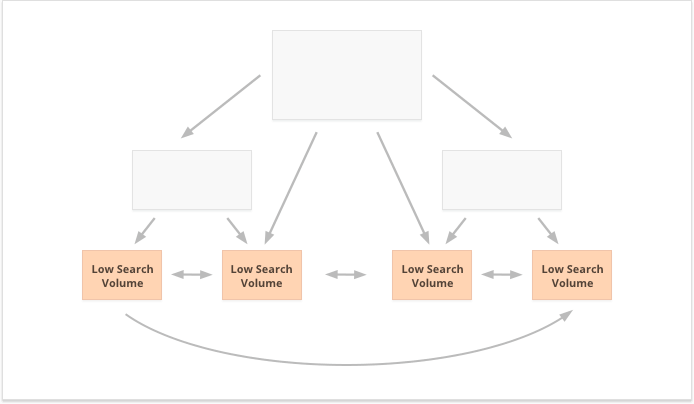

jeszcze jedno podejście opiera się na koncepcji scentralizowanego i zdecentralizowanego linkowania wewnętrznego. Jak opisuje to Kevin Indig:

scentralizowane witryny mają pojedynczy przepływ użytkownika i lejek, który wskazuje na jedną kluczową stronę. Witryny ze zdecentralizowanym linkowaniem wewnętrznym mają wiele punktów styku konwersji lub różne formaty rejestracji.

Kevin Indig

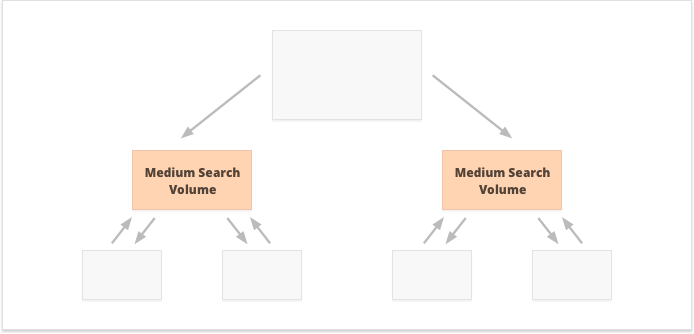

w przypadku scentralizowanego linkowania wewnętrznego mamy małą grupę stron konwersji lub jedną stronę, którą chcemy być potężni. Jeśli zastosujemy zdecentralizowane wewnętrzne linkowanie, chcemy, aby wszystkie strony witryny były równie potężne i miały równy PageRank, aby wszystkie były w randze dla Twoich zapytań.

która opcja jest lepsza? Wszystko zależy od twojej witryny i niszowych cech biznesowych oraz od słów kluczowych, które zamierzasz kierować. Na przykład scentralizowane wewnętrzne linkowanie lepiej pasuje do słów kluczowych o dużej i średniej objętości wyszukiwania, ponieważ powoduje wąski zestaw super potężnych stron.

słowa kluczowe o długim ogonie z niską objętością wyszukiwania, wręcz przeciwnie, są lepsze dla zdecentralizowanego linkowania wewnętrznego, ponieważ rozprzestrzenia PR równo wśród wielu stron internetowych.

jeszcze jednym aspektem udanego linkowania wewnętrznego jest równowaga linków przychodzących i wychodzących na stronie. W związku z tym wiele SEO używa CheiRank (CR), który jest w rzeczywistości odwrotnym PageRank. Ale podczas gdy PageRank jest otrzymaną mocą, CheiRank jest dawaną mocą łącza. Po obliczeniu PR i CR dla Twoich stron, możesz zobaczyć, jakie strony mają anomalie linków, tj. przypadki, gdy strona otrzymuje dużo PageRank, ale przechodzi dalej trochę i odwrotnie.

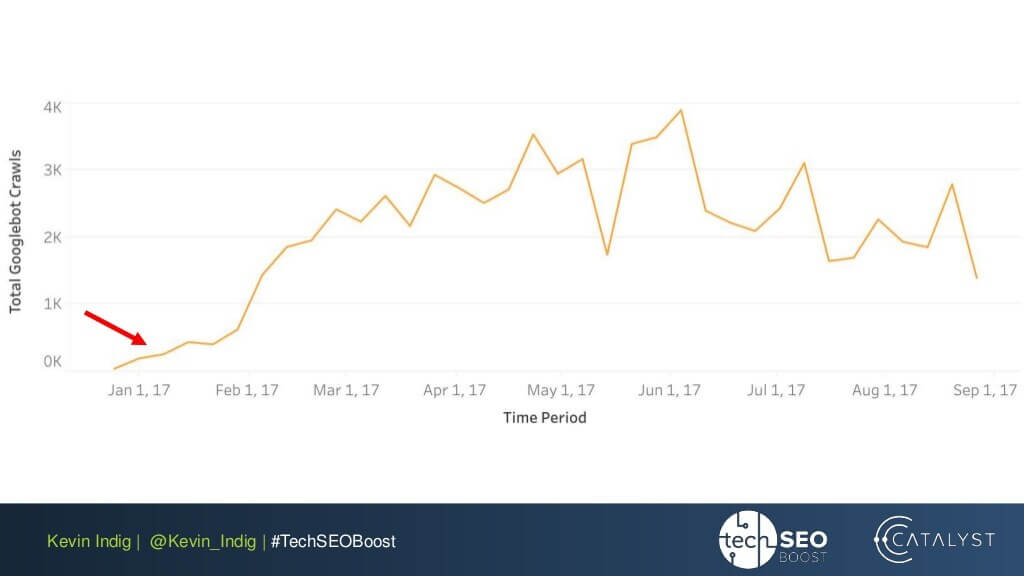

ciekawym eksperymentem jest tutaj spłaszczenie anomalii łącza przez Kevina Indiga. Po prostu upewnienie się, że Pagerank przychodzący i wychodzący jest zrównoważony na każdej stronie witryny przyniosło bardzo imponujące wyniki. Czerwona strzałka wskazuje czas, kiedy anomalie zostały naprawione:

anomalie linków nie są jedyną rzeczą, która może zaszkodzić przepływowi PageRank. Upewnij się, że nie utkniesz z żadnymi problemami technicznymi, które mogłyby zniszczyć twój ciężko zarobiony PR:

-

strony osierocone. Strony osierocone nie są linkowane do żadnej innej strony w Twojej witrynie, więc po prostu siedzą bezczynnie i nie otrzymują żadnego linku. Google nie widzi ich i nie wie, że rzeczywiście istnieją.

-

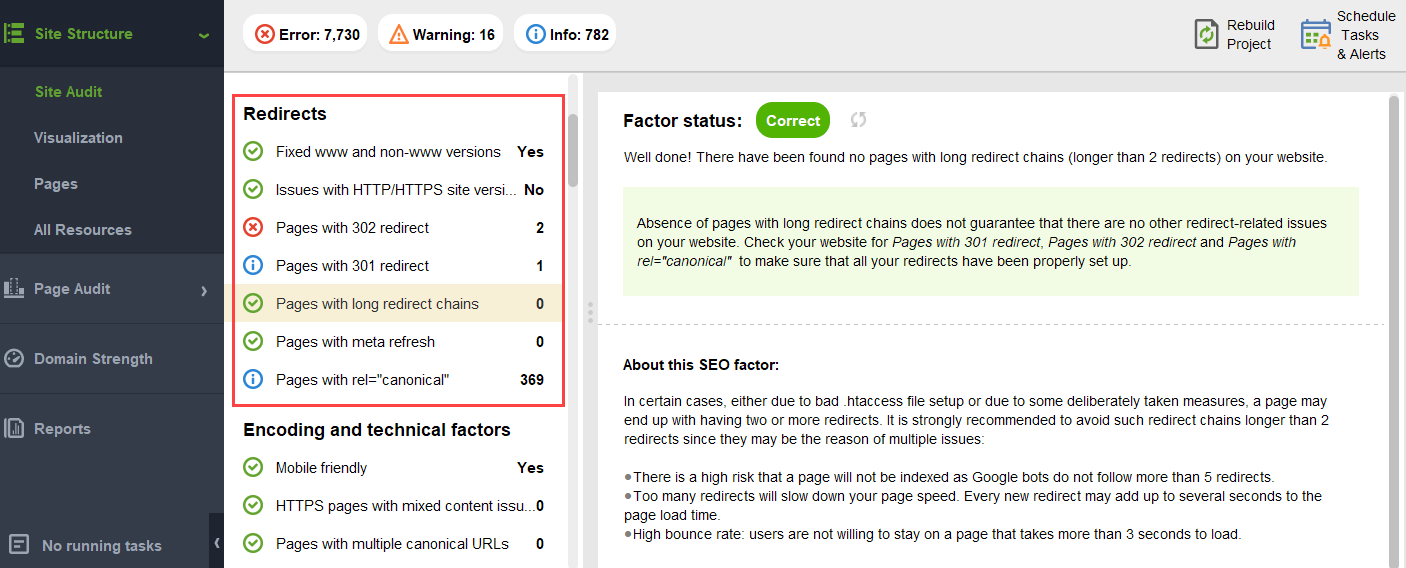

przekierować łańcuchy. Chociaż Google mówi, że przekierowania przechodzą teraz 100% PR, nadal zaleca się unikanie długich łańcuchów przekierowań. Po pierwsze, i tak zjadają Twój budżet. Po drugie, wiemy, że nie możemy ślepo wierzyć we wszystko, co mówi Google.

-

linki w niezrównanym JavaScript. Ponieważ Google nie może ich odczytać, nie przejdzie PageRank.

-

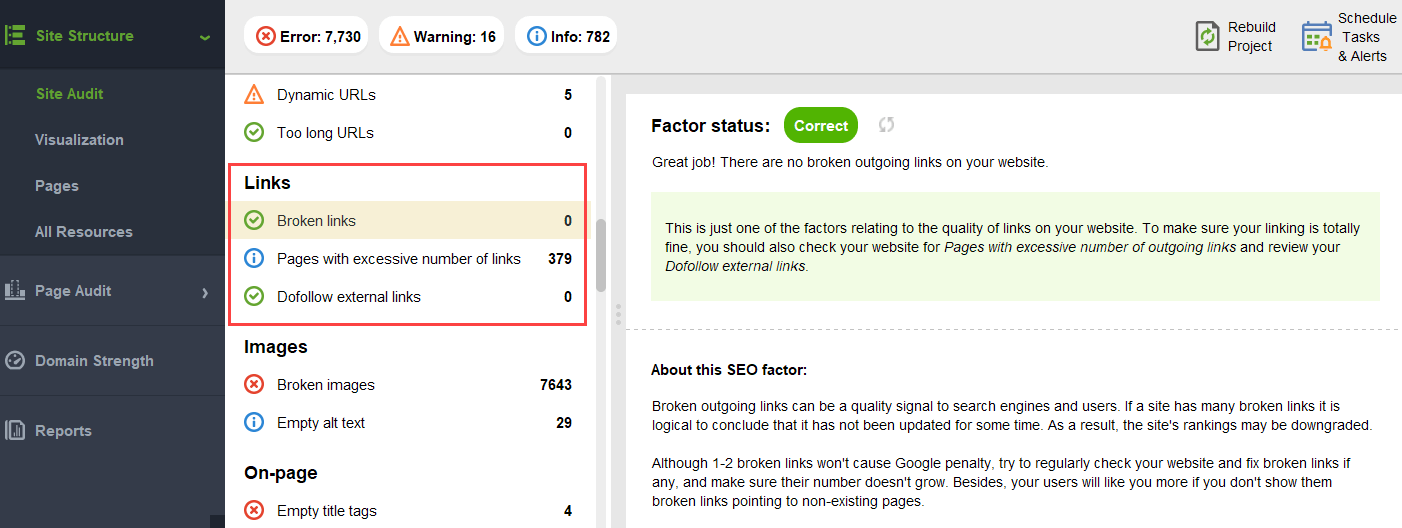

404 linki. 404 linki prowadzą donikąd, więc PageRank też nigdzie nie idzie.

-

linki do nieistotnych stron. Oczywiście nie możesz zostawić żadnej ze swoich stron bez linków, ale strony nie są sobie równe. Jeśli jakaś strona jest mniej ważna, nie jest racjonalne Wkładanie zbytniego wysiłku w optymalizację profilu linków na tej stronie.

-

zbyt odległe strony. Jeśli strona znajduje się zbyt głęboko w Twojej witrynie, prawdopodobnie otrzyma niewiele PR lub w ogóle nie będzie PR. Ponieważ Google może nie uda się go znaleźć i zindeksować.

aby upewnić się, że Twoja strona jest wolna od tych zagrożeń PageRank, możesz ją skontrolować za pomocą WebSite Auditor. To narzędzie ma kompleksowy zestaw modułów w strukturze witryny > sekcja audytu witryny, która pozwala sprawdzić ogólną optymalizację witryny i oczywiście znaleźć i naprawić wszystkie problemy związane z linkami, takie jak długie przekierowania:

i niedziałające linki:

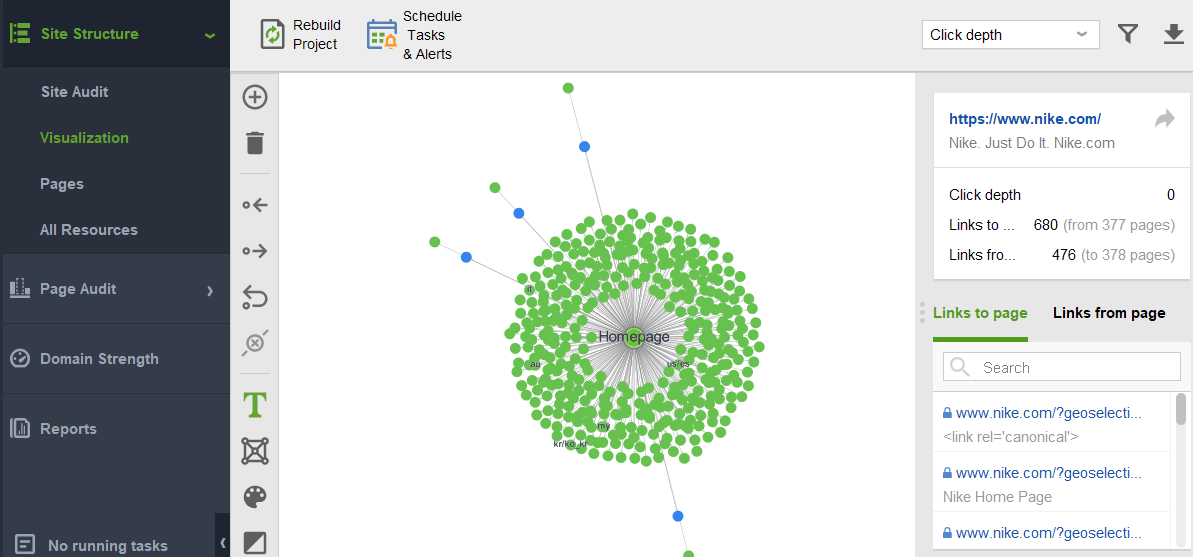

aby sprawdzić swoją witrynę pod kątem stron osieroconych lub stron, które są zbyt odległe, przejdź do struktury witryny > Wizualizacja:

przyszłość PageRank

w tym roku PageRank skończył 23. I chyba jest starszy niż niektórzy z naszych czytelników dzisiaj:) ale co będzie z PageRank w przyszłości? Czy kiedyś całkowicie zniknie?

wyszukiwarki bez linków zwrotnych

próbując wymyślić popularną wyszukiwarkę, która nie używa linków zwrotnych w swoim algorytmie, jedynym pomysłem, który mogę wymyślić, jest eksperyment Yandex w 2014 roku. Wyszukiwarka ogłosiła, że zrzucenie linków zwrotnych z ich algorytmu może w końcu powstrzymać spamerów linków od manipulacji i pomóc w skierowaniu ich wysiłków na tworzenie wysokiej jakości stron internetowych.

to mógł być prawdziwy wysiłek, aby przejść w kierunku alternatywnych czynników rankingu, lub po prostu próba przekonania mas do porzucenia spamu link. Ale w każdym razie, w ciągu zaledwie roku od ogłoszenia, Yandex potwierdził, że czynniki linków zwrotnych wróciły do swojego systemu.

ale dlaczego linki zwrotne są tak niezbędne dla wyszukiwarek?

mając niezliczone inne dane wskazujące na zmianę kolejności wyników wyszukiwania po rozpoczęciu ich wyświetlania (takie jak zachowanie użytkownika i korekty BERT), linki zwrotne pozostają jednym z najbardziej wiarygodnych kryteriów autorytetu potrzebnych do utworzenia początkowego SERP. Ich jedynym konkurentem są prawdopodobnie byty.

Jak to ujął Bill Slawski pytany o przyszłość PageRank:

Google bada uczenie maszynowe i ekstrakcję faktów oraz zrozumienie kluczowych par wartości dla podmiotów gospodarczych, co oznacza ruch w kierunku wyszukiwania semantycznego i lepszego wykorzystania ustrukturyzowanych danych i jakości danych.

Bill Slawski, SEO nad Morzem

mimo to Google jest zupełnie niepodobne do odrzucenia czegoś, w co zainwestowali dziesiątki lat rozwoju.

Google jest bardzo dobry w analizie linków, która jest teraz bardzo dojrzałą technologią internetową. Z tego powodu jest całkiem możliwe, że PageRank będzie nadal używany do rangi organicznych Serpów.

Bill Slawski, SEO nad Morzem

wiadomości i inne czasochłonne wyniki

kolejnym trendem, na który zwrócił uwagę Bill Slawski, były wiadomości i inne krótkotrwałe typy wyników wyszukiwania:

Google powiedział nam, że w mniejszym stopniu opiera się na PageRank dla stron, w których aktualność jest ważniejsza, takich jak wyniki w czasie rzeczywistym (np. z Twittera) lub Wyniki wiadomości, w których aktualność jest bardzo ważna.

Bill Slawski, SEO nad Morzem

rzeczywiście, kawałek wiadomości żyje w wynikach wyszukiwania o wiele za mało, aby zgromadzić wystarczająco dużo linków zwrotnych. Tak więc Google było i może nadal pracować nad zastępowaniem linków zwrotnych innymi czynnikami rankingu podczas radzenia sobie z wiadomościami.

jednak, jak na razie, rankingi wiadomości są wysoko zdeterminowane przez niszową autorytatywność wydawcy, a nadal czytamy autorytatywność jako linki zwrotne:

„sygnały autorytatywności pomagają nadać priorytet wysokiej jakości informacjom pochodzącym z najbardziej wiarygodnych dostępnych źródeł. Aby to zrobić, nasze systemy są zaprojektowane w celu identyfikacji sygnałów, które mogą pomóc określić, które strony wykazują wiedzę, autorytet i wiarygodność w danym temacie, na podstawie informacji zwrotnych od wyszukiwarek. Sygnały te mogą obejmować to, czy inne osoby cenią źródło podobnych zapytań, lub czy inne znane strony internetowe na ten temat łączą się z historią.”

New rel=” sponsorowane”i rel =” UGC ” atrybuty

Last but not least, byłem bardzo zaskoczony wysiłkiem Google, aby móc zidentyfikować sponsorowane i generowane przez użytkowników linki zwrotne i odróżnić je od innych linków nofollowed.

jeśli te wszystkie linki zwrotne mają być ignorowane, po co odróżniać je od siebie? Zwłaszcza z Johnem Mullerem sugerującym, że później Google może próbować traktować te rodzaje linków inaczej.

moim najśmielszym przypuszczeniem było to, że może Google sprawdza, czy Reklama i linki generowane przez użytkowników mogą stać się pozytywnym sygnałem rankingowym.

w końcu reklama na popularnych platformach wymaga ogromnych budżetów, a ogromne budżety są atrybutem dużej i popularnej marki.

treści generowane przez użytkowników, gdy są rozpatrywane poza paradygmatem spamu komentarzy, polegają na tym, że prawdziwi klienci udzielają swoich rzeczywistych rekomendacji.

jednak eksperci, z którymi się skontaktowałem, nie wierzyli, że jest to możliwe:

wątpię, żeby Google uznało linki sponsorowane za pozytywny sygnał.

wydaje się, że pomysł polega na tym, że poprzez rozróżnienie różnych rodzajów linków Google spróbuje dowiedzieć się, które z linków nofollow mają być śledzone w celach budowania podmiotów:

Google nie ma problemu z treściami generowanymi przez użytkowników lub sponsorowanymi treściami na stronie internetowej, jednak oba były historycznie używane jako metody manipulowania pagerank. Jako takie, webmasterzy są zachęcani do umieszczania atrybutu nofollow na tych linkach (między innymi z powodów korzystania z nofollow).Jednak linki nofollowed nadal mogą być pomocne dla Google w sprawach (takich jak na przykład rozpoznawanie podmiotów), więc zauważyli wcześniej, że mogą traktować to jako bardziej sugestię, a nie dyrektywę jak roboty.txt Disallow rule będzie na własnej stronie.Oświadczenie Johna Muellera brzmiało: „mogłem sobie wyobrazić w naszych systemach, że z czasem nauczymy się traktować je nieco inaczej.”Może to odnosić się do przypadków, w których Google traktuje nofollow jako sugestię. Hipotetycznie, jest możliwe, że systemy Google może dowiedzieć się, które nofollowed linki do naśladowania w oparciu o spostrzeżenia zebrane z rodzajów linków oznaczonych jako ugc i sponsorowane. Ponownie, nie powinno to mieć dużego wpływu na rankingi witryny – ale teoretycznie może mieć wpływ na witrynę, która jest połączona.

Callum Scott, Marie Haynes Consulting

.png)