The Past, Present & Future of Google PageRank

pagerank algorithm (of kortweg PR) is een systeem voor het rangschikken van webpagina ’s ontwikkeld door Larry Page en Sergey Brin aan de Stanford University in de late jaren’ 90. PageRank was eigenlijk de basis pagina en Brin creëerde de Google zoekmachine op.

sindsdien zijn vele jaren verstreken, en natuurlijk zijn de ranking-algoritmen van Google veel ingewikkelder geworden. Zijn ze nog steeds gebaseerd op PageRank? Hoe precies heeft PageRank invloed ranking, en wat moet SEOs klaar voor in de toekomst? Nu gaan we alle feiten en mysteries rond PageRank vinden en samenvatten om het plaatje duidelijk te maken. Nou, zoveel als we kunnen.

het verleden van PageRank

zoals hierboven vermeld, probeerden Brin en Page in hun universitaire onderzoeksproject een systeem uit te vinden om de autoriteit van webpagina ‘ s te schatten. Ze besloten om dat systeem te bouwen op links, die dienden als stemmen van vertrouwen gegeven aan een pagina. Volgens de logica van dat mechanisme, hoe meer externe bronnen link naar een pagina, hoe meer waardevolle informatie het heeft voor gebruikers. En PageRank (een score van 0 tot 10 berekend op basis van kwantiteit en kwaliteit van inkomende links) toonde relatieve autoriteit van een pagina op het Internet.

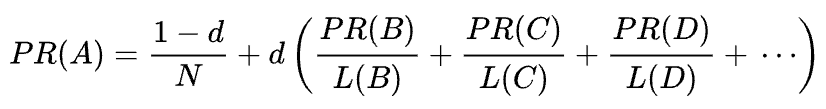

originele pagerank formule

laten we eens kijken hoe PageRank werkt. Elke link van de ene pagina (a) naar de andere (B) werpt een zogenaamde stem, waarvan het gewicht afhankelijk is van het collectieve gewicht van alle pagina ‘ s die verwijzen naar pagina A. En we kunnen hun gewicht niet weten tot we het berekenen, dus het proces gaat in cycli.

de wiskundige formule van de oorspronkelijke PageRank is de volgende:

waarbij A, B, C en D enkele pagina ’s zijn, L het aantal links dat van elk van deze pagina’ s uitgaat, en N het totale aantal pagina ‘ s in de verzameling (d.w.z. op Internet).

zoals voor d is d de zogenaamde dempingsfactor. Gezien het feit dat PageRank wordt berekend simuleren het gedrag van een gebruiker die willekeurig krijgt om een pagina en klikt op links, passen we deze demping d factor als de kans dat de gebruiker verveeld en het verlaten van een pagina.

zoals u kunt zien aan de formule, als er geen pagina ’s naar de pagina wijzen, zal het PR niet nul zijn, maar

omdat er een kans is dat de gebruiker deze pagina niet vanaf andere pagina’ s maar bijvoorbeeld vanaf bladwijzers kan bereiken.

pagerank manipulation vulnerability and Google ‘ s war against link spam

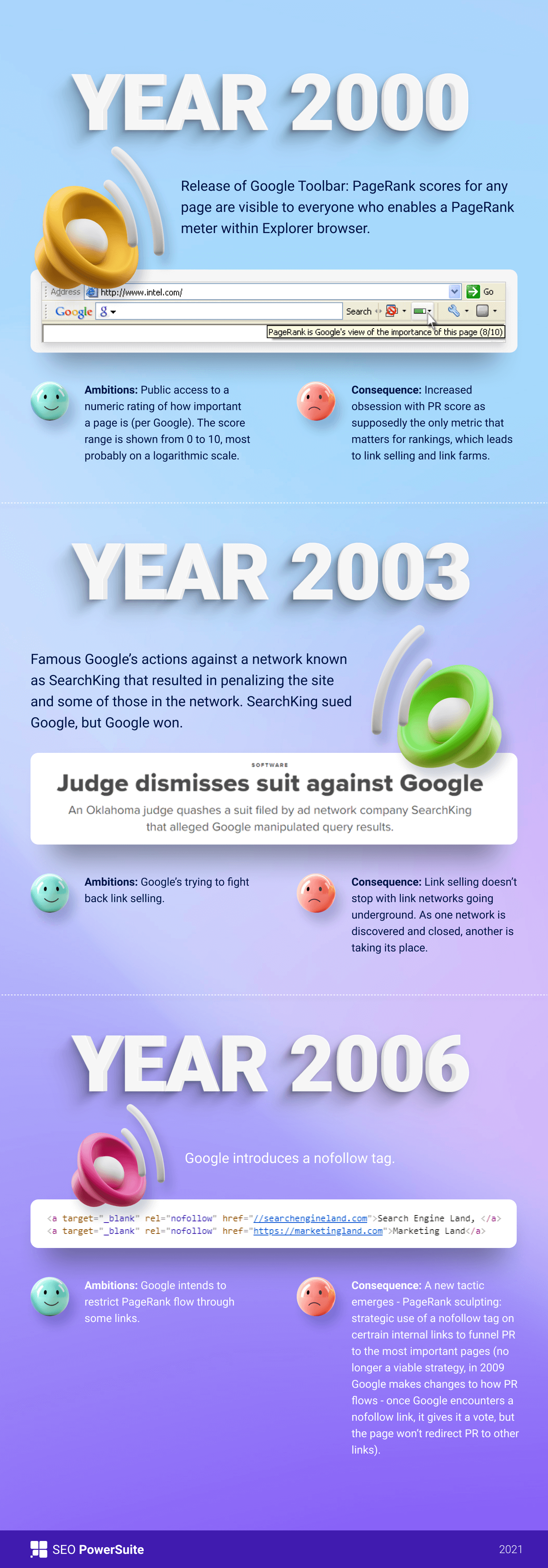

aanvankelijk was de pagerank score publiekelijk zichtbaar in de Google Toolbar, en elke pagina had zijn score van 0 tot 10, hoogstwaarschijnlijk op een logaritmische schaal.

Google ‘ s ranking algoritmen van die tijd waren echt eenvoudig-hoge PR en keyword density waren de enige twee dingen die een pagina nodig had om hoog te scoren op een SERP. Als gevolg daarvan werden webpagina ‘ s gevuld met zoekwoorden en website-eigenaren begonnen pagerank te manipuleren door kunstmatig spammy backlinks te kweken. Dat was gemakkelijk te doen — link boerderijen en link verkopen waren er om website-eigenaren een “helpende hand te geven.”

Google besloot om link spam terug te vechten. In 2003 strafte Google de website van het advertentienetwerk SearchKing voor linkmanipulaties. SearchKing klaagde Google aan, maar Google won. Het was een manier Google geprobeerd om iedereen te beperken van link manipulaties, maar het leidde tot niets. Link farms gingen net ondergronds, en hun hoeveelheid vermenigvuldigde zich enorm.

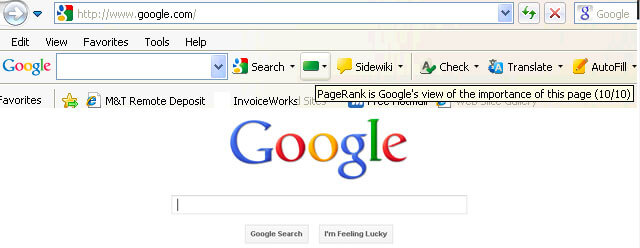

bovendien vermenigvuldigden spammy-reacties op blogs zich ook. Bots aangevallen de reacties van een, Zeg, WordPress blog en liet enorme aantallen” click-here-to-buy-magic-pills ” reacties. Om spam en PR manipulatie in reacties te voorkomen, introduceerde Google de nofollow tag in 2005. En nogmaals, wat Google bedoelde om een succesvolle stap te worden in de link manipulatie oorlog werd uitgevoerd in een verdraaide manier. Mensen begonnen nofollow-tags te gebruiken om pagerank kunstmatig te funnellen naar de pagina ‘ s die ze nodig hadden. Deze tactiek werd bekend als pagerank beeldhouwen.

om PR-sculpting te voorkomen, veranderde Google de manier waarop PageRank stroomt. Als een pagina voorheen zowel nofollow-als dofollow-links had, werd het gehele PR-volume van de pagina doorgegeven aan andere pagina ‘ s waarnaar de doFollow-links verwijzen. In 2009, Google begonnen met het verdelen van een pagina PR gelijkelijk over alle links die de pagina had, maar het doorgeven van alleen die aandelen die werden gegeven aan de doFollow-links.

gedaan met pagerank beeldhouwen, Google niet stoppen met de link spam oorlog en begon bijgevolg het nemen van PageRank score uit de ogen van het publiek. Eerste, Google lanceerde de nieuwe Chrome-browser zonder Google Toolbar waar de PR-score werd getoond. Toen stopten ze met het melden van de PR-score in Google Search Console. Vervolgens Firefox browser gestopt met het ondersteunen van Google Toolbar. In 2013, PageRank werd bijgewerkt voor Internet Explorer voor de laatste keer, en in 2016 Google officieel stilgelegd de werkbalk voor het publiek.

een andere manier die Google gebruikte om linkprogramma ‘ s te bestrijden was Penguin update, die websites met fishy backlink-profielen van de ranglijst haalde. Uitgerold in 2012, Penguin niet een deel van Google ’s real-time algoritme geworden, maar was eerder een “filter” bijgewerkt en opnieuw toegepast op de zoekresultaten zo nu en dan. Als een website werd gestraft door Penguin, SEOs moest zorgvuldig herzien hun link profielen en verwijderen giftige links, of voeg ze toe aan een disavow lijst (een functie geïntroduceerd die dagen om Google te vertellen welke inkomende links te negeren bij het berekenen van PageRank). Na auditing link profielen op die manier, SEOs moest wachten voor een half jaar of zo totdat de Penguin algoritme herberekent de gegevens.

in 2016 maakte Google Penguin een deel van zijn core ranking algoritme. Sindsdien, het heeft gewerkt in real-time, algoritmisch omgaan met spam veel succes.

tegelijkertijd werkte Google aan het vergemakkelijken van de kwaliteit in plaats van kwantiteit van links, door deze in zijn kwaliteitsrichtlijnen af te stemmen op link-schema ‘ s.

het heden van PageRank

wel, we zijn klaar met het verleden van PageRank. Wat gebeurt er nu?

in 2019 zei een voormalige Google-medewerker dat het originele PageRank-algoritme sinds 2006 niet meer in gebruik was en werd vervangen door een ander minder resource-intensief algoritme naarmate het Internet groter werd. Wat misschien wel waar is, zoals in 2006 Google ingediend de nieuwe produceren van een ranking voor pagina ‘ s met behulp van afstanden in een web-link grafiek patent.

wordt het PageRank-algoritme vandaag toegepast?

ja, dat is het. Het is niet dezelfde PageRank als het was in de vroege jaren 2000, maar Google blijft vertrouwen op link authority zwaar. Bijvoorbeeld, een voormalige Google-werknemer Andrey Lipattsev vermeld dit in 2016. In een Google Q&een hangout, een gebruiker vroeg hem wat waren de belangrijkste ranking signalen die Google gebruikt. Andrey ‘ s antwoord was vrij eenvoudig.

ik kan je vertellen wat ze zijn. Het is inhoud en links die verwijzen naar uw site.

Andrey Lipattsev

in 2020 bevestigde John Mueller dat:

Ja, we gebruiken pagerank intern, onder vele, vele andere signalen. Het is niet helemaal hetzelfde als het originele papier, er zijn veel eigenaardigheden (bijvoorbeeld verstoten links, genegeerd links, enz.), en, nogmaals, we gebruiken veel andere signalen die veel sterker kunnen zijn.

John Mueller

zoals u kunt zien, PageRank is nog steeds in leven en actief gebruikt door Google bij het rangschikken van pagina ‘ s op het web.

wat interessant is, is dat Google-medewerkers ons er steeds aan blijven herinneren dat er vele, vele, vele andere rangschikkingssignalen zijn. Maar we bekijken dit met een korreltje zout. Gezien hoeveel moeite Google gewijd aan het bestrijden van link spam, het zou van belang van Google om SEOs’ aandacht uit de manipulatie-kwetsbare factoren schakelen (zoals backlinks zijn) en rijden deze aandacht naar iets onschuldigs en leuk. Maar als SEO ‘ s zijn goed in het lezen tussen de regels, ze blijven overwegen PageRank een sterke ranking signaal en groeien backlinks alle manieren waarop ze kunnen. Ze gebruiken nog steeds PBN ‘ s, oefenen wat grijze-hoed tiered link building, kopen links, en ga zo maar door, net zoals het was een lange tijd geleden. Zoals PageRank leeft, link spam zal leven, ook. We raden niets van dat, maar dat is wat de SEO realiteit is, en we moeten begrijpen dat.

willekeurige Surfer vs. redelijke Surfermodellen van PageRank

Nou, je hebt het idee dat PageRank nu niet de PageRank is die het 20 jaar geleden was.Een van de belangrijkste moderniseringen van PR was de overgang van het kort genoemde Random Surfer model naar het redelijke Surfer model in 2012. Redelijke Surfer gaat ervan uit dat gebruikers zich niet chaotisch gedragen op een pagina en klikt alleen op die links waarin ze op dit moment geïnteresseerd zijn. Zeggen, het lezen van een blog artikel, bent u meer kans om te klikken op een link in de inhoud van het artikel in plaats van een Gebruiksvoorwaarden link in de voettekst.

bovendien kan een redelijke Surfer een groot aantal andere factoren gebruiken om de aantrekkelijkheid van een link te beoordelen. Al deze factoren werden zorgvuldig beoordeeld door Bill Slawski in zijn artikel, maar Ik wil me richten op de twee factoren, die SEOs vaker bespreken. Dit zijn linkpositie en paginaverkeer. Wat kunnen we over deze factoren zeggen?

correlatie tussen linkpositie en linkautoriteit

een link kan zich overal op de pagina bevinden — in de inhoud, het navigatiemenu, de bio van de auteur, de voettekst en eigenlijk elk structureel element dat de pagina bevat. En verschillende link locaties beïnvloeden link waarde. John Mueller bevestigde dat, te zeggen dat links geplaatst in de belangrijkste inhoud meer wegen dan alle andere:

Dit is het gebied van de pagina waar je je primaire inhoud hebt, de inhoud waar deze pagina eigenlijk over gaat, niet het menu, de zijbalk, de voettekst, de koptekst… dan is dat iets waar we rekening mee houden en we proberen die links te gebruiken.

John Mueller

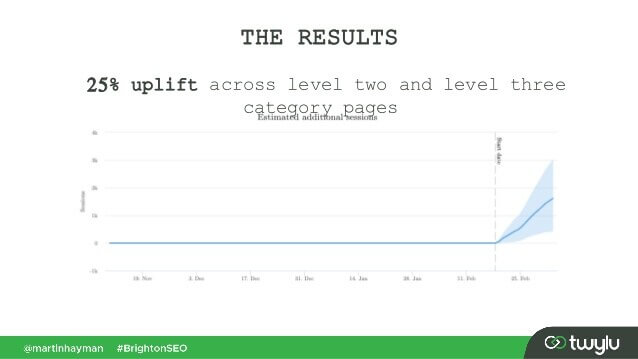

dus, voettekst links en navigatie links worden gezegd dat minder gewicht passeren. En dit feit van tijd tot tijd wordt bevestigd niet alleen door Google woordvoerders, maar door real-life gevallen.

in een recent geval dat werd gepresenteerd door Martin Hayman bij BrightonSEO, voegde Martin de link die hij al had in zijn navigatiemenu toe aan de hoofdinhoud van de pagina ‘ s. Als gevolg daarvan, die categorie pagina ’s en de pagina’ s die ze gekoppeld aan ervaren een 25% verkeer stijging.

dit experiment bewijst dat de inhoud links doen passeren meer gewicht dan alle andere.

wat de links in de bio van de auteur betreft, gaan SEO ‘ s ervan uit dat bio links iets wegen, maar minder waardevol zijn dan bijvoorbeeld content links. Hoewel we niet veel bewijs hier, maar voor wat Matt Cutts zei toen Google was actief vechten overmatige gast bloggen voor backlinks.

correlatie tussen verkeer, gebruikersgedrag en link authority

John Mueller verduidelijkte de manier waarop Google verkeer en gebruikersgedrag behandelt in termen van passerende link juice in een van de centrale hangouts van de Zoekconsole. Een gebruiker vroeg Mueller of Google bij het evalueren van de kwaliteit van een link rekening houdt met klikkans en het aantal klikken op een link. De belangrijkste afhaalpunten van Mueller ‘ s antwoord waren:

-

Google houdt geen rekening met link klikken en klik waarschijnlijkheid bij het evalueren van de kwaliteit van de link.

-

Google begrijpt dat links vaak worden toegevoegd aan inhoud, zoals referenties, en gebruikers worden niet verwacht dat ze op elke link klikken die ze tegenkomen.

nog steeds, Zoals altijd, SEOs twijfelen of het de moeite waard blindelings geloven alles wat Google zegt, en blijven experimenteren. Dus, jongens van Ahrefs uitgevoerd een studie om te controleren of de positie van een pagina op een SERP is verbonden met het aantal backlinks het heeft van high-traffic pagina ‘ s. De studie toonde aan dat er nauwelijks een correlatie is. Bovendien, sommige top-ranked pagina ’s bleek geen backlinks van het verkeer-rijke pagina’ s op alle.

deze studie wijst ons in dezelfde richting als John Mueller ‘ s woorden – je hoeft geen verkeer genererende backlinks naar je pagina te bouwen om hoge posities op een SERP te krijgen. Aan de andere kant, extra verkeer heeft nooit kwaad gedaan aan een website. Het enige bericht hier is dat verkeer-rijke backlinks lijken niet te beïnvloeden Google rankings.

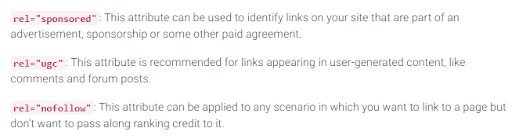

nofollow -, gesponsorde en UGC-tags

zoals u zich herinnert, introduceerde Google de nofollow-tag in 2005 als een manier om linkspam te bestrijden. Is er vandaag iets veranderd? Eigenlijk wel, ja.

Ten eerste heeft Google onlangs nog twee typen van het attribuut nofollow geïntroduceerd. Voordat dat, Google voorgesteld het markeren van alle backlinks die u niet wilt deelnemen aan pagerank berekening als nofollow, worden dat blog opmerkingen of betaalde advertenties. Vandaag raadt Google aan om rel=”gesponsord” te gebruiken voor betaalde en affiliate links en rel=”ugc” voor door gebruikers gegenereerde content.

het is interessant dat deze nieuwe tags niet verplicht zijn (tenminste nog niet), en Google wijst erop dat u niet handmatig alle rel=”nofollow” hoeft te wijzigen in rel=”gesponsord” en rel=”ugc”. Deze twee nieuwe attributen werken nu op dezelfde manier als een gewone nofollow-tag.

ten tweede zegt Google nu dat de nofollow-tags, evenals de nieuwe, gesponsorde en ugc, worden behandeld als hints, in plaats van een richtlijn bij het indexeren van pagina ‘ s.

uitgaande links en hun invloed op ranglijsten

naast inkomende links zijn er ook uitgaande links, dat wil zeggen links die naar andere pagina ‘ s van u verwijzen.

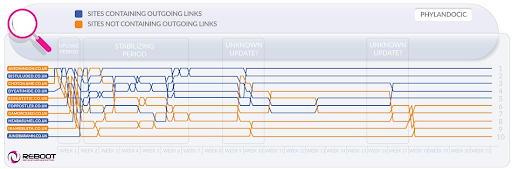

veel SEO ‘ s geloven dat uitgaande links van invloed kunnen zijn op rankings, maar deze veronderstelling is behandeld als een SEO mythe. Maar er is een interessante studie om naar te kijken in dit opzicht.

Reboot Online voerde een experiment uit in 2015 en voerde het opnieuw uit in 2020. Zij wilden weten of de aanwezigheid van uitgaande links naar pagina ‘ s van de hoge autoriteit de positie van de pagina op een SERP beïnvloedde. Ze creëerden 10 websites met artikelen van 300 woorden, allemaal geoptimaliseerd voor een niet – bestaand trefwoord-Flandocic. 5 websites hadden helemaal geen uitgaande links en 5 websites bevatten uitgaande links naar bronnen van de Hoge Autoriteit. Als gevolg daarvan, die websites met gezaghebbende uitgaande links begonnen rangschikking van de hoogste, en degenen die geen links helemaal nam de laagste posities.

aan de ene kant kunnen de resultaten van dit onderzoek ons vertellen dat uitgaande links de positie van pagina’ s beïnvloeden. Aan de andere kant, de zoekterm in het onderzoek is gloednieuw, en de inhoud van de websites is thema rond geneeskunde en drugs. Dus er zijn grote kansen dat de query werd geclassificeerd als YMYL. En Google heeft vele malen gewezen op het belang van E-A-T voor YMYL websites. Dus, de outlinks zou goed zijn behandeld als een E-a-T signaal, waaruit blijkt dat de pagina ‘ s hebben feitelijk accurate inhoud.

wat gewone zoekopdrachten betreft (niet YMYL), heeft John Mueller vele malen gezegd dat je niet bang hoeft te zijn om te linken naar externe bronnen vanuit je inhoud, omdat uitgaande links goed zijn voor je gebruikers.

bovendien kunnen uitgaande links ook gunstig zijn voor SEO, omdat hiermee rekening kan worden gehouden door Google AI bij het filteren van het web van spam. Omdat spammy pagina ‘ s hebben de neiging om weinig uitgaande links of helemaal niet. Ze verwijzen naar de pagina ‘ s Onder hetzelfde domein (als ze ooit denken over SEO) of bevatten alleen betaalde links. Dus, als u een link naar een aantal geloofwaardige middelen, je soort van tonen Google dat uw pagina is niet een spammy een.

er was eens een mening dat Google u een handmatige boete zou kunnen geven voor het hebben van te veel uitgaande links, maar John Mueller zei dat dit alleen mogelijk is als de uitgaande links duidelijk deel uitmaken van een link exchange scheme, plus de website is over het algemeen van slechte kwaliteit. Wat Google betekent onder voor de hand liggende is eigenlijk een mysterie, dus houd in gedachten gezond verstand, inhoud van hoge kwaliteit, en basic SEO.

Google battle against link spam

zolang PageRank bestaat, zullen SEOs zoeken naar nieuwe manieren om het te manipuleren.

in 2012 was de kans groter dat Google handmatige acties voor linkmanipulatie en spam vrijgaf. Maar nu, met zijn goed opgeleide anti-spam algoritmen, Google is in staat om gewoon negeren bepaalde spammy links bij het berekenen van PageRank in plaats van downranking de hele website in het algemeen. Zoals John Mueller zei,

willekeurige links verzameld door de jaren heen zijn niet per se schadelijk, we hebben ze gezien voor een lange tijd ook, en kunnen negeren al die vreemde stukken van web-graffiti van lang geleden.

John Mueller

dit geldt ook voor negatieve SEO wanneer uw backlink profiel wordt aangetast door uw concurrenten:

in het algemeen houden we hier automatisch rekening mee en proberen we… ze automatisch te negeren als we ze zien gebeuren. Voor het grootste deel, ik vermoed dat werkt vrij goed. Ik zie heel weinig mensen met echte problemen rond dat. Ik denk dat dat meestal goed werkt. Met betrekking tot het ontkennen van deze links, Ik vermoed dat als dit zijn gewoon normale spammy links die net opduiken voor uw website, dan zou ik me geen zorgen over hen te veel. Waarschijnlijk hebben we dat zelf bedacht.

John Mueller

maar dat betekent niet dat je je geen zorgen hoeft te maken. Als backlinks van uw website te veel en te vaak worden genegeerd, heb je nog steeds een grote kans op het krijgen van een handmatige actie. Zoals Marie Haynes zegt in haar advies over link management in 2021:

handmatige acties zijn voorbehouden voor gevallen waarin een anders fatsoenlijke site onnatuurlijke links heeft die ernaar wijzen op een schaal die zo groot is dat Google ‘ s algoritmen niet comfortabel zijn om ze te negeren.

Marie Haynes

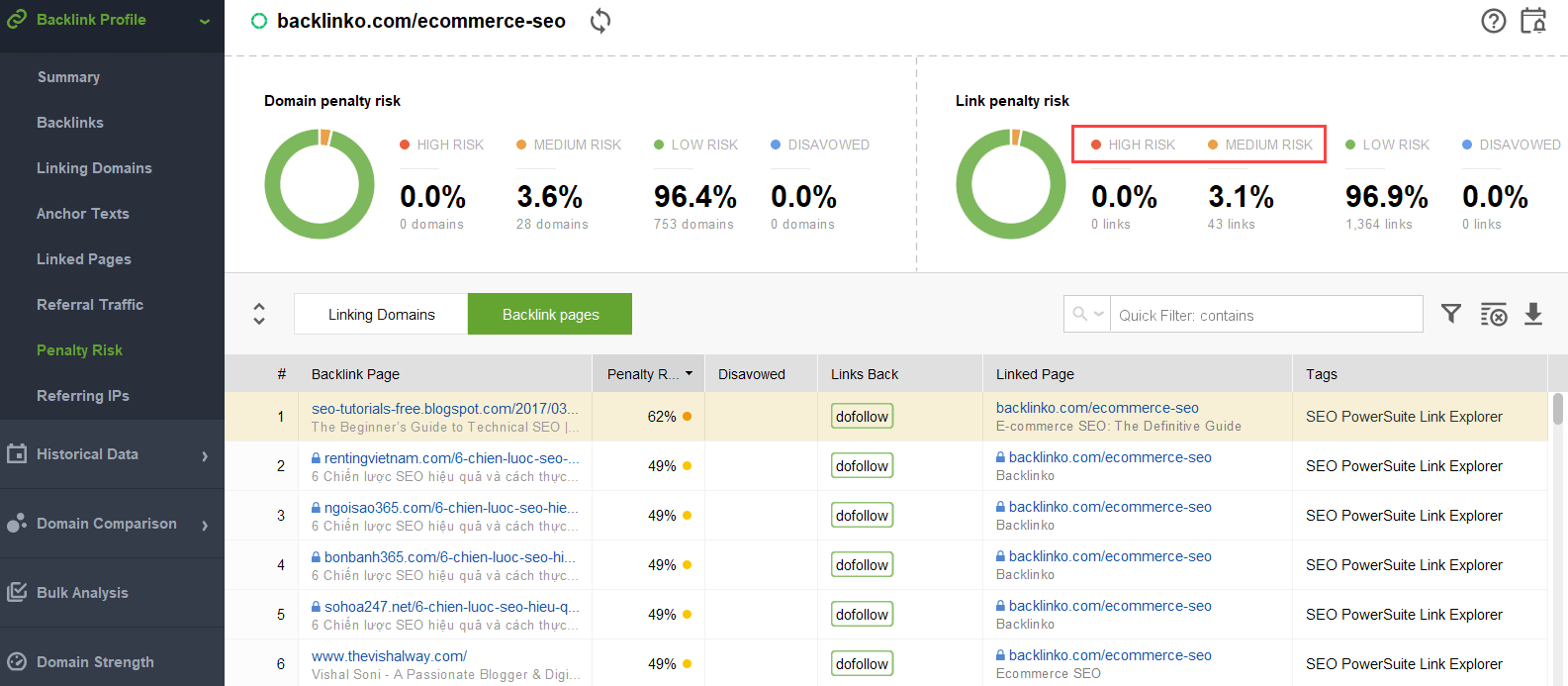

om te proberen om erachter te komen welke links zijn triggering het probleem, kunt u een backlink checker zoals SEO SpyGlass gebruiken. In de tool, ga naar Backlink profiel > Strafrisico sectie. Let op backlinks met een hoog en middelgroot risico.

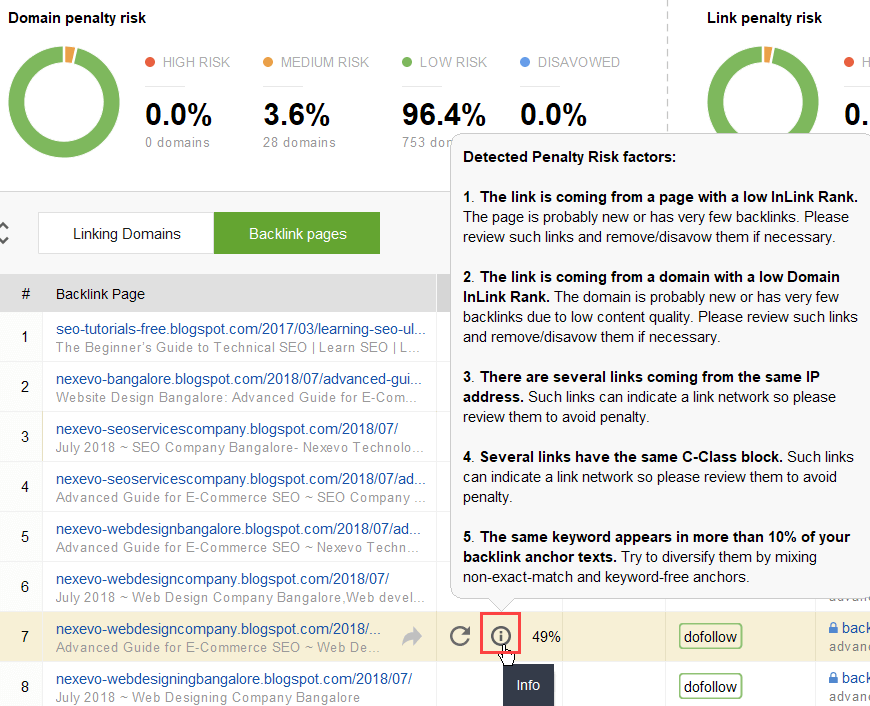

om verder te onderzoeken waarom deze of die link als schadelijk wordt gerapporteerd, klikt u op het i-teken in de kolom Penalty Risk. Hier zult u zien waarom de tool beschouwd als de link slecht en make-up je mening over de vraag of je zou ontkennen een link of niet.

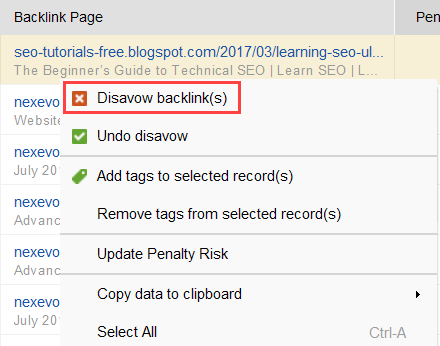

als u besluit een link van een groep links te Weigeren, klikt u er met de rechtermuisknop op en kiest u de optie backlink(s) weigeren:

zodra u een lijst met links hebt gevormd om uit te sluiten, kunt u het disavow bestand exporteren vanuit SEO SpyGlass en het verzenden naar Google via GSC.

Internal linking

als we het hebben over PageRank, kunnen we niet anders dan internal linking noemen. De inkomende PageRank is iets wat we niet kunnen controleren, maar we kunnen de manier waarop PR wordt verspreid over de pagina ‘ s van onze website volledig controleren.

Google heeft het belang van interne links ook vele malen aangegeven. John Mueller onderstreepte dit nogmaals in een van de nieuwste Zoekconsole centrale hangouts. Een gebruiker vroeg hoe sommige webpagina ‘ s krachtiger te maken. En John Mueller zei het volgende:

…U kunt helpen met interne koppeling. Dus, binnen uw website, kunt u echt markeren de pagina ‘ s die u wilt hebben gemarkeerd meer en zorg ervoor dat ze echt goed intern gekoppeld. En misschien dat de pagina ‘ s die je niet zo belangrijk vindt, zorg ervoor dat ze een beetje minder intern gekoppeld zijn.

John Mueller

interne koppeling betekent veel. Het helpt u inkomende PageRank tussen verschillende pagina ’s op uw website te delen, waardoor uw slecht presterende pagina’ s worden versterkt en uw website over het algemeen sterker wordt.

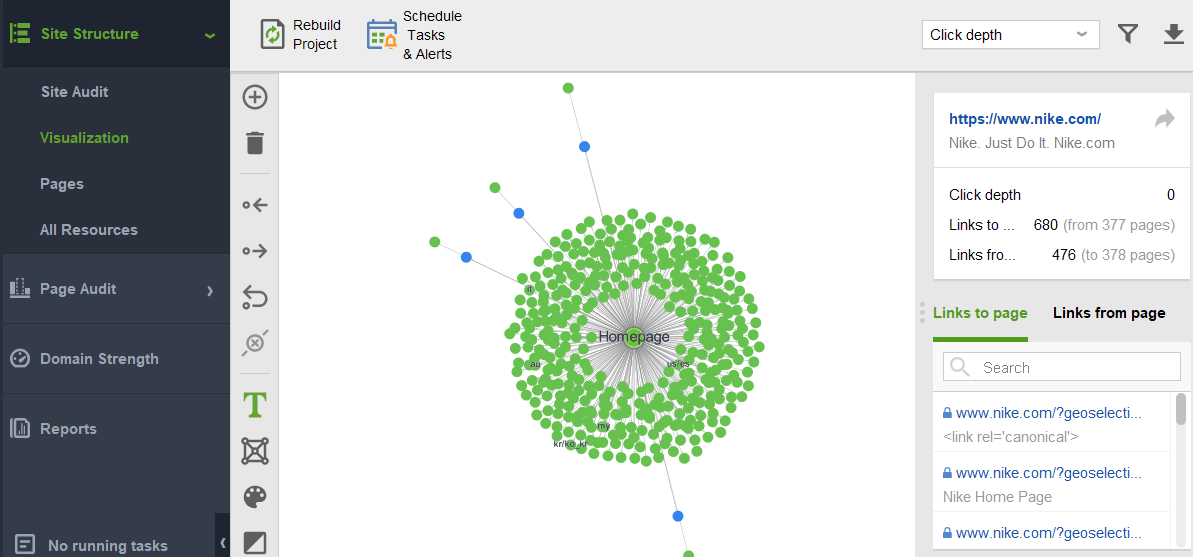

wat de benaderingen van interne koppeling betreft, hebben SEO ‘ s veel verschillende theorieën. Een populaire aanpak is gerelateerd aan website klikdiepte. Dit idee zegt dat alle pagina ‘ s op uw website moeten worden op een maximale 3-Klik afstand van de homepage. Hoewel Google het belang van oppervlakkige websitestructuur ook vele malen heeft onderstreept, lijkt dit in werkelijkheid onbereikbaar voor alle Grotere-dan-kleine websites.

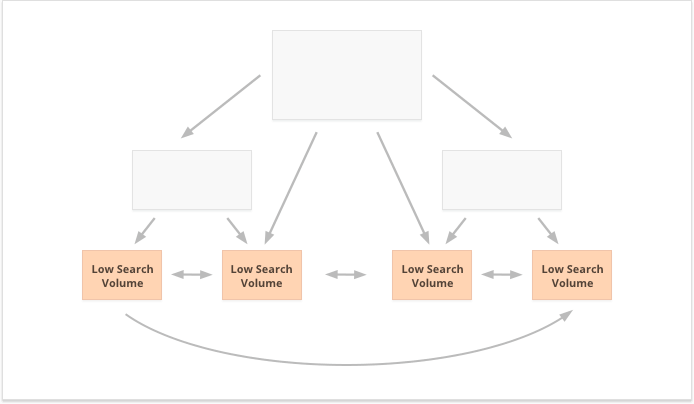

een andere benadering is gebaseerd op het concept van gecentraliseerde en gedecentraliseerde interne koppeling. Zoals Kevin Indig het beschrijft:

gecentraliseerde sites hebben een enkele gebruiker flow en trechter die wijst naar een belangrijke pagina. Sites met gedecentraliseerde interne koppeling hebben meerdere conversie touchpoints of verschillende formaten voor het aanmelden.

Kevin Indig

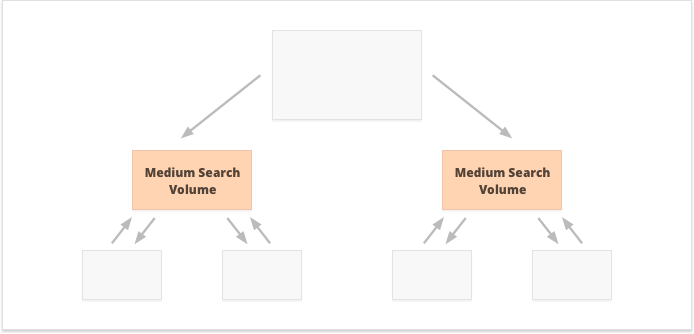

in het geval van gecentraliseerde interne koppeling, hebben we een kleine groep van conversie pagina ‘ s of een pagina, die we willen krachtig zijn. Als we decentrale interne links toepassen, willen we dat alle website-pagina ‘ s even krachtig zijn en gelijke PageRank hebben om ze allemaal te rangschikken voor uw vragen.

welke optie is beter? Het hangt allemaal af van uw website en zakelijke niche eigenaardigheden, en op de zoekwoorden die je gaat richten. Bijvoorbeeld, gecentraliseerde interne koppeling beter past bij zoekwoorden met hoge en middelgrote zoekvolumes, als het resulteert in een smalle set van super-krachtige pagina ‘ s.

lange-staart zoekwoorden met een laag zoekvolume zijn daarentegen beter voor gedecentraliseerde interne koppeling, aangezien PR gelijkelijk over talrijke website-pagina’ s wordt verspreid.

een ander aspect van succesvolle interne koppeling is het saldo van inkomende en uitgaande links op de pagina. In dit opzicht gebruiken veel SEO ‘ s CheiRank (CR), wat eigenlijk een inverse PageRank is. Maar terwijl PageRank de ontvangen macht is, is CheiRank de link macht weggegeven. Zodra u PR en CR voor uw pagina ’s berekent, kunt u zien welke pagina’ s linkafwijkingen hebben, dat wil zeggen de gevallen waarin een pagina veel PageRank ontvangt maar een beetje verder gaat, en vice versa.

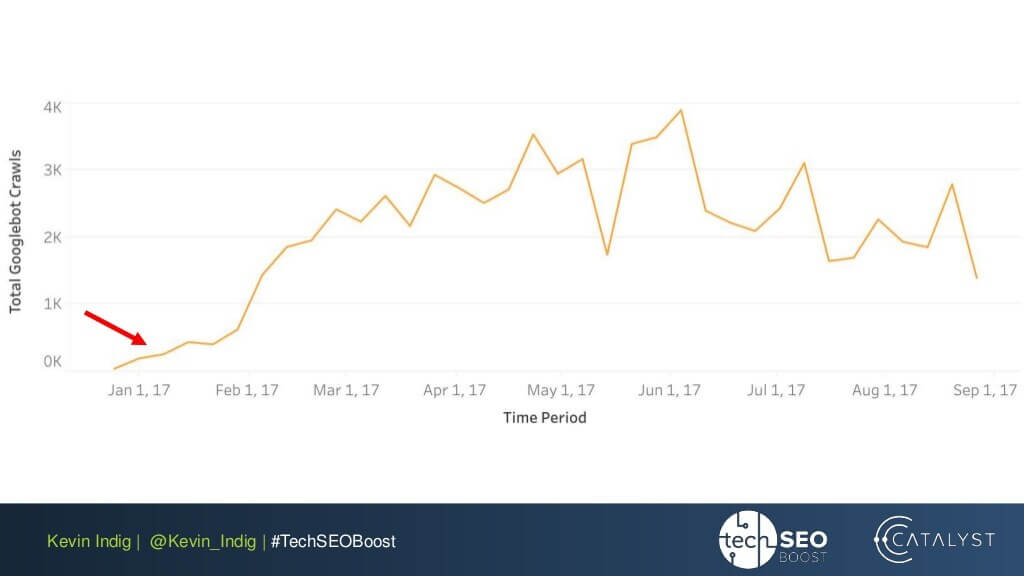

een interessant experiment hier is Kevin Indig ‘ s afvlakking van link anomalieën. Gewoon ervoor te zorgen dat de inkomende en uitgaande PageRank is uitgebalanceerd op elke pagina van de website bracht zeer indrukwekkende resultaten. De rode pijl hier wijst naar de tijd dat de anomalieën werden opgelost:

Verbindingsafwijkingen zijn niet het enige dat de pagerankstroom kan schaden. Zorg ervoor dat u niet vast komen te zitten met technische problemen, die uw zuurverdiende PR kan vernietigen:

-

Weespagina ‘ s. Weespagina ‘ s zijn niet gelinkt aan een andere pagina op uw website, dus ze zitten gewoon inactief en ontvangen geen link juice. Google kan ze niet zien en weet niet dat ze echt bestaan.

-

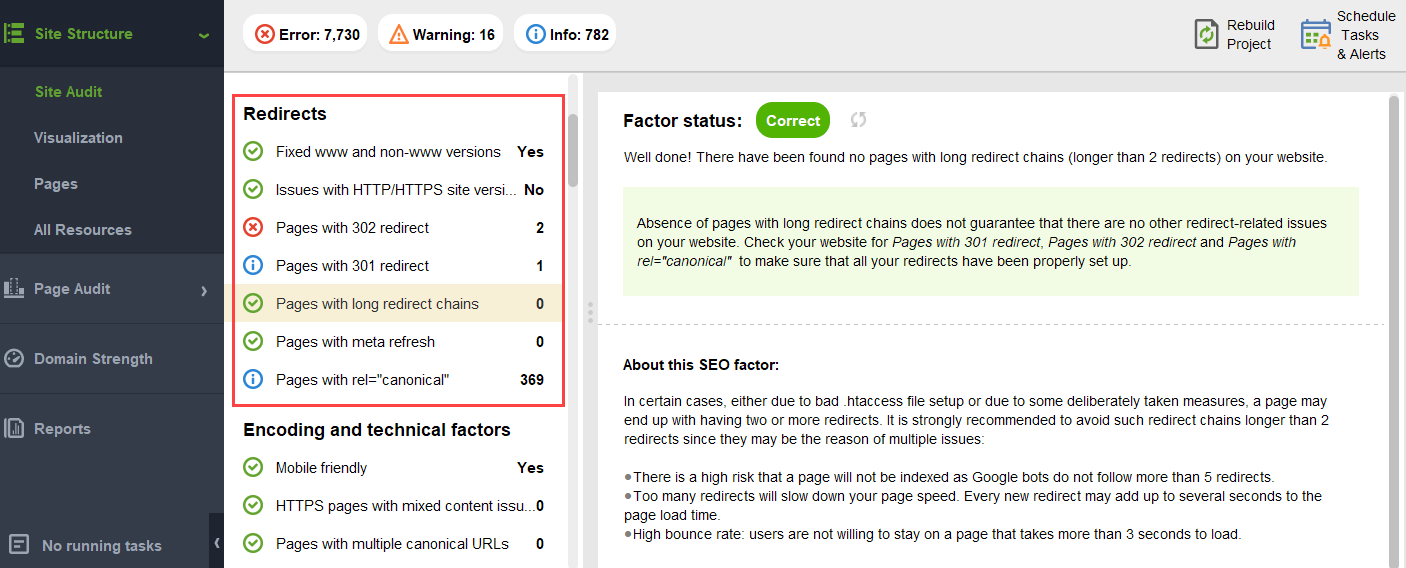

ketens omleiden. Hoewel Google zegt dat omleidingen nu passeren 100% van PR, is het nog steeds aan te raden om te voorkomen dat lange redirect ketens. Ten eerste, ze eten je kruipbudget toch op. Ten tweede weten we dat we niet blindelings alles kunnen geloven wat Google zegt.

-

Links in onparseable JavaScript. Aangezien Google ze niet kan lezen, zullen ze PageRank niet passeren.

-

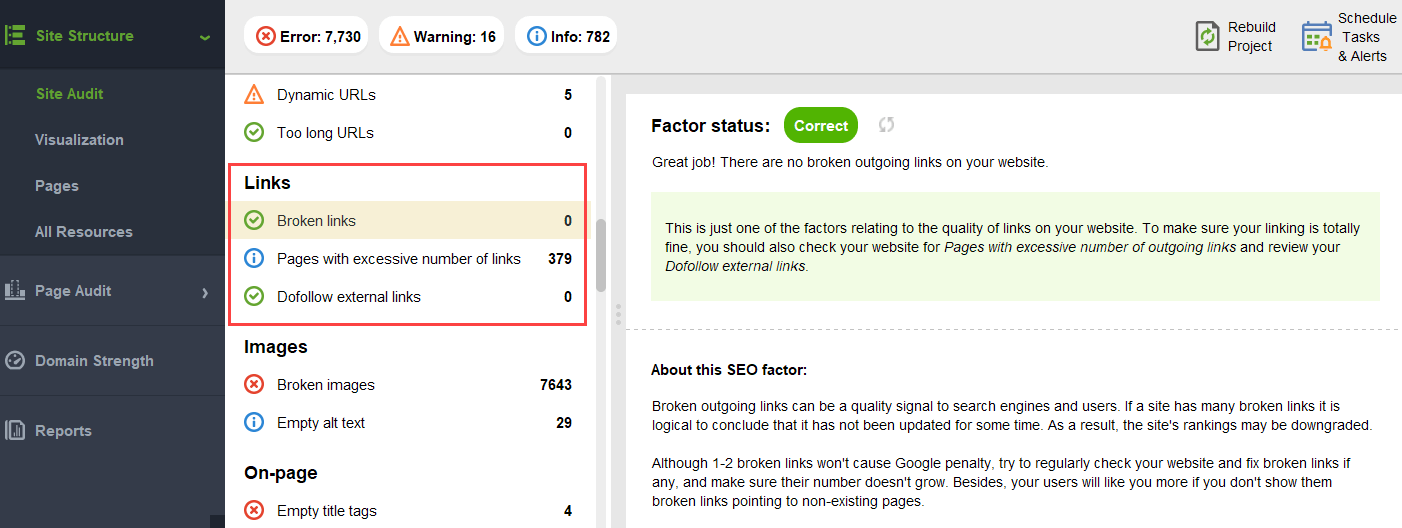

404 links. 404 links leiden naar nergens, dus PageRank gaat ook nergens heen.

-

Links naar onbelangrijke pagina ‘ s. Natuurlijk kunt u geen van uw pagina ’s zonder links achterlaten, maar pagina’ s worden niet gelijk gemaakt. Als sommige pagina is minder belangrijk, het is niet rationeel om te veel moeite te zetten in het optimaliseren van de link profiel van die pagina.

-

te verre pagina ‘ s. Als een pagina te diep op uw website staat, zal deze waarschijnlijk weinig of helemaal geen PR ontvangen. Als Google er niet in slagen om te vinden en indexeren.

om ervoor te zorgen dat uw website vrij is van deze pagerank gevaren, kunt u deze controleren met WebSite Auditor. Deze tool heeft een uitgebreide set modules binnen de Site structuur > Site Audit sectie, waarmee u de algehele optimalisatie van uw website kunt controleren, en, natuurlijk, alle link-gerelateerde problemen kunt vinden en oplossen, zoals lange omleidingen:

en verbroken links:

om uw site te controleren op weespagina ’s of pagina’ s die te ver weg zijn, schakelt u over naar sitestructuur > visualisatie:

de toekomst van PageRank

dit jaar is PageRank 23 geworden. En ik denk, het is ouder dan sommige van onze lezers Vandaag:) maar wat komt er voor PageRank In de toekomst? Gaat het op een dag helemaal verdwijnen?

zoekmachines zonder backlinks

wanneer ik probeer te denken aan een populaire zoekmachine zonder backlinks in hun algoritme, is het enige idee dat ik kan bedenken het Yandex-experiment in 2014. De zoekmachine kondigde aan dat het laten vallen van backlinks van hun algoritme eindelijk zou kunnen stoppen link spammers van manipulaties en helpen direct hun inspanningen om kwaliteit website Creatie.

het zou een echte poging zijn geweest om over te stappen op alternatieve ranking factoren, of gewoon een poging om de massa ‘ s te overtuigen om link spam te laten vallen. Maar in ieder geval, in slechts een jaar na de aankondiging, Yandex bevestigd backlink factoren waren terug in hun systeem.

maar waarom zijn backlinks zo onmisbaar voor zoekmachines?

hoewel er talloze andere gegevenspunten zijn om zoekresultaten te herschikken nadat ze zijn begonnen te tonen (zoals gebruikersgedrag en BERT aanpassingen), blijven backlinks een van de meest betrouwbare autoriteit criteria die nodig zijn om de initiële SERP te vormen. Hun enige concurrent hier zijn waarschijnlijk entiteiten.

zoals Bill Slawski het uitdrukt toen hem werd gevraagd over de toekomst van PageRank:

Google onderzoekt machine learning en fact extraction en het begrijpen van sleutelwaardeparen voor zakelijke entiteiten, wat een beweging betekent in de richting van semantisch zoeken en een beter gebruik van gestructureerde gegevens en gegevenskwaliteit.

Bill Slawski, seo door de zee

toch, Google is heel in tegenstelling tot iets dat ze hebben geïnvesteerd tientallen jaren van ontwikkeling in negeren.

Google is zeer goed in link analyse, dat is nu een zeer volwassen webtechnologie. Daarom is het heel goed mogelijk dat PageRank gebruikt blijft worden om organische SERPs te rangschikken.

Bill Slawski, SEO by the Sea

Nieuws en andere tijdgevoelige resultaten

een Andere trend Bill Slawski wees om nieuws en andere kortlevende soorten zoekresultaten:

Google heeft ons verteld dat het gebruikt minder op PageRank voor pagina ‘ s waar de actualiteit is belangrijker, zoals realtime resultaten (bijvoorbeeld van Twitter), of nieuws uit de resultaten, waar actualiteit is erg belangrijk.

Bill Slawski, seo door de zee

inderdaad, een stukje nieuws leeft in de zoekresultaten veel te weinig om te accumuleren genoeg backlinks. Dus Google is geweest en zou kunnen blijven werken aan backlinks vervangen door andere ranking factoren bij het omgaan met nieuws.

echter, zoals nu, nieuws rankings worden in hoge mate bepaald door de niche authoritativiteit van de uitgever, en we lezen authoritativiteit nog steeds als backlinks:

“Autoritativeness signals helpen bij het prioriteren van hoogwaardige informatie uit de meest betrouwbare bronnen die beschikbaar zijn. Om dit te doen, zijn onze systemen ontworpen om signalen te identificeren die kunnen helpen bepalen welke pagina ‘ s expertise, autoritativiteit en betrouwbaarheid tonen over een bepaald onderwerp, op basis van feedback van zoekresultaten. Die signalen kunnen onder meer of andere mensen de waarde van de bron voor soortgelijke vragen of dat andere prominente websites over het onderwerp link naar het verhaal.”

nieuwe rel=” gesponsord”en rel =” UGC ” attributen

Last but not least, was ik behoorlijk verrast door de inspanning die Google heeft gedaan om gesponsorde en door gebruikers gegenereerde backlinks te kunnen identificeren en ze te onderscheiden van andere nofollowed links.

als al die backlinks genegeerd moeten worden, waarom zou je dan de een van de ander willen onderscheiden? Vooral met John Muller suggereert dat later, Google zou kunnen proberen om deze soorten links anders te behandelen.

mijn wildste gok hier was dat Google misschien valideert of reclame en door gebruikers gegenereerde links een positief ranking signaal kunnen worden.

reclame op populaire platforms vereist immers enorme budgetten, en enorme budgetten zijn een kenmerk van een groot en populair merk.

door gebruikers gegenereerde inhoud, wanneer deze buiten het commentaar spam paradigma wordt beschouwd, gaat het over echte klanten die hun real-life goedkeuringen geven.

de deskundigen die ik benaderde, geloofden echter niet dat het mogelijk was:

ik betwijfel of Google ooit gesponsorde links als een positief signaal zou beschouwen.

Barry Schwartz, Search Engine Roundtable

Het idee is hier, lijkt het, is dat door het onderscheiden van verschillende soorten koppelingen van Google zou proberen om erachter te komen welke van de nofollow links zijn gevolgd voor entiteit-gebouw doeleinden:

Google heeft geen probleem met user generated content of gesponsorde inhoud op een website maar beide zijn van oudsher gebruikt als methoden van het manipuleren van de pagerank. Als zodanig worden webmasters aangemoedigd om een Nofollow-attribuut op deze links te plaatsen (onder andere redenen om nofollow te gebruiken).Echter, nofollowed links kunnen nog steeds nuttig zijn voor Google voor dingen (zoals entity recognition bijvoorbeeld), dus ze hebben eerder opgemerkt dat ze dit kunnen behandelen als een meer van een suggestie, en niet een richtlijn als een robots.txt disallow regel zou op uw eigen site.John Mueller ’s verklaring was:” ik kon me in onze systemen voorstellen dat we na verloop van tijd zouden kunnen leren om ze iets anders te behandelen.”Dit zou kunnen verwijzen naar de gevallen waarin Google een nofollow behandelt als een suggestie. Hypothetisch, is het mogelijk dat de systemen van Google zou kunnen leren welke nofollowed links te volgen op basis van inzichten verzameld uit de soorten link gemarkeerd als ugc en gesponsord. Nogmaals, dit zou niet veel van een impact hebben op de ranglijsten van een site – maar het zou theoretisch een impact kunnen hebben op de site wordt gekoppeld te.

Callum Scott, Marie Haynes Consulting

.png)