fortiden, nutiden og fremtiden for Google PageRank

PageRank algoritme (eller PR for kort) er et system til ranking hjemmesider udviklet af Larry Page og Sergey Brin på Stanford University i slutningen af 90 ‘erne. PageRank var faktisk grundlaget side og Brin skabte Google søgemaskine på.

mange år er gået siden da, og selvfølgelig er Googles rangeringsalgoritmer blevet meget mere komplicerede. Er de stadig baseret på PageRank? Hvordan påvirker PageRank nøjagtigt rangeringen, og hvad skal SEO ‘ er gøre sig klar til i fremtiden? Nu skal vi finde og opsummere alle fakta og mysterier omkring PageRank for at gøre billedet klart. Så meget vi kan.

pageranks fortid

som nævnt ovenfor forsøgte Brin og Page i deres universitetsforskningsprojekt at opfinde et system til at estimere autoriteten af hjemmesider. De besluttede at bygge dette system på links, der tjente som tillid til en side. Ifølge logikken i denne mekanisme, jo flere eksterne ressourcer linker til en side, jo mere værdifulde oplysninger har den for brugerne. Og PageRank (en score fra 0 til 10 beregnet ud fra mængden og kvaliteten af indgående links) viste relativ autoritet på en side på internettet.

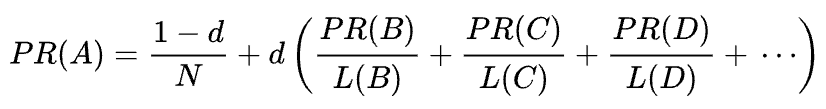

Original PageRank formel

lad os se på, hvordan PageRank fungerer. Hvert link fra en side (A) til en anden (B) afgiver en såkaldt stemme, hvis vægt afhænger af den samlede vægt af alle de sider, der linker til side A. Og vi kan ikke kende deres vægt, før vi beregner det, så processen går i cyklusser.

den matematiske formel for den oprindelige PageRank er følgende:

hvor A, B, C og D er nogle sider, L er antallet af links, der går ud fra hver af dem, og N er det samlede antal sider i samlingen (dvs.på internettet).

hvad angår d, er d den såkaldte dæmpningsfaktor. I betragtning af at PageRank beregnes, der simulerer adfærden hos en bruger, der tilfældigt kommer til en side og klikker på links, anvender vi denne dæmpende d-faktor som sandsynligheden for, at brugeren keder sig og forlader en side.

som du kan se fra formlen, hvis der ikke er nogen sider, der peger på siden, vil dens PR ikke være nul, men

da der er en sandsynlighed for, at brugeren kunne komme til denne side ikke fra nogle andre sider, men sige fra bogmærker.

PageRank manipulation sårbarhed og Googles krig mod link spam

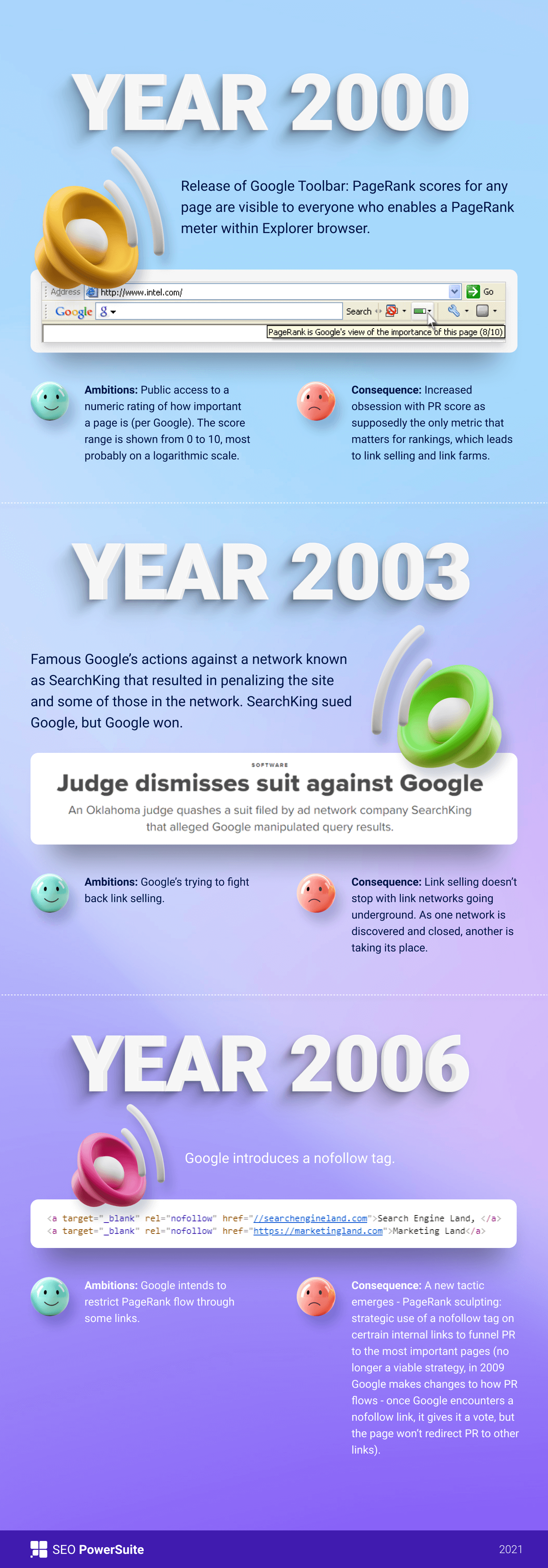

først var PageRank score offentligt synlig i Google Toolbar, og hver side havde sin score fra 0 til 10, sandsynligvis på en logaritmisk skala.

Googles rankingalgoritmer af disse tider var virkelig enkle-høj PR og søgeordstæthed var de eneste to ting, en side havde brug for for at rangere højt på en SERP. Som et resultat blev hjemmesider fyldt med nøgleord, og hjemmesideejere begyndte at manipulere PageRank ved kunstigt at vokse spammy backlinks. Det var let at gøre — link gårde og link salg var der for at give hjemmeside ejere en “hjælpende hånd.”

Google besluttede at bekæmpe link spam tilbage. I 2003 straffede Google hjemmesiden for annoncenetværksfirmaet SearchKing for linkmanipulationer. SearchKing sagsøgte Google, men Google vandt. Det var en måde, Google forsøgte at begrænse alle fra linkmanipulationer, men det førte til intet. Link gårde lige gik under jorden, og deres mængde ganget kraftigt.

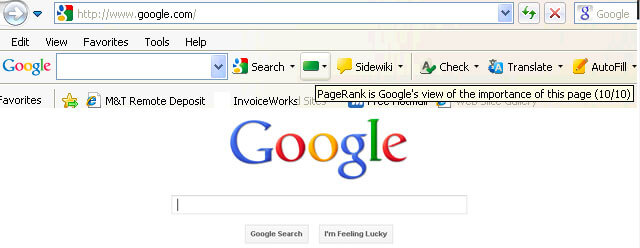

desuden spammy kommentarer på blogs ganget, også. Bots angreb kommentarerne fra enhver blog og efterlod et enormt antal” klik her for at købe magiske piller ” kommentarer. For at forhindre spam og PR-manipulation i kommentarer introducerede Google nofølg-tagget i 2005. Og endnu en gang, hvad Google mente at blive et vellykket skridt i linkmanipulationskrigen blev implementeret på en snoet måde. Folk begyndte at bruge nofølg tags til kunstigt tragt PageRank til de sider, de havde brug for. Denne taktik blev kendt som PageRank sculpting.

for at forhindre pr-skulptur ændrede Google den måde, PageRank flyder på. Tidligere, hvis en side havde både nofølg og dofølg links, blev al PR-volumen på siden sendt til andre sider, der er knyttet til med dofølg-linkene. I 2009 begyndte Google at dele en sides PR ligeligt mellem alle de links, siden havde, men kun videregive de aktier, der blev givet til dofølg-linkene.

udført med PageRank sculpting stoppede Google ikke link spam-krigen og begyndte derfor at tage PageRank score ud af offentlighedens øjne. Først lancerede Google Den nye Chrome-bro. ser uden Google Toolbar, hvor PR-score blev vist. Derefter ophørte de med at rapportere PR-score i Google Search Console. Derefter stoppede Google Toolbar med at understøtte Google Toolbar. I 2013 blev PageRank opdateret til Internetudforsker for sidste gang, og i 2016 lukkede Google officielt værktøjslinjen for offentligheden.

endnu en måde Google bruges til at bekæmpe link ordninger var Penguin update, som de-rangeret hjemmesider med fishy backlink profiler. Rullet ud i 2012 blev Penguin ikke en del af Googles realtidsalgoritme, men var snarere et “filter” opdateret og genanvendt til søgeresultaterne nu og da. Hvis en hjemmeside blev straffet af Penguin, måtte SEO ‘ er omhyggeligt gennemgå deres linkprofiler og fjerne giftige links eller føje dem til en afvisningsliste (en funktion introducerede de dage for at fortælle Google, hvilke indgående links der skal ignoreres ved beregning af PageRank). Efter at have revideret linkprofiler på den måde, SEO ‘ er måtte vente i et halvt år eller deromkring, indtil Penguin-algoritmen genberegner dataene.

i 2016 gjorde Google Penguin til en del af sin kerneplaceringsalgoritme. Siden da har det arbejdet i realtid, algoritmisk beskæftiger sig med spam langt mere succesfuldt.

samtidig arbejdede Google på at lette kvalitet snarere end kvantitet af links og spikede det ned i sine kvalitetsretningslinjer mod linkordninger.

nutiden af PageRank

Nå, vi er færdige med fortiden af PageRank. Hvad sker der nu?

tilbage i 2019 sagde en tidligere Google-medarbejder, at den oprindelige PageRank-algoritme ikke havde været i brug siden 2006 og blev erstattet med en anden mindre ressourceintensiv algoritme, da internettet blev større. Det kan godt være sandt, da Google i 2006 indgav den nye, der producerede en rangordning for sider, der bruger afstande i et NetLink grafpatent.

anvendes PageRank-algoritmen i dag?

ja, det er det. Det er ikke den samme PageRank som den var i begyndelsen af 2000 ‘ erne, men Google fortsætter med at stole på link authority stærkt. For eksempel nævnte en tidligere Google-medarbejder Andrey Lipattsev dette i 2016. I en Google&et hangout spurgte en bruger ham, hvad var de vigtigste rangeringssignaler, som Google brugte. Andreys svar var ret ligetil.

jeg kan fortælle dig, hvad de er. Det er indhold og links, der peger på din hjemmeside.

Andrey Lipattsev

i 2020 bekræftede John Mueller det igen:

Ja, Vi bruger PageRank internt, blandt mange, mange andre signaler. Det er ikke helt det samme som det originale papir, der er masser af særheder (f.eks.), og igen bruger vi mange andre signaler, der kan være meget stærkere.

John Mueller

som du kan se, lever PageRank stadig og bruges aktivt af Google, når du rangerer sider på nettet.

det, der er interessant, er, at Google-medarbejdere fortsat minder os om, at der er mange, mange, mange andre rangeringssignaler. Men vi ser på dette med et saltkorn. I betragtning af hvor meget indsats Google har brugt til at bekæmpe linkspam, kan det være af Googles interesse at skifte SEOs opmærksomhed fra de manipulationssårbare faktorer (som backlinks er) og drive denne opmærksomhed mod noget uskyldigt og pænt. Men da SEO ‘ er er gode til at læse mellem linjerne, overvejer de fortsat PageRank et stærkt rangeringssignal og vokser backlinks på alle måder, de kan. De bruger stadig PBNs, øve nogle grå-hat differentieret link bygning, købe links, og så videre, ligesom det var for længe siden. Som PageRank lever, link spam vil leve, også. Vi anbefaler ikke noget af det, men det er hvad SEO-virkeligheden er, og vi er nødt til at forstå det.

tilfældig Surfer vs. rimelige Surfermodeller af PageRank

Nå, du fik ideen om, at PageRank nu ikke er den PageRank, den var for 20 år siden.

en af de vigtigste moderniseringer af PR flyttede fra den kort nævnt ovenfor tilfældige Surfermodel til den rimelige Surfermodel i 2012. Rimelig Surfer antager, at brugerne ikke opfører sig kaotisk på en side, og klik kun på de links, de er interesseret i i øjeblikket. Sig, når du læser en blogartikel, er det mere sandsynligt, at du klikker på et link i artiklens indhold snarere end et link til brugsbetingelser i sidefoden.

Derudover kan rimelig Surfer potentielt bruge en lang række andre faktorer, når man vurderer et link tiltrækningskraft. Alle disse faktorer blev omhyggeligt gennemgået af Bill Slavski i sin artikel, men jeg vil gerne fokusere på de to faktorer, som SEO ‘ er diskuterer oftere. Disse er link position og side trafik. Hvad kan vi sige om disse faktorer?

korrelation mellem linkposition og linkautoritet

et link kan være placeret hvor som helst på siden — i dens indhold, navigationsmenu, forfatterens biografi, sidefod og faktisk ethvert strukturelt element, siden indeholder. Og forskellige linkplaceringer påvirker linkværdien. John Mueller bekræftede det, siger, at links placeret i hovedindholdet vejer mere end alle de andre:

dette er det område på siden, hvor du har dit primære indhold, det indhold, som denne side faktisk handler om, ikke menuen, sidebjælken, sidefoden, overskriften… så er det noget, vi tager højde for, og vi prøver at bruge disse links.

John Mueller

så sidefod links og navigation links siges at passere mindre vægt. Og denne kendsgerning fra tid til anden bliver bekræftet ikke kun af Google-talsmænd, men af virkelige sager.

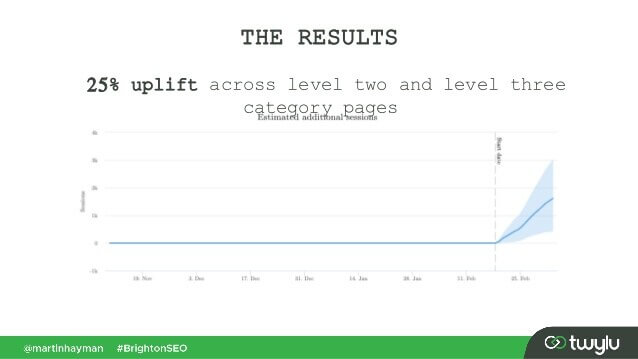

i en nylig sag præsenteret af Martin Hayman på BrightonSEO tilføjede Martin det link, han allerede havde i sin navigationsmenu, til sidernes hovedindhold. Som et resultat oplevede disse kategorisider og de sider, de linkede til, en 25% trafikopløftning.

dette eksperiment beviser, at indholdslinks passerer mere vægt end nogen anden.

hvad angår linkene i forfatterens bio, antager SEO ‘ er, at biolinks vejer noget, men er mindre værdifulde end f.eks. Selvom vi ikke har meget bevis her, men for hvad Matt Cutts sagde, da Google aktivt kæmpede for overdreven gæsteblogging for backlinks.

korrelation mellem trafik, brugeradfærd og linkautoritet

John Mueller præciserede, hvordan Google behandler trafik og brugeradfærd med hensyn til at overføre linkjuice i et af Search Console centrale hangouts. En bruger spurgte Mueller, Om Google overvejer kliksandsynlighed og antallet af linkklik, når de vurderer kvaliteten af et link. De vigtigste grillbarer fra Muellers svar var:

-

Google overvejer ikke link klik og klik sandsynlighed, når de vurderer kvaliteten af linket.

-

Google forstår, at links ofte føjes til indhold som referencer, og brugere forventes ikke at klikke på hvert link, de støder på.

som altid tvivler SEO ‘ er stadig på, om det er værd at blindt tro på alt, hvad Google siger, og fortsæt med at eksperimentere. Så fyre fra Ahrefs gennemførte en undersøgelse for at kontrollere, om en sides position på en SERP er forbundet med antallet af backlinks, den har fra sider med høj trafik. Undersøgelsen viste, at der næppe er nogen sammenhæng. Desuden viste nogle toprangerede sider sig slet ikke at have backlinks fra trafikrige sider.

denne undersøgelse peger os i en lignende retning som John Muellers ord – du behøver ikke at opbygge trafikgenererende backlinks til din side for at få høje positioner på en SERP. På den anden side har ekstra trafik aldrig gjort nogen skade på nogen hjemmeside. Den eneste besked her er, at trafikrige backlinks ikke ser ud til at påvirke Google-placeringer.

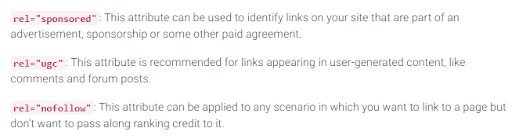

Nofølg, sponsoreret, og UGC tags

som du husker, Google introducerede nofølg tag i 2005 som en måde at bekæmpe link spam. Har noget ændret sig i dag? Faktisk, ja.

for det første har Google for nylig introduceret yderligere to typer af attributten nofølg. Før det foreslog Google at markere alle de backlinks, du ikke ønsker at deltage i PageRank-beregning, som ingenfølg, det være sig blogkommentarer eller betalte annoncer. I dag anbefaler Google at bruge rel=” sponsoreret”til betalte og tilknyttede links og rel=” ugc ” til brugergenereret indhold.

det er interessant, at disse nye tags ikke er obligatoriske (i det mindste endnu ikke), og Google påpeger, at du ikke behøver manuelt at ændre alle rel=”nofølg” til rel=”sponsoreret” og rel=”ugc”. Disse to nye attributter fungerer nu på samme måde som et almindeligt nofølg-tag.

for det andet siger Google nu, at nofølg-tags såvel som de nye, sponsoreret og ugc, behandles som tip snarere end et direktiv, når man indekserer sider.

udgående links og deres indflydelse på placeringer

ud over indgående links er der også udgående links, dvs.links, der peger på andre sider fra din.

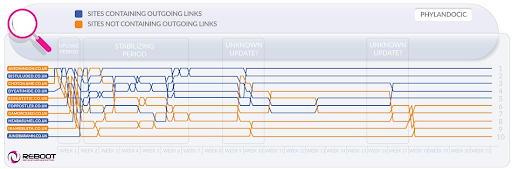

mange SEO ‘ er mener, at udgående links kan påvirke placeringer, men denne antagelse er blevet behandlet som en SEO-myte. Men der er en interessant undersøgelse at se på i denne henseende.

Reboot Online gennemførte et eksperiment i 2015 og kørte det igen i 2020. De ønskede at finde ud af, om tilstedeværelsen af udgående links til sider med høj autoritet påvirkede sidens position på en SERP. De skabte 10 hjemmesider med 300-ord artikler, alle optimeret til en ikke – eksisterende søgeord-Phylandocic. 5 hjemmesider blev efterladt uden udgående links overhovedet, og 5 hjemmesider indeholdt udgående links til ressourcer med høj autoritet. Som følge heraf begyndte disse hjemmesider med autoritative udgående links at rangere højest, og de, der slet ikke havde nogen links, tog de laveste positioner.

på den ene side kan resultaterne af denne forskning fortælle os, at udgående links påvirker sidernes positioner. På den anden side er søgeudtrykket i forskningen helt nyt, og indholdet af hjemmesiderne er tema omkring medicin og medicin. Så der er store chancer for, at forespørgslen blev klassificeret som YMYL. Og Google har mange gange udtalt betydningen af E-A-T for YMYL hjemmesider. Så outlinks kan godt være blevet behandlet som et E-A-T-signal, hvilket viser, at siderne har faktisk nøjagtigt indhold.

med hensyn til almindelige forespørgsler (ikke YMYL) har John Mueller mange gange sagt, at du ikke behøver at være bange for at linke til ydre kilder fra dit indhold, da udgående links er gode for dine brugere.

desuden kan udgående links også være gavnlige for SEO, da de kan tages i betragtning af Google AI, når du filtrerer internettet fra spam. Fordi spammy sider har tendens til at have få udgående links, hvis nogen overhovedet. De linker enten til siderne under det samme domæne (hvis de nogensinde tænker på SEO) eller indeholder kun betalte links. Så hvis du linker til nogle troværdige ressourcer, viser du slags Google, at din side ikke er en spammy.

der var engang en opfattelse af, at Google kunne give dig en manuel straf for at have for mange udgående links, men John Mueller sagde, at dette kun er muligt, når de udgående links naturligvis er en del af en eller anden linkudvekslingsordning, plus hjemmesiden er generelt af dårlig kvalitet. Hvad Google mener under indlysende er faktisk et mysterium, så husk sund fornuft, indhold af høj kvalitet og grundlæggende SEO.

Google kamp mod link spam

så længe PageRank eksisterer, vil SEO ‘ er lede efter nye måder at manipulere det på.

tilbage i 2012 var det mere sandsynligt, at Google frigav manuelle handlinger til linkmanipulation og spam. Men nu, med sine veluddannede anti-spam algoritmer, Google er i stand til bare at ignorere visse spammy links ved beregning PageRank snarere end nedranking hele hjemmesiden generelt. Som John Mueller sagde,

tilfældige links indsamlet gennem årene er ikke nødvendigvis skadelige, vi har også set dem i lang tid og kan ignorere alle de underlige stykker af graffiti fra længe siden.

John Mueller

dette gælder også for negativ SEO, når din backlink-profil kompromitteres af dine konkurrenter:

generelt tager vi automatisk disse i betragtning, og vi forsøger at… ignorere dem automatisk, når vi ser dem ske. For det meste formoder jeg, at det fungerer ret godt. Jeg ser meget få mennesker med faktiske problemer omkring det. Så jeg tror, det fungerer for det meste godt. Med hensyn til at afvise disse links, formoder jeg, at hvis disse bare er normale spammy links, der bare dukker op til din hjemmeside, så ville jeg ikke bekymre mig om dem for meget. Sandsynligvis regnede vi det ud på egen hånd.

John Mueller

det betyder dog ikke, at du ikke har noget at bekymre dig om. Hvis din hjemmesides backlinks bliver ignoreret for meget og for ofte, har du stadig en stor chance for at få en manuel handling. Som Marie Haynes siger i sit råd om link management i 2021:

manuelle handlinger er forbeholdt tilfælde, hvor et ellers anstændigt sted har unaturlige links, der peger på det i en skala, der er så stor, at Googles algoritmer ikke er behagelige at ignorere dem.

Marie Haynes

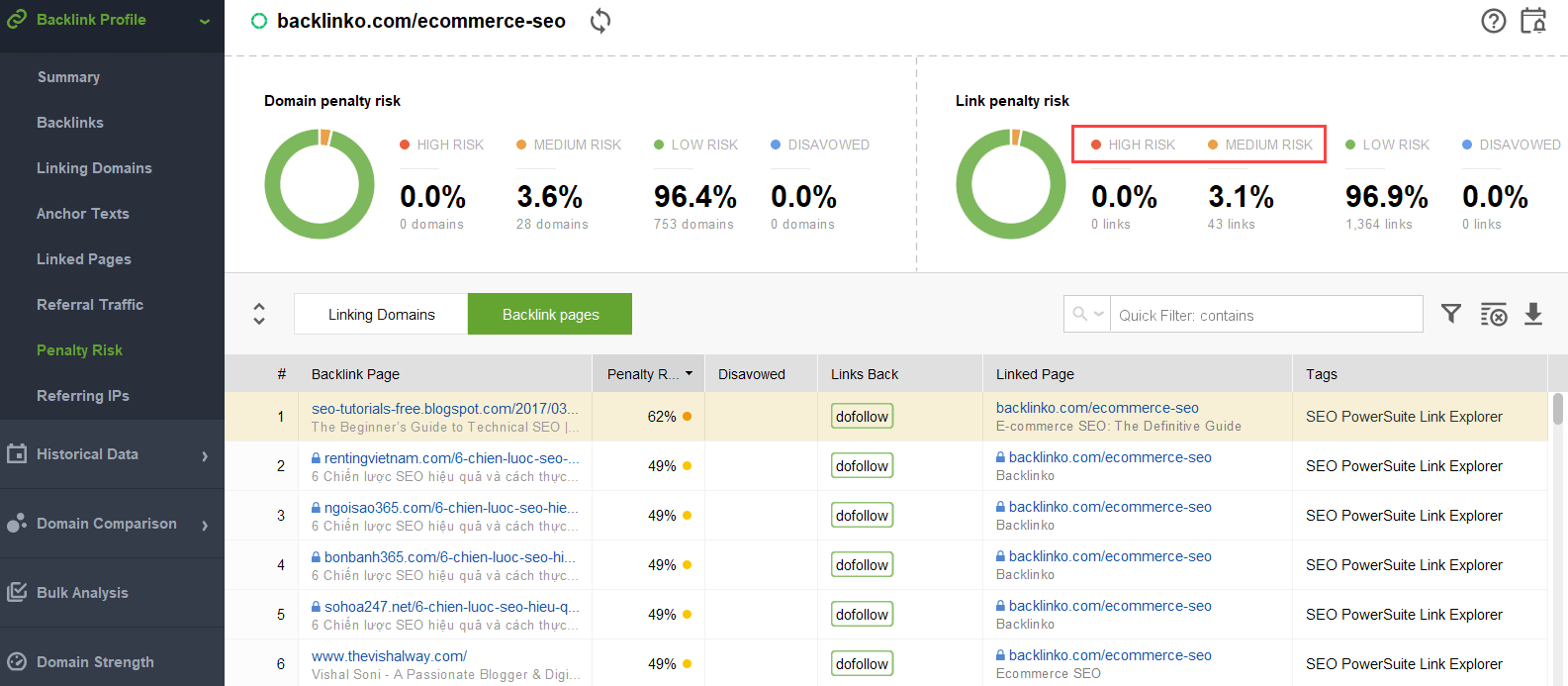

for at prøve at finde ud af, hvilke links der udløser problemet, kan du bruge en backlink-checker som SEO SpyGlass. I værktøjet skal du gå til Backlink Profile > Strafrisiko sektion. Vær opmærksom på backlinks med høj og mellemrisiko.

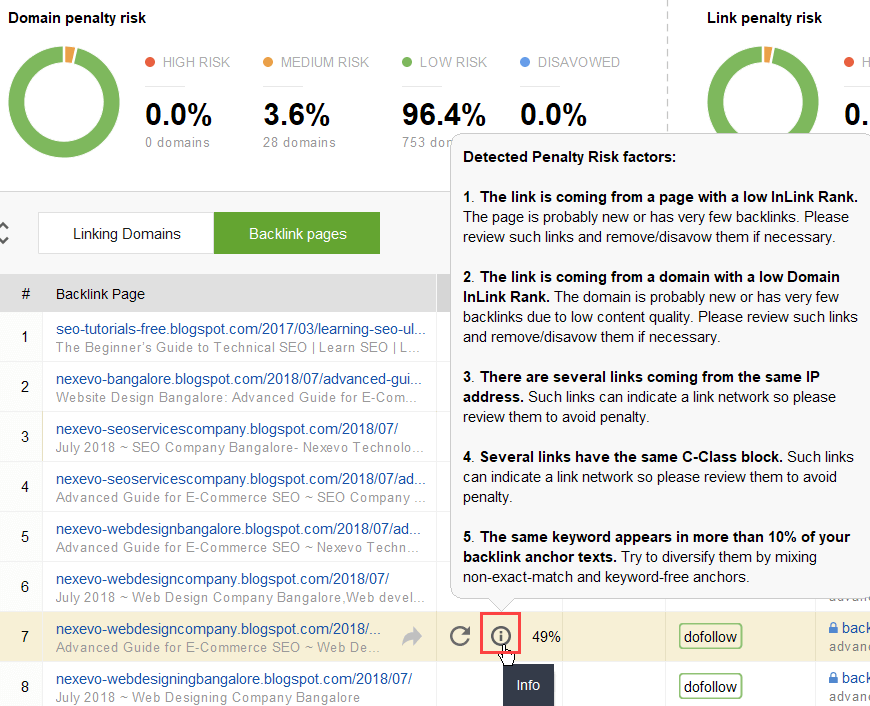

for yderligere at undersøge, hvorfor dette eller det pågældende link rapporteres som skadeligt, skal du klikke på i-loggen i kolonnen Strafrisiko. Her vil du se, hvorfor værktøjet betragtede linket dårligt og beslutte dig for, om du ville afvise et link eller ej.

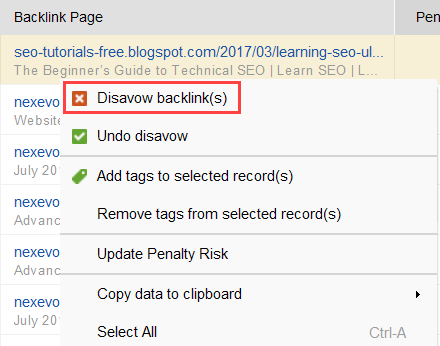

hvis du beslutter at afvise et link til en gruppe af links, skal du højreklikke på dem og vælge afvise backlink (s) mulighed:

når du har dannet en liste over links, der skal udelukkes, kan du eksportere afvisningsfilen fra SEO SpyGlass og sende den til Google via GSC.

intern sammenkædning

når vi taler om PageRank, kan vi ikke andet end nævne intern sammenkædning. Den indkommende PageRank er en slags ting, vi ikke kan kontrollere, men vi kan helt kontrollere, hvordan PR spredes på vores hjemmesides sider.

Google har også udtalt vigtigheden af intern sammenkædning mange gange. John Mueller understregede dette igen i et af de nyeste Search Console Central hangouts. En bruger spurgte, hvordan man gør nogle hjemmesider mere magtfulde. Og John Mueller sagde følgende:

…Du kan hjælpe med intern sammenkædning. Så inden for din hjemmeside kan du virkelig fremhæve de sider, du vil have fremhævet mere, og sørg for, at de er rigtig godt forbundet internt. Og måske de sider, du ikke finder så vigtige, skal du sørge for, at de er lidt mindre forbundet internt.

John Mueller

intern sammenkædning betyder meget. Det hjælper dig med at dele indgående PageRank mellem forskellige sider på din hjemmeside og dermed styrke dine underpresterende sider og gøre din hjemmeside stærkere generelt.

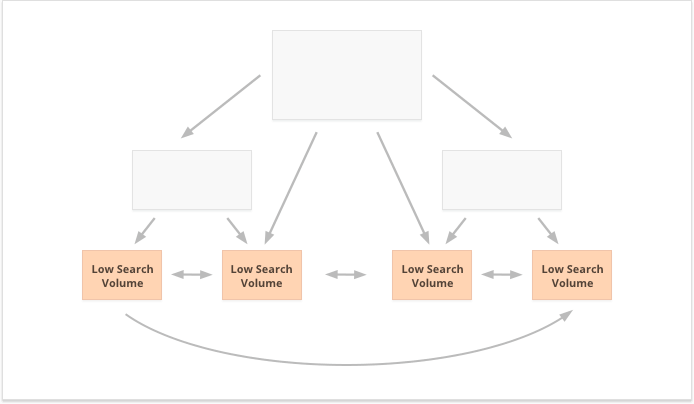

hvad angår tilgange til intern sammenkædning, har SEO ‘ er mange forskellige teorier. En populær tilgang er relateret til hjemmeside klik dybde. Denne ide siger, at alle sider på din hjemmeside skal være på en maksimal 3-Klik afstand fra hjemmesiden. Selvom Google har understreget betydningen af lavvandet hjemmeside struktur mange gange, også, i virkeligheden synes dette utilgængelig for alle de større-end-små hjemmesider.

en yderligere tilgang er baseret på begrebet centraliseret og decentraliseret intern forbindelse. Som Kevin Indig beskriver det:

centraliserede steder har en enkelt brugerstrøm og tragt, der peger på en nøgleside. Sites med decentral intern sammenkædning har flere konvertering touchpoints eller forskellige formater til tilmelding.

Kevin Indig

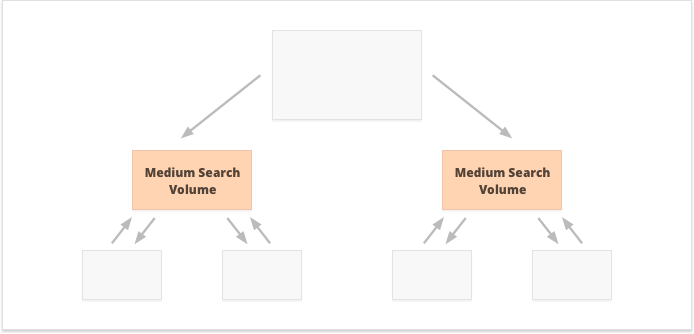

i tilfælde af centraliseret intern sammenkædning har vi en lille gruppe konverteringssider eller en side, som vi vil være magtfulde. Hvis vi anvender decentraliseret intern sammenkædning, ønsker vi, at alle hjemmesidens sider skal være lige så magtfulde og have lige PageRank for at få dem alle til at rangere for dine forespørgsler.

hvilken mulighed er bedre? Det hele afhænger af din hjemmeside og business niche særegenheder, og på de søgeord, du kommer til at målrette. For eksempel passer centraliseret intern sammenkædning bedre til søgeord med høje og mellemstore søgevolumener, da det resulterer i et smalt sæt superkraftige sider.

langhale nøgleord med lav søgevolumen er tværtimod bedre til decentral intern sammenkædning, da det spreder PR ligeligt blandt adskillige hjemmesidesider.

et yderligere aspekt af vellykket intern sammenkædning er balancen mellem indgående og udgående links på siden. I denne henseende bruger mange SEO ‘ er CheiRank (CR), som faktisk er en invers PageRank. Men mens PageRank er den modtagne magt, CheiRank er den linkstyrke, der er givet væk. Når du har beregnet PR og CR for dine sider, kan du se, hvilke sider der har linkanomalier, dvs.de tilfælde, hvor en side modtager en masse PageRank, men passerer lidt længere, og omvendt.

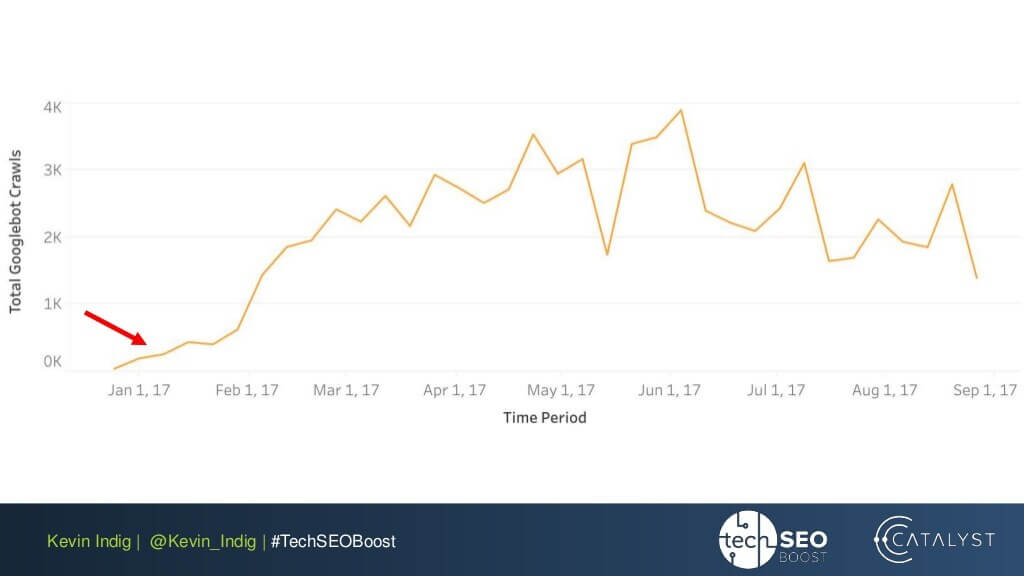

et interessant eksperiment her er Kevin Indig ‘ s udfladning af link anomalier. Du skal blot sørge for indgående og udgående PageRank er afbalanceret på hver side af hjemmesiden bragt meget imponerende resultater. Den røde pil her peger på det tidspunkt, hvor anomalierne blev rettet:

Linkanomalier er ikke det eneste, der kan skade PageRank-strømmen. Sørg for, at du ikke sidder fast med tekniske problemer, som kan ødelægge din hårdt tjente PR:

-

forældreløse sider. Orphan sider er ikke knyttet til nogen anden side på din hjemmeside, således de bare sidde inaktiv og ikke modtager nogen link juice. Google kan ikke se dem og ved ikke, at de faktisk eksisterer.

-

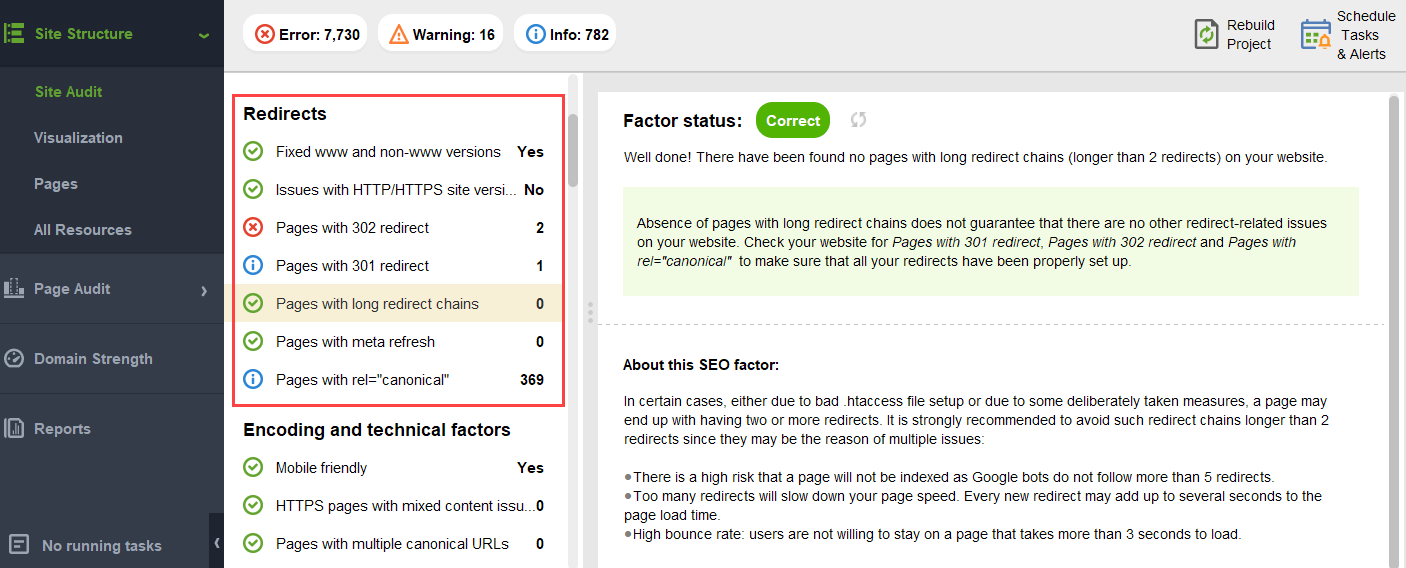

omdirigere kæder. Selvom Google siger, at omdirigeringer nu passerer 100% af PR, anbefales det stadig at undgå lange omdirigeringskæder. Først spiser de alligevel dit gennemsøgningsbudget. For det andet ved vi, at vi ikke blindt kan tro på alt, hvad Google siger.

-

Links i unparseable JavaScript. Da Google ikke kan læse dem, vil de ikke passere PageRank.

-

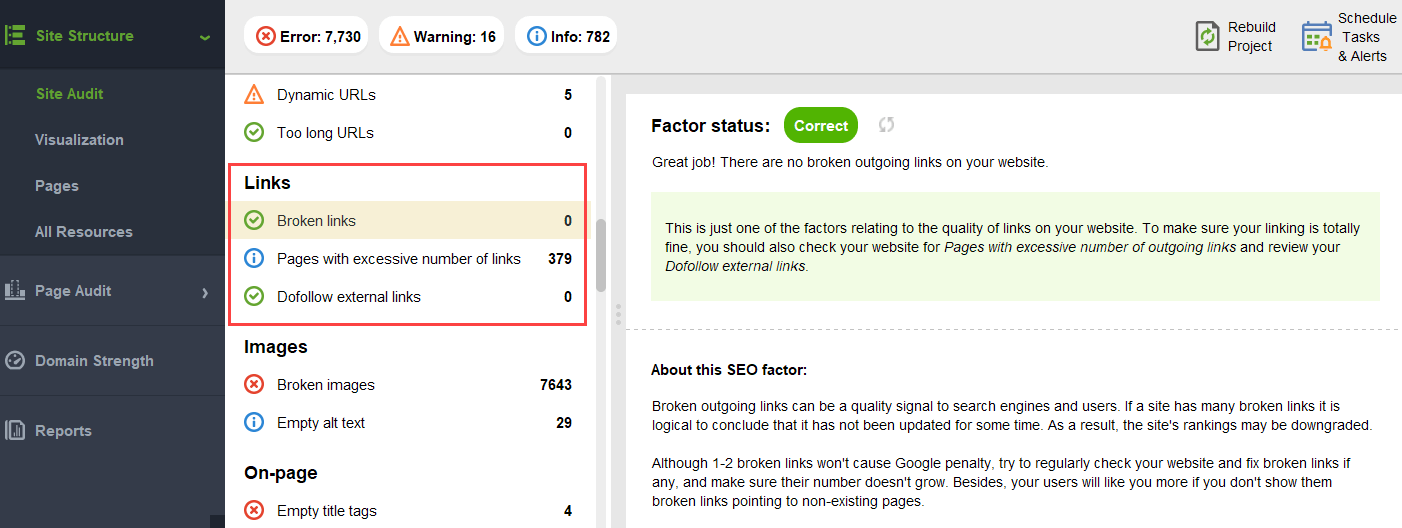

404 links. 404 links fører til ingen steder, så PageRank går ingen steder også.

-

Links til uvæsentlige sider. Selvfølgelig kan du ikke efterlade nogen af dine sider uden links overhovedet, men sider oprettes ikke ens. Hvis en side er mindre vigtig, er det ikke rationelt at lægge for meget på at optimere linkprofilen på den side.

-

for fjerne sider. Hvis en side er placeret for dybt på din hjemmeside, vil den sandsynligvis modtage lidt PR eller slet ingen PR. Da Google muligvis ikke formår at finde og indeksere det.

for at sikre din hjemmeside er fri for disse PageRank farer, du kan revidere det med hjemmesiden revisor. Dette værktøj har et omfattende sæt moduler inden for Site Structure > Site Audit sektion, som lader dig kontrollere den samlede optimering af din hjemmeside, og, selvfølgelig, finde og løse alle de link-relaterede spørgsmål, såsom lange omdirigeringer:

og brudte links:

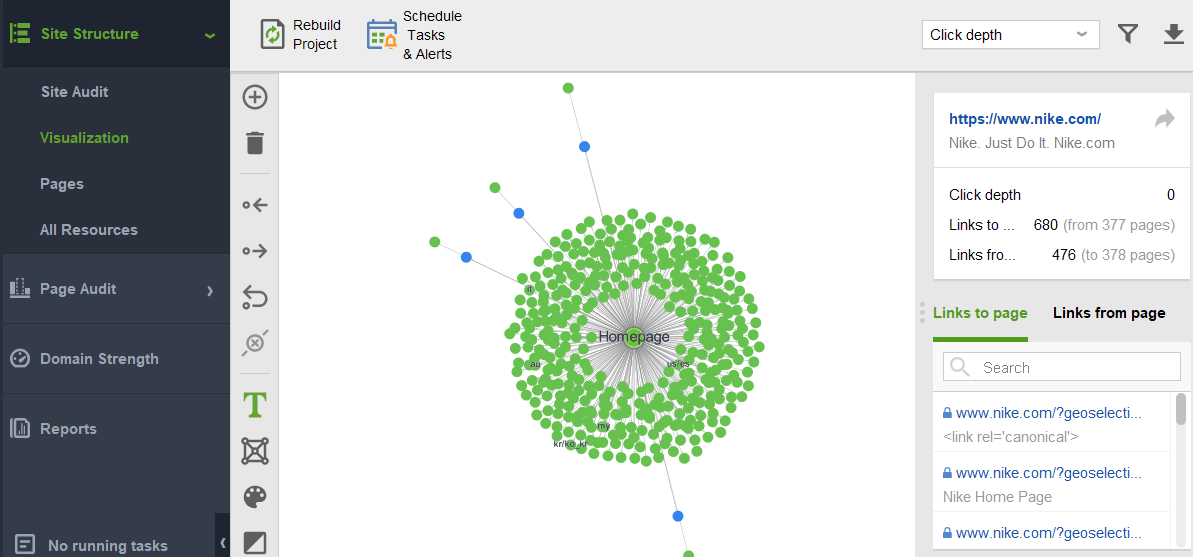

for at tjekke din hjemmeside for forældreløse sider eller sider, der er for fjernt, skal du skifte til Site Structure > visualisering:

fremtiden for PageRank

i år PageRank er fyldt 23. Og jeg tror, det er ældre end nogle af vores læsere i dag:) men hvad kommer PageRank i fremtiden? Vil det helt forsvinde en dag?

søgemaskiner uden backlinks

når jeg prøver at tænke på en populær søgemaskine, der ikke bruger backlinks i deres algoritme, er den eneste ide, jeg kan komme med, Yandeks-eksperimentet tilbage i 2014. Søgemaskinen meddelte, at droppe backlinks fra deres algoritme kan endelig stoppe link spammere fra manipulationer og hjælpe med at rette deres indsats til kvalitet hjemmeside skabelse.

det kunne have været en ægte indsats for at bevæge sig mod alternative ranking faktorer, eller bare et forsøg på at overtale masserne til at droppe link spam. Men under alle omstændigheder, på bare et år fra meddelelsen, Yandeks bekræftede backlink-faktorer var tilbage i deres system.

men hvorfor er backlinks så uundværlige for søgemaskiner?

mens der er utallige andre datapunkter til at omarrangere søgeresultater efter at have vist dem (som brugeradfærd og Bert-justeringer), forbliver backlinks et af de mest pålidelige autoritetskriterier, der er nødvendige for at danne den oprindelige SERP. Deres eneste konkurrent her er sandsynligvis enheder.

som Bill Slavski udtrykker det, når han bliver spurgt om pageranks fremtid:

Google undersøger maskinindlæring og faktaudvinding og forståelse af nøgleværdipar for forretningsenheder, hvilket betyder en bevægelse mod semantisk søgning og bedre brug af strukturerede data og datakvalitet.

Bill Slavski, SEO ved havet

alligevel er Google helt i modsætning til at kassere noget, de har investeret i mange års udvikling.

Google er meget god til linkanalyse, som nu er en meget moden Internetteknologi. På grund af det er det meget muligt, at PageRank fortsat vil blive brugt til at rangere organiske SERP ‘ er.

Bill Slavski, SEO ved havet

Nyheder og andre tidsfølsomme resultater

en anden tendens, som Bill Slavski pegede på, var Nyheder og andre kortvarige typer søgeresultater:

Google har fortalt os, at det har påberåbt sig mindre PageRank for sider, hvor aktualitet er vigtigere, såsom realtime resultater (som fra kvidre), eller fra nyheder resultater, hvor aktualitet er meget vigtigt.

Bill Slavski, SEO ved havet

faktisk lever et stykke nyheder i søgeresultaterne alt for lidt til at akkumulere nok backlinks. Så Google har været og kan fortsætte med at arbejde for at erstatte backlinks med andre rankingfaktorer, når de beskæftiger sig med nyheder.

men som for nu er nyhedsrangeringer stærkt bestemt af forlagets nichemyndighed, og vi læser stadig autoritativitet som backlinks:

“Autoritativitetssignaler hjælper med at prioritere information af høj kvalitet fra de mest pålidelige tilgængelige kilder. For at gøre dette, vores systemer er designet til at identificere signaler, der kan hjælpe med at bestemme, hvilke sider der viser ekspertise, autoritativitet og troværdighed om et givet emne, baseret på feedback fra søgere. Disse signaler kan omfatte, om andre mennesker værdsætter kilden til lignende forespørgsler, eller om andre fremtrædende hjemmesider om emnet linker til historien.”

ny rel=”sponsoreret” og rel=”UGC” attributter

sidst men ikke mindst blev jeg temmelig overrasket over den indsats, som Google har gjort for at kunne identificere sponsorerede og brugergenererede backlinks og skelne dem fra andre ikke-fulgte links.

hvis alle disse backlinks skal ignoreres, hvorfor pleje at fortælle hinanden? Især med John Muller, der antyder, at Google senere kan forsøge at behandle disse typer links forskelligt.

Mit vildeste gæt her var, at Google måske validerer, om reklame og brugergenererede links kan blive et positivt ranking signal.

når alt kommer til alt kræver reklame på populære platforme enorme budgetter, og enorme budgetter er en egenskab for et stort og populært brand.

brugergenereret indhold, når det overvejes uden for kommentarens spam-paradigme, handler om rigtige kunder, der giver deres virkelige påtegninger.

men de eksperter, jeg nåede ud til, troede ikke, det var muligt:

jeg tvivler på, at Google nogensinde ville betragte sponsorerede links som et positivt signal.

Barry Roundtable, søgemaskine Roundtable

ideen her, ser det ud til, er, at ved at skelne mellem forskellige typer links, ville Google forsøge at finde ud af, hvilke af de følgende links der skal følges til enhedsopbygningsformål:

Google har ikke noget problem med brugergenereret indhold eller sponsoreret indhold på en hjemmeside, men begge er historisk blevet brugt som metoder til at manipulere pagerank. Som sådan opfordres netadministratorer til at placere en attribut uden Følg på disse links (blandt andre grunde til at bruge nofølg).Imidlertid kan ingenfølgede links stadig være nyttige for Google for ting (som f.eks. enhedsgenkendelse), så de har tidligere bemærket, at de kan behandle dette som et mere forslag og ikke et direktiv som en robot.det ville være på dit eget sted.John Muellers erklæring var ” jeg kunne forestille mig i vores systemer, at vi måske lærer over tid at behandle dem lidt anderledes.”Dette kan henvise til de tilfælde, hvor Google behandler en nofølg som et forslag. Hypotetisk er det muligt, at Googles systemer kunne lære, hvilke ingenfølgede links der skal følges, baseret på indsigt indsamlet fra de typer link, der er markeret som ugc og sponsoreret. Igen bør dette ikke have stor indflydelse på et steds placering – men det kan teoretisk have indflydelse på, at siden også er linket.

Callum Scott, Marie Haynes Consulting

.png)